Jeroen Hetzler.

De modellen die het IPCC hanteert waarmee dit VN-werktuig van o.a. Maurice Strong het mondiale politieke en economische beleid in de door de VN en de EU voorgestane anti-kapitalistische sociaal-democratische richting wenst te sturen, mogen wel eens aan nadere beschouwing onderworpen worden. Laten we bijvoorbeeld kijken hoe de uitspraak van het IPCC in AR5 over de 95% betrouwbaarheid geïnterpreteerd moet worden dat de opwarming na 1950 voor zeker 50% door menselijk toedoen is veroorzaakt. Allereerst is niet duidelijk waar die 50% op is gebaseerd. Het is in elk geval opmerkelijk, omdat het IPCC elke natuurlijke invloed uitsloot krachtens zijn mandaat. Is hier sprake van een paradigmaverschuiving? Geen idee.

Laten we nu kijken wat met die 95% betrouwbaarheid of betrouwbaarheidsinterval (BI) wordt bedoeld. De wetenschappelijke methode gaat als volgt. Eerst wordt een zogeheten nulhypothese geformuleerd bij bijvoorbeeld de test op het effect van een nieuw medicijn, het catastrofale effect van menselijke CO2-emissie op de mondiale temperatuur. U ziet in het woord ‘catastrofale’ al een verschil dat te denken moet geven omdat dit een a priori aanname lijkt waar elke definitie ontbreekt. De nulhypothese stelt: er gaat geen significante verbetering uit van het nieuwe medicijn ten opzichte van de situatie zonder dit medicijn, tenzij door falsificatie ten gunste van de alternatieve hypothese: het nieuwe medicijn geeft een significante verbetering. Dit antwoord blijkt na toetsing d.m.v. metingen. Hierover later meer. Wat betreft de CAGW-hypothese (Anthropogenic Global Warming; door de mens veroorzaakte catastrofale opwarming) wordt het drabbig. Immers, Al Gore vertoonde zijn film, ‘An Incovenient Truth’, als een zekerheid, niet als een hypothese, en sloeg de toetsing van de nulhypothese over, maar deed deze a priori af als gefalsificeerd. Dit is iets wat je wel vaker uit de mond van alarmisten hoort, maar uiteindelijk blijkt het een teruggrijpen op het Voorzorgprincipe, niet op de wetenschappelijk methode van statistiek. Dit zand in de ogen strooien is waar de hoax van de ‘science is settled’ op vegeteert. Dit wordt onderstreept door het commentaar van Trenberth 2011 met dit als antwoord van Curry.

De knullige vraag van Trenberth, namelijk bewijzen dat het niet zo is, doet denken aan de paranormale wereld waarin men met doden spreekt, door buitenaardse wezens is ontvoert, Ogilvie en Geller, waar deze vraag schering en inslag is. Nee, de bewijslast ligt echt bij degene die de nulhypothes in twijfel trekken.

Er is sprake van de volgende nul-hypothese: klimaatveranderingen worden door natuurlijke krachten veroorzaakt. Deze staan tegenover de alternatieve hypothese, namelijk dat de huidige klimaatverandering van antropogene aard is. Logischerwijs ligt de bewijslast bij de alarmisten om aan te tonen dat de nul-hypothese niet in staat is om de empirische data te verklaren, en daarmee verworpen is ten gunste van de alternatieve hypothese. Met andere woorden: alarmisten zullen met overtuigende meetgegevens moeten komen als bewijs voor de catastrofale antropogene klimaatverandering (CAGW). Zij moeten dit doen door gedetailleerde vergelijking van de data met de klimaatmodellen. Dit is natuurlijk uiterst moeilijk en praktisch onmogelijk, daar men de natuurlijke invloeden bij lange niet voldoende exact kan specificeren, omdat deze verre van doorgrond zijn. Zo is de werking van wolkenvorming weinig verklaard. Hier kom ik later op terug.

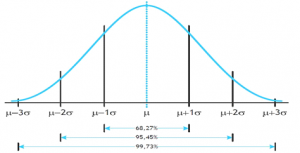

Bovendien is naast de formulering van een nulhypothese ook de formulering van een betrouwbaarheidsinterval nodig. Wat moet ik mij hierbij voorstellen? Stel, er is een verdeling van sterfte door een specifieke infectieziekte rond een gemiddeld sterftecijfer. Hoe die spreiding rond het gemiddelde (μ) is, wordt uitgedrukt door het symbool σ (sigma; hoe groot dit is, is te berekenen). Stel dat ik door een nieuw medicijn het sterftecijfer significant omlaag meen te krijgen. Dit moet ik toetsen. Vallen de meetresultaten binnen een bepaalde marge, dan levert dat nieuwe medicijn geen significant verschil op. Vallen ze erbuiten, dan wel en is de nulhypothese verworpen ten gunste van de alternatieve hypothese: het nieuwe medicijn werkt. Die marge heet betrouwbaarheidsinterval. Bij toetsing wordt gewoonlijk uitgegaan van +/-2 sigma. Dus iets meer dan 95% betrouwbaarheidsinterval (bij fysica maar liefst 5 sigma, 99,99% zoals bij het Higgs-deeltje). Dit houdt in dat in 95 van de 100 gevallen de testresultaten in dit gebied vallen, tenzij… (figuur 1)

… de resultaten minder sterfte aangeven dan μ-2σ, want dan kan de nulhypothese verworpen worden. Dit heet falsificatie of weerlegging. Hier is een praktijkgeval.

Aangezien het IPCC geen nulhypothese formuleert en er dus ook geen sprake is van toetsing in voornoemde zin, is de bewering in AR5 dat het extremely likely is als een zekerheid van 95%, misleidend en in werkelijkheid door handopsteken bepaald. Het was evenwel een meesterlijke PR- stunt waar de hele wereld met open ogen intrapte, omdat het lijkt op de zogenaamde betrouwbaarheidsintervallen uit de reguliere statistiek, maar in werkelijkheid slechts berust op handopsteken. Bovendien wekte het IPCC de onterechte indruk dat de wetenschap eruit is. De modellen van het IPCC zijn evenwel alle hypotheses die elk afzonderlijk moeten worden getoetst aan de hand van een toegemeten nulhypothese, elk met een eigen betrouwbaarheidsinterval. Zo lang dit niet is gebeurd (wat het geval is), kunnen de modellen geen representanten zijn van de werkelijkheid noch grond voor politiek beleid zijn. Thans is dit laatste slechts bepaald door handopsteken, omdat, nogmaals, de nulhypothese ontbreekt.

Ik citeer:

The IPCC has never ever defined a null hypothesis to build its case for human-caused global warming, even though all climate change is statistically based. That is flawed science. The null hypothesis above for climate change assumes that observed changes are caused by natural variability. If statistics prove it must be rejected, then the theory of human-caused global warming is strengthened. To go about testing the null hypothesis, compare any climate variable, like temperature rise – that overlaps times of natural variability with times thought human caused. IPCC AR5 says 1950 is the starting point where non-natural climate change effects begin to appear. Apply statistical analysis to data before and after 1950 and if the result is 95% or greater that the change is outside what natural variability allows then the null hypothesis – results are consistent with natural variability – must be rejected. That, of course, does not prove that human’s are the cause of climate change. It proves that climate change is outside the range of natural variability. In the world of science, though, that is considered very strong support for the theory of human-caused global climate change, though not proven absolutely. Since AGW theory attributes rising atmospheric CO2 levels to climate change, then a direct link beyond what cannot be explained by natural variability must be established. That is a standard the IPCC has yet to meet. Instead of using the standard scientific approach to support the theory of human-cause climate change, the IPCC takes the opposite and entirely false approach. From its very first report the IPCC has always assumed all climate change is human-caused and seeks out data and builds mathematical modeling to support it. It’s a tainted approach that assumes true the very thing you are out to prove. That is both unscientific and illogical.

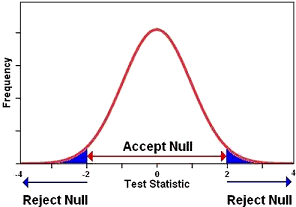

Ofwel: het IPPC had het ‘antwoord’ al klaar en scharrelt er de argumenten bij. Statistisch een doodzonde. Hier is hoe het zou moeten in toetsingen als hiervoor beschreven (figuur 2):

We zien weer het links en rechts 2 sigma-brede betrouwbaarheidsinterval. Een dergelijke toetsing volgens het boekje zou moeten zijn dat de gemeten temperaturen significant (hier dus > 2 sigma) hoger (= alternatieve hypothese) zouden moeten zijn dan op grond van de natuurlijke te verwachte temperaturen (≤ 2 sigma = nulhypothese).

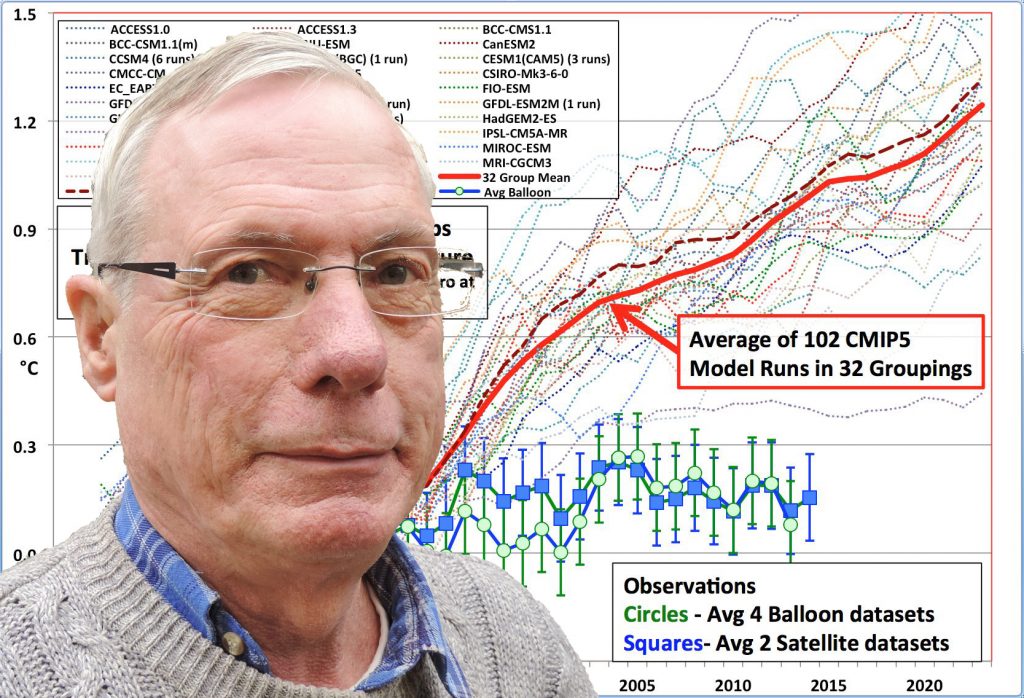

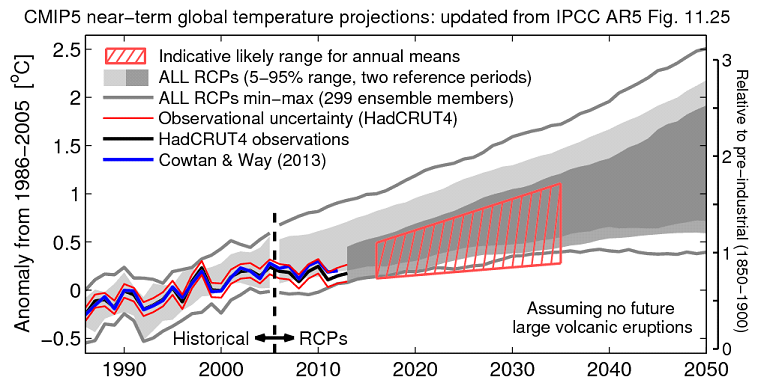

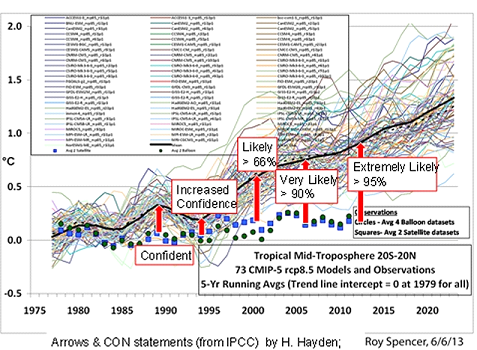

De IPCC-modellen onttrekken zich aan deze elementaire statistische toets. In plaats hiervan wordt de bekende waaier aan modellen ten tonele gevoerd alsmede een statistisch betekenisloze gemiddelde dat onvermijdelijk leidt tot deze misleidende grafische presentatie met een al even voos betrouwbaarheidsinterval. (figuur 3).

De suggestie wordt gewekt dat volgens de reguliere wetenschappelijke methode is gehandeld, net als dit het geval is bij homeopathie of bioresonantie, maar deze grafiek berust op het genoemde onzingegeven.

Can we apply this sort of thoughtful reasoning the spaghetti snarl of GCMs and their highly divergent results? You bet we can! First of all, we could stop pretending that “ensemble” mean and variance have any meaning whatsoever by not computing them. Why compute a number that has no meaning? Second, we could take the actual climate record from some “epoch starting point” — one that does not matter in the long run, and we’ll have to continue the comparison for the long run because in any short run from any starting point noise of a variety of sorts will obscure systematic errors — and we can just compare reality to the models. We can then sort out the models by putting (say) all but the top five or so into a “failed” bin and stop including them in any sort of analysis or policy decisioning whatsoever unless or until they start to actually agree with reality.

Vooralsnog presteerden de modellen zo slecht in hindcasting, dat er geen reden is ze aan te merken als leidend voor mondiaal beleid. Hier past het continue uit de pas lopen van de meetgegevens naadloos bij in het licht van het gestegen CO2-gehalte in de atmosfeer.

Let me repeat this.It has no meaning! It is indefensible within the theory and practice of statistical analysis. You might as well use a ouija board as the basis of claims about the future climate history as the ensemble average of different computational physical models that do not differ by truly random variations and are subject to all sorts of omitted variable, selected variable, implementation, and initialization bias. The board might give you the right answer, might not, but good luck justifying the answer it gives on some sort of rational basis.

De gemeten temperaturen vallen na elke IPCC-AR buiten het dan geldende door het IPCC genoemde “betrouwbaarheidsgebied”, dat echter bij gebrek aan een nulhypothese en correcte toetsing een betekenisloze term is. Onderstaande figuur 4 vat samen hoe het IPCC het imago van wetenschappelijkheid denkt op te houden. Voor alle duidelijkheid: er is dus sprake van een niet bestaand betrouwbaarheidsinterval, omdat statistische toetsing nooit heeft plaatsgevonden. De rode pijlen representeren de denkwijze van het IPCC, niet die van de wetenschap.

Het IPCC probeert dus, naarmate de meetresultaten steeds verder achterblijven bij dat nietszeggende gemiddelde van alle modellen, de lezer zand in de ogen te strooien door het nietszeggende betrouwbaarheidsinterval telkens te verbreden om de meetresultaten ogenschijnlijk binnen Accept Null van figuur 2 en 3 te houden, ofwel: de metingen tonen zogenaamd aan dat de modellen gelijkwaardig zijn aan de meetresultaten. Hoe banaal kan een truc zijn? Edoch, de hele wereld inclusief zich kwaliteitskranten noemenden, zoals het NRC, trapte erin. Men kan er op wachten dat bij AR6 het virtually certain (99%) zal gelden. Dit is uitstel van executie, want er komt een moment dat het IPCC zijn geloofwaardigheid in dezen verliest.

Laten we tot slot kijken naar die klimaatmodellen zelf.

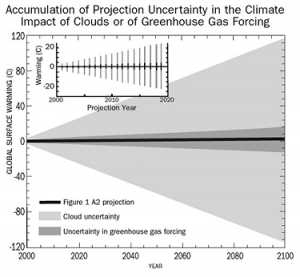

Wat opvalt is de rol van bewolking, een natuurlijk effect dat de modellen uitsluiten, het effect ervan op de ‘voorspellende’ uitkomsten van de klimaatmodellen en de groeiende onzekerheid (error) daardoor.

The average energy impact of clouds on Earth climate is worth about -27.6 W/m2. 27 That means ±10.1% error produces a ±2.8 W/m2 uncertainty in GCM climate projections. This uncertainty equals about ±100 % of the current excess forcing produced by all the human-generated greenhouse gasses presently in the atmosphere.10 Taking it into account will reflect a true, but incomplete, estimate of the physical reliability of a GCM temperature trend.

So, what happens when this ±2.8 W/m2 is propagated through the SRES temperature trends offered by the IPCC in Figure SPM-5 (Figure 1)? When calculating a year-by-year temperature projection, each new temperature plus its physical uncertainty gets fed into the calculation of the next year’s temperature plus its physical uncertainty. This sort of uncertainty accumulates each year because every predicted temperature includes its entire ± (physical uncertainty) range (SI Section 4).

Het resultaat leidt tot exploderen van die modellen. Bewolking is overigens niet de enige natuurlijke factor. Daar zijn ook de zon, oceanische stromingen, onderzees vulkanisme et cetera, die het IPCC buiten zijn modellen houdt. De modellen van het IPCC zijn dus om meer redenen discutabel. Hoe het er in statistisch-rekenkundig detail uit ziet kunt u in deze lezing zien. De cijfers verschillen iets van eerder vermeld, maar het effect is idem. De conclusie is dat het IPCC de wetenschappelijke methode negeert en hierdoor onjuiste informatie verstrekt in strijd met zijn maatschappelijke positie.

Bron hier.

Jeroen, jij redeneert vanuit de zuiver wetenschappelijke benadering.

Stephen Schneider heeft het onder andere over The “Science Always Falsifies” Pitfall.

Wat vind je van zijn opvattingen?

http://stephenschneider.stanford.edu/Mediarology/Mediarology.html

De gebruikelijk riedel van de zogenaamde sceptici.

* Cornbelt warming

* US warming

* Mid troposfere warming

* Land only warming

* Local Warming

* Alles behalve GLOBAL warming

* Doorzichtige truckjes om data te verschuiven

* En natuurlijk de gebruikelijk hide de incline spelletjes.

De actuele data

http://www.climate-lab-book.ac.uk/files/2016/01/fig-nearterm_all_UPDATE_2016-panela.png

Hernan, kijk eens heel goed naar Pinatubo 1991 in je gelinkte grafiek, dat bewijst dat de modellen aerosolkoeling veel te groot inschatten, dus is ook het CO2 opwarmingseffekt aantoonbaar te groot in de modellen. Hete modellen worden gekoeld met aerosolen tot 2005, vandaar dat ze in de RCP’s na 2005 omhoog schieten. Het enige model dat voor 2016 telt is RCP8.5 dat heeft namelijk de juiste CO2 concentratie voor 2016. Heb je ook een grafiek waar de resultaten van de andere RCP’s zijn weggelaten?

QED

O maar Hans er zijn vast wel meer factoren die modellen te groot of te klein inschatten. Modellen moeten zich nog gaan bewijzen. Verder hebben wij ook helemaal geen modellen nodig om een projectie te maken of een verwachting uit te spreken voor de toekomst. Op basis van je aanname van klimaatgevoeligheid teken je zo hopla je grafiek met potlood en papier. En wat die RCP 8.5 betreft: Let goed op de kleuren tot 2025 lopen alle kleuren en dus ook alle RCP’s nog door elkaar. Pas later zie je rood omhoog gaan en blauw laag blijven.

De reden dat ik de grafiek liet zien is niet zo zeer om modellen te verdedigen maar om te laten zien dat de zogenaamde sceptici graag hide the incline spelletjes spelen en de data laten stoppen in 2012.

En wat ook heel raar is dat zogenaamde sceptici aan de ene kant roepen dat we nog niet eens de natuurlijke factoren goed kennen maar aan de andere kant wel verwachten dat de temperatuur exact langs het gemiddelde lijntje zal bewegen. Heel vreemd.

Herman,

Wat is er, wetenschappelijk gezien, mis met stoppen in 2012.

We praten over langjarige effecten, en in 2012 waren dezelfde problemen en effecten aan de orde als nu.

Als we toen geen effect zagen en nu wel, is er waarschijnlijk een andere reden. CO2 bijv. is in die periode niet sneller gaan stijgen, nog steeds circa 2 ppm per jaar toename.

” Wat is er, wetenschappelijk gezien, mis met stoppen in 2012.

We praten over langjarige effecten, en in 2012 waren dezelfde problemen en effecten aan de orde als nu.”

Wat daar tegen is, is dat de meetserie met satellietgegevens nog relatief kort is. 3 of 4 jaar extra telt dan zwaar mee. Vooral gezien het feit dat er binnen die tijd fluctuaties zijn met een langjare periode, zoals ENSO en zonneactiviteit.

De gebruikelijke riedel van activistje Vruggink

Jeroen, je hebt het grootste gelijk van de wereld. De bewering dat het 95% zeker is, dat minstens 51% van de opwarming sinds 1950 door de mens is veroorzaakt, staat in geen enkel wetenschappelijk tijdschrift. Maar een beetje eerlijk is het IPCC wel, alleen verstoppen ze dat zo diep mogelijk in hun teksten: in 2007 was het zogenaamd 90% zeker dat minstens 51% van de opwarming door broeikasgassen werd veroorzaakt, in 2013 was de zekerheid opgewaardeerd tot 95% (inderdaad: door hand opsteken, zonder enige statistische basis) maar de bewering was afgezwakt tot ‘51% van de opwarming is door menselijke invloeden veroorzaakt’. Ontbossing en verstedelijking hebben ze dus meegenomen, zonder dat expliciet in de conclusies te vermelden. Het IPCC heeft niet beweerd, dat de zekerheid is toegenomen, dat hebben onze ‘kwaliteitskranten’ gedaan. Door zijn taalgebruik heeft het IPCC deze conclusie alleen maar uitgelokt. Uitlokking van een conclusie is wetenschappelijk uit den boze, maar politiek een heel normaal middel.

Het 90% betrouwbaarheidsinterval voor de klimaatgevoeligheid stond volgens het IPCC in 2007 op 2-4,5 Celsius, met als beste schatting 3,2. In 2013 stond de klimaatgevoeligheid op 1,5-4,5, terwijl geen beste schatting meer werd gegeven. Hieruit kan alleen maar geconcludeerd worden dat bij het IPCC de onzekerheid is toegenomen. Maar dat is geen enkele ‘kwaliteitskrant’ opgevallen. Het IPCC is er in geslaagd de regeringsleiders in Parijs de illusie te geven, dat ze tot op een halve graad nauwkeurig kunnen afspreken hoe ver de aarde mag opwarmen, terwijl het IPCC niet weet waar ze moeten gaan zitten op een traject van 3 graden klimaatgevoeligheid! Een Nobelprijs voor literatuur waardig.

Prima artikel, dank Jeroen!

Als ervaren statisticus schaam ik me dood voor wat ik aan onzin op bv de MSM langs zie komen. Waar het om gaat is de relatie tussen onze CO2 uitstoot en het klimaat. En die is empirisch onbewezen.

Oplopende temperatuurgrafieken, ramp verhalen over smeltend ijs en ijsberen, overstromingen, etc. zeggen niets maar dan ook niets over de AGW hypothese omdat de relatie met man-made CO2 telkens ontbreekt. Zelfs als de wereld de komende 10 jaar bv. 2 graden opwarmt zegt dat niks over de AGW hypothese. Dat kan net zo goed natuurlijke (niet AGW) oorzaken hebben. Dan helpt CO2 beperking niks.

En die modellen van IPCC zijn een mooi voorbeeld van datasnooping of curvefitting: men heeft in-sample (bv tm 1998) net zo lang aan de parameters gesleuteld totdat er een stijgende temperatuurcurve uit kwam. Vandaar ook de out-of-sample hiaat na 1998. Daarnaast moet je bij datasnooping niet 2-sigma maar 3- of meer sigma grenzen hanteren.

Tenslotte bevat de stijgende CO2 curve zo weinig variabiliteit dat daar geen regressiemodel iets mee kan (wij noemen dat multicollineariteit). Iedere goede statisticus kan dat beamen. U kunt zonder probleem de CO2 curve vanaf 1960 vervangen door bv het saldo van een spaarbank boekje met een paar procent rente. Geen mens die het verschil ziet tussen de twee curves. Daar valt dus niks mee aan te vangen.

Kortom, statistisch is de AGW hypothese in het geheel niet bewezen. Pure bangmakerij van de groene kerk! Kost miljarden die beter naar arme landen kan gaan.

Er ‘is’ een statisticus die berekend had dat gemiddelde diepte in een door hem bestudeerd meer 1 meter was. Toch verdronk hij.

In statistieken kun je niet leven. Er is een mooie film over gemaakt door Kieslowski…

Statistieken zijn de moderne ‘Goden’ geloof ze maar niet.

1 – Vereer naast mij geen andere goden.

Een vader leert zijn zoontje dat alles te beredeneren is, ook leven en dood. “Dood is wanneer je bloedsomloop stopt”, antwoord hij op de vraag naar de betekenis van “dood”. Maar het zoontje vindt een dode hond en hoopt dat die het nu “beter heeft”. Hij vraagt zijn vader wat het betekent als men zegt “moge haar ziel vrede hebben”. Wat is een ziel ? Tijdens een college betoogt de vader dat men op termijn een computer zal kunnen bouwen die alle talen begrijpt en daarmee ook alle betekenissen kent. Die computer zou in staat zijn ethische oordelen te vellen. Thuis spelen de man en zijn zoontje samen gezellig puzzeltjes op de computer. Het vriest al dagen en dus berekenen ze de sterkte van ijs. De uitkomst van de berekening is dat het ijs wel driemaal het gewicht van de jongen kan dragen.

Aan het einde van de film gaat de vader naar een kerk in aanbouw en gooit daar het geïmproviseerde altaar met de kaarsjes om. Een omgevallen kaars druppelt was over het gezicht van de Madonna, het is alsof ze huilt. Eén van de meest indrukwekkende beelden uit de cyclus. Thuis zit de vader achter zijn computer. Maar het scherm blijft leeg, de techniek en statistiek geeft geen antwoord

“Kost miljarden die beter naar arme landen kan gaan”. Miljarden klimaathulp is juist het onderliggende doel van de gepolitiseerde IPCC-Kyoto-COP-XX bijeenkomsten. Bovendien is die extra ontwikkelingshulp destructief voor het eigen economisch ontwikkelvermogen van die arme landen. Catch22?

Goede bijdrage Wouter. CO2 verhaal klopt niet. Maar ik denk dat het wel een ietsie pietsie warmer wordt over de afgelopen 100 jaar. Oorzaak onbekend, en absoluut niet alarmerend.

Vervuiling lijkt me een veel groter probleem.

Statistieken zijn de moderne ‘Goden’ geloof ze maar niet.

Je kunt niet in statistieken ‘leven noch sterven’. Kieslowski heeft er een briljante film over gemaakt die in feite ingaat tegen de ‘autistische wetenschaps nerds’. Iedere statistiek onttrekt zich aan een relevante diskussie over de ‘zin en onzin’ van een bewering. Statistiek is daarmee net zo glas als ‘ijs’.

even een samenvatting van het leven van een statisticus/wetenschapper ….

1 – Vereer naast mij geen andere goden.

Een vader leert zijn zoontje dat alles te beredeneren is, ook leven en dood. “Dood is wanneer je bloedsomloop stopt”, antwoord hij op de vraag naar de betekenis van “dood”. Maar het zoontje vindt een dode hond en hoopt dat die het nu “beter heeft”. Hij vraagt zijn vader wat het betekent als men zegt “moge haar ziel vrede hebben”. Wat is een ziel ? Tijdens een college betoogt de vader dat men op termijn een computer zal kunnen bouwen die alle talen begrijpt en daarmee ook alle betekenissen kent. Die computer zou in staat zijn ethische oordelen te vellen. Thuis spelen de man en zijn zoontje samen gezellig puzzeltjes op de computer. Het vriest al dagen en dus berekenen ze de sterkte van ijs. De uitkomst van de berekening is dat het ijs wel driemaal het gewicht van de jongen kan dragen.

Aan het einde van de film gaat de vader naar een kerk in aanbouw en gooit daar het geïmproviseerde altaar met de kaarsjes om. Een omgevallen kaars druppelt was over het gezicht van de Madonna, het is alsof ze huilt. Eén van de meest indrukwekkende beelden uit de cyclus. Thuis zit de vader achter zijn computer. Maar het scherm blijft leeg, de techniek geeft geen antwoord…

statistieken zijn waardeloze parameters over het leven.

Goed. Het is weekend! Yeah!

Maar eens wat nieuws introduceren: de Wiersma Weekend Quiz!

We beginnen gemakkelijk. En ja, ik probeer het zoveel mogelijk in de geest van wat er hier zo omgaat bij CG te houden.

Vraag 1.

WAAROM bestaat het monster van Loch Ness niet? En heeft het ook nooit bestaan?

Onder de goede inzenders verloot ik een virtueel ticket “Tien keer gratis op en neer op de roltrappen van de V&D”.

Succes!!

Spannend…

Statistiek en conceptuele modellen van het broeikaseffect. (een reactie op Jeroen, Frans D en Wouter d.d. 3-12-2016)

De kritiek op het gebruik van statistiek om een door CO2 versterkt broeikaseffect te ‘bewijzen’ kan ik volgen. Daarmee wordt dit effect echter niet zondermeer getorpedeerd.

Ik zit op een andere toer om het mogelijke effect van CO2 te betwisten. Niet de benadering die Vruggink (10.22 am) aanhaalt en aan sceptici toeschrijft. De grondslag is de mogelijkheid dat het conceptuele model dat in IPCC kringen voor het broeikaseffect wordt gebruikt, niet gerechtvaardigd is. Zoals Jeroen schetst, we missen de ‘nul-hypothese’.

Daaraan werk ik momenteel met een aantal collega’s die iets begrijpen van de uitwerking van IR stralingseffecten in een complex system .

Vooruit lopend op een meer gedetailleerde beschouwing hierover, hieronder de samenvatting van de essentie van ons betoog. Inhoudelijk commentaar op onze benadering en beschouwing zie ik met belangstelling tegemoet.

A WORKING PAPER ON THE RETHINKING OF THE CONCEPTUAL MODEL OF THE EARTH GREENHOUSE EFFECT.

Version 4

Abstract

The water planet Earth and its dry Moon are heated by short wave radiation (SWR) from the Sun and cooled by long wave IR (LWIR) emission to space. However, this does not imply that this situation can be characterized by a simplified kind of equilibrium state between the SWR and LWIR flux. The SWR only heats the local surface during the day. The LWIR flux is however continuously emitted to space. In addition, the solar flux at the surface varies continuously on a daily and a seasonal time scale. The energy transfer processes are dynamic or time dependent and this must be explicitly included in the analysis.

In contrast to the Moon the energy transfer processes that determine the surface temperature of the Earth include thermal conduction, convection and evaporation as well as the absorption and emission of electromagnetic radiation. These processes originate from the presence of a gaseous and water rich atmosphere on the planet that is largely covered by oceans.

The current concept of an atmospheric ‘greenhouse effect’ of the Earth is based on the a-priori assumption of an equilibrium average climate in which the surface temperature is dominantly determined by the radiative flux balance at the lower part of the atmosphere.

Here, we examine energy transfer processes starting from first principles arising from mass flows near the surface below 10 km altitude rather than a-priori assumptions about a radiation driven ‘greenhouse effect’. This leads to a very different picture of the origin of the ‘greenhouse effect’. The lower atmosphere, – the troposphere – acts as an open cycle heat engine that transfers the surface heat to the middle and upper troposphere by convection. The land and especially the ocean surface layers are the hot reservoirs of this heat engine . The middle to upper troposphere is the cold reservoir that is cooled by radiative emission to space.

The moving air masses in the troposphere are coupled to the Earth’s rotation and must perform mechanical work to overcome the Earth’s gravitational field. The rotational coupling produces the characteristic Hadley, Ferrell and Polar convective cell structure, the trade winds and the ocean gyre circulation.

These well established phenomena in combination with the facts that the insolation is as well unevenly distributed over the planet’s surface from equator to poles as over time (in a diurnal and seasonal cycle) suffice to explain why the ‘greenhouse effect’ is the result of the tropospheric heat engine that is determined by its thermodynamic properties. Heat is accumulated within the climate system until the thermal and humidity gradients at the surface are sufficient to dissipate the heat produced by the absorption of the solar flux.

The occurrence of a downward LWIR flux from lower troposphere to the surface, being presented as an important phenomenon in the current greenhouse theory, is herewith not denied. Its reconsideration is a matter of a reversed interpretation of a cause-and-effect relationship. It is argued that the heat engine determines the thermal gradients and therewith the LWIR fluxes, rather than the other way round.

The current greenhouse theory gained momentum based on the assumed effect of observed increased CO2 concentration in the atmosphere over the last century. Its properties to absorb and emit LWIR, also downwards, cannot be neglected, but the quantitative consequences for the maintenance of a particular surface temperature is contested, based on the heuristic approach that emerges from the presented functioning of the tropospheric heat engine.