William Kininmonth.

Auteur: William Kininmonth (Australië).

Wetenschappers van het Intergovernmental Panel on Climate Change (IPCC) stelden in hun eerste evaluatierapport uit 1990 dat de complexiteit van het klimaatsysteem zodanig is dat alleen computermodellen de gevoeligheid van de mondiale temperatuur voor toenemende kooldioxide in de atmosfeer kunnen bepalen.

Tegen deze achtergrond is het belangrijk om de ontwikkeling van klimaatmodellen te herzien, omdat recente gebeurtenissen er op wijzen dat de modellen de invloed van stijgende kooldioxide-emissies overdrijven.

De kern van klimaatmodellering wordt gevormd door vergelijkingen die de ontwikkeling van de atmosfeer en de oceanen beschrijven. De vergelijkingen waren al in de jaren twintig ontwikkeld. Het aantal individuele berekeningen dat nodig was, zelfs voor een korte weersvoorspelling, was in die pre-computertijd overweldigend. Zelfs met een groot team zou het weer sneller evolueren dan de berekeningen door hen konden worden uitgevoerd.

Tegen het begin van de jaren zestig waren computers ontwikkeld en waren ze voldoende snel dat het simuleren van weersystemen mogelijk werd. Er werden modellen ontwikkeld voor weersvoorspellingen.

Al snel werden weersvoorspellingsmodellen aangepast om processen op te nemen die belangrijk zijn om seizoens- en jaarlijkse klimaatstatistieken te produceren. Aanpassingen omvatten de weergave van zonne- en langgolvige stralingsstromen (de bron en de afvoer van energie naar het klimaatsysteem); wolken en regen; uitwisseling van warmte, vocht en de ontwikkeling van de oppervlakte-atmosfeer-interactie; en een ondiepe waterlaag met variabele temperatuur om de warmteopslag en -uitwisseling van de oceanen weer te geven.

Eerdere klimaatmodellen waren in staat om in grote lijnen de belangrijkste kenmerken van het seizoens- en jaarklimaat te reproduceren, inclusief drukpatronen, windvelden en wereldwijde temperatuurverdeling. De lage resolutie van het rekenraster en de relatief lange tijdstappen betekenden echter dat klimatologische kenmerken vaak niet nauwkeurig genoeg waren en er waren globale en regionale afwijkingen.

De potentiële impact op het klimaat van toenemende industriële uitstoot van kooldioxide was de aanleiding om de evoluerende klimaatmodellen te gebruiken om het effect van verhoogde atmosferische kooldioxideconcentraties op het klimaat te onderzoeken.

Een stijging van de mondiale gemiddelde jaartemperatuur werd aanvaard als een primaire indicator van de impact. Deze index kan worden vergeleken met reconstructies van historische wereldwijde jaartemperaturen op basis van instrumentele waarnemingen vanaf de jaren 1850.

Een tekortkoming van de vroege modellen was het onvermogen om de heersende mondiale gemiddelde temperatuur nauwkeurig te reproduceren. Elk model had zijn eigen kenmerken en het verschil met de waargenomen temperatuur op aarde was meer dan drie graden Celsius, ongeveer dezelfde waarde als de verwachte impact van een verdubbeling van de concentratie van atmosferische kooldioxide.

Om dit euvel te verhelpen, werd de impact van kooldioxide genomen als het verschil in wereldgemiddelde temperatuur tussen een modelsimulatie met verhoogde kooldioxide en die van een controlesimulatie met heersende kooldioxide. Modellen ontwikkeld in verschillende onderzoeksinstituten gaven aan dat een verdubbeling van de kooldioxideconcentratie de wereldgemiddelde temperatuur tussen 1,5 en 4,5 graden Celsius zou kunnen verhogen.

Niet alle wetenschappers waren het erover eens dat de modelprojecties realistisch waren. De Verenigde Naties erkennen het potentieel voor schadelijke milieu- en maatschappelijke gevolgen van dergelijke temperatuurstijgingen en hebben het IPCC opgericht om de wetenschap te beoordelen, om na te gaan hoe menselijke activiteiten het klimaat op aarde kunnen veranderen door het broeikaseffect, en om een gemeenschappelijke gids te bieden voor beleidsmakers over de hele wereld .

Het eerste beoordelingsrapport van het IPCC (in 1990) was gebaseerd op modellen met een vergelijkbare constructie als hierboven beschreven. Door de ontwikkeling van nog snellere computers konden modellen met een hogere resolutie worden gebruikt. Regionale kenmerken van het klimaat werden beter gedefinieerd en sommige afwijkingen konden worden beperkt.

Wetenschappers erkenden ook dat oceaancirculatie belangrijk was voor het transporteren van een deel van de overtollige warmte van de tropen naar de poolgebieden. Het tweede IPCC-rapport (1995) bevatte de output van modellen waarin circulerende oceanen de in wezen statische ondiepe oceanen van eerdere modellen vervingen.

Er zijn inherente problemen bij de koppeling van oceaan- en atmosfeercomponenten. De massa van de atmosfeer is gelijk aan alleen de bovenste 10 meter van de oceaan; de oceanen hebben veel meer traagheid dan de relatief snelle atmosfeer. Ook is de warmte-inhoud van de atmosfeer gelijk aan die van de bovenste vier meter van de oceaan; de oceanen reageren thermisch minder goed dan de atmosfeer.

Een resultaat van de traagheids- en thermische verschillen was dat er in de vroegste gekoppelde klimaatmodellen een energieonbalans was die met de tijd een afwijking van de wereldgemiddelde temperatuur veroorzaakte. De snelheden van warmte- en zoetwateruitwisseling tussen de oceaan- en atmosfeercomponenten van de modellen zijn aangepast om de mondiale en regionale temperaturen te stabiliseren. Deze aanpassingen zijn gedaan om ervoor te zorgen dat eventuele effecten als gevolg van verhoogde kooldioxide worden beoordeeld aan de hand van een redelijk stabiele klimaatbasis. De modelbouwers noemden deze aanpassingen “fluxaanpassingen”.

Dergelijke voor flux gecorrigeerde modellen vormden de basis van het derde evaluatierapport van het IPCC van 2001. De gevoeligheid voor verdubbelde kooldioxideconcentratie van deze oceaan-atmosfeer gekoppelde modellen was in hetzelfde bereik als die van de eerdere modellen.

Gedwongen stabiliteit door fluxaanpassing betekende dat wetenschappers de modellen continu konden gebruiken om het veranderende klimaat gedurende 1000 jaar en langer te simuleren. Het gebrek aan periodieke variabiliteit in deze lange simulaties bracht de IPCC-wetenschappers ertoe te concluderen dat het klimaatsysteem zelf weinig interne variabiliteit heeft. Dit is een controversiële conclusie, aangezien de modellen waaruit de conclusie is afgeleid, kunstmatig zijn gestabiliseerd om temperatuurafwijkingen te voorkomen.

De modellen, met passend voorgeschreven “stralingsforcering” (een aanpassing aan de netto straling aan de bovenkant van de modelatmosfeer die naar verwachting een oppervlaktetemperatuurrespons zal forceren), werden ook gebruikt om de veranderende wereldtemperatuur van de 20ste eeuw te simuleren.

“Stralingsforcering” is de technische term die wordt gebruikt om uit te leggen hoe koolstofdioxide de planeet opwarmt. De langgolvige emissie naar de ruimte neemt af naarmate de kooldioxideconcentratie toeneemt, waardoor de oppervlaktetemperatuur naar verwachting zal stijgen. De grootte van de langegolfreductie voor een gegeven concentratietoename is de “forcering”.

Er is ook een verandering in de oppervlaktetemperatuur als de zonne-intensiteit toeneemt, of als de deeltjesdichtheid toeneemt om meer zonnestraling naar de ruimte te reflecteren. Zo werd de opwarming in de periode vóór 1940, toen er weinig toename van kooldioxide in de atmosfeer was, toegeschreven aan een toename van de zonne-intensiteit. Met geschikte “stralingsforcering” om de toenemende zonne-intensiteit weer te geven, warmde de modeltemperatuur op.

De moeilijkheid is dat, hoewel er blijkbaar een toename van de zonne-intensiteit was tussen 1900 en 1940, de omvang van de verandering niet goed gespecificeerd is.

De concentratie koolstofdioxide in de atmosfeer begon na 1940 snel te stijgen, maar tot het midden van de jaren zeventig steeg de temperatuur op aarde niet verder. Dus de modelbouwers verminderden de zonne-intensiteit voor de periode 1945-1975 en rationaliseerden de vermindering als het gevolg van toenemende industriële deeltjes (aerosolen) die meer zonne-energie naar de ruimte reflecteerden.

De modellen waren in staat om de relatief constante temperatuur gedurende de periode te reproduceren omdat het geclaimde koeleffect van de industriële deeltjes het opwarmende effect van het toenemende kooldioxide in de atmosfeer compenseerde.

Verder werd aangenomen dat de maatregelen om luchtvervuiling tegen te gaan, die in de meeste geïndustrialiseerde landen wettelijk zijn vastgelegd, de deeltjes en hun verkoelende effect na ongeveer 1970 grotendeels zouden hebben geëlimineerd. Onder de nu dominante invloed van toenemende kooldioxideconcentratie toonden de modellen de waargenomen stijgende temperaturen tot het einde van de eeuw.

Er is echter, ondanks dat de wetenschap “vaststaat”, maar weinig inzicht in de relatie tussen fijnstofconcentraties en stralingsforcering.

Het vermogen om de wereldwijde gemiddelde temperatuur van de 20ste eeuw te simuleren, onder zogenaamd realistische historische stralingsforcering, gaf wetenschappers vertrouwen in de klimaatmodellen. Het IPCC vertrouwde in zijn derde evaluatierapport van 2001 op dergelijke “flux-adjusted” modellen om te concluderen dat het grootste deel van de opwarming van de afgelopen 50 jaar waarschijnlijk te wijten was aan de toename van de concentraties van broeikasgassen.

De “fluxaanpassing” werd als kunstmatig erkend en is vervangen door andere, waarschijnlijk niet minder kunstmatige, modelstabilisatie.

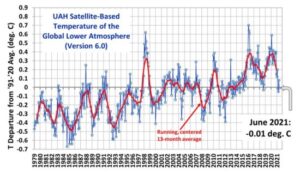

Wetenschappers verwachtten toen dat de modellen de toekomstige wereldwijde temperatuurstijging realistisch zouden voorspellen naarmate de industriële uitstoot van kooldioxide toenam. Aan deze verwachting is niet voldaan. In de eerste twee decennia van de 21e eeuw hebben modellen consequent hogere temperaturen voorspeld dan waargenomen. Bovendien is de discrepantie tussen de projecties en de waargenomen temperaturen met de tijd toegenomen. Om nog maar te zwijgen van het feit dat de spreiding van de modelprojecties ook met de tijd is toegenomen.

De divergentie tussen modellen was een van de belangrijkste punten van kritiek van Steven Koonin in zijn recente boek, Unsettled. Zie o.a. hier.

Er zijn verschillende mogelijke verklaringen aangedragen voor de overdreven opwarming van de modelprojecties. Een daarvan is dat het klimaatsysteem misschien een aanzienlijke interne variabiliteit heeft op multi-decadale tijdschalen die niet door de modellen wordt opgepikt. Het bestaan van interne variabiliteit, met zijn oorsprong in de langzaam variërende oceaancirculatie, verzwakt de stelling dat stralingsforcering de dominantie factor is bij klimaatverandering.

Van meer belang zijn afwijkende veranderingen die in de loop van de tijd in de modelatmosfeer optreden. Deze wijzen op tekortkomingen in de modelbouw. Als bijvoorbeeld de verwachte oppervlaktetemperatuur stijgt, neemt zowel de stabiliteit als de relatieve vochtigheid van de luchtlaag van het model aan het oppervlak (de atmosferische grenslaag) toe. Uit natuurkundige principes kan worden aangetoond dat deze afwijkende kenmerken de neiging zouden hebben om de toename van de verdamping in het model te onderdrukken. Dat wil zeggen, er wordt minder latente warmte van het oppervlak naar de atmosfeer geleid en ter compensatie stijgt de oppervlaktetemperatuur meer dan anders het geval zou zijn.

De neiging tot een toename van de stabiliteit van de grenslaag en de stijging van de relatieve vochtigheid is duidelijk abnormaal en in tegenstelling tot wat elke dag kan worden waargenomen. Na zonsopgang, als de oppervlaktetemperatuur stijgt, wordt de atmosfeer onstabieler en neemt de relatieve vochtigheid af. In de late namiddag, als de oppervlaktetemperatuur afkoelt, wordt de atmosfeer stabieler en neemt de relatieve vochtigheid toe. Deze waargenomen patronen zijn het tegenovergestelde van modelreacties, aangezien hun temperaturen stijgen met toenemende koolstofdioxide.

De aarde is een waterplaneet: 70 procent van het oppervlak is bedekt met oceaan. Verdamping beperkt de stijging van de oppervlaktetemperatuur. Elke beperking van verdamping in het model zal de oppervlaktetemperatuur verhogen. De neiging om de verdamping van modellen te beperken veroorzaakt ook onzekerheid ten aanzien van de projecties van regionale regenpatronen als klimaatveranderingen.

Klimaatmodellen blijven, ondanks hun ontwikkeling in de afgelopen decennia, rudimentair in vergelijking met de complexiteit van het klimaatsysteem. De replicatie van het klimaat uit het verleden door de modellen is problematisch en geprojecteerde toekomstige scenario’s moeten met de nodige voorzichtigheid worden behandeld.

Opwarming van de aarde heeft plaatsgevonden in de afgelopen eeuwen. In hun huidige staat van ontwikkeling laten de modellen ons echter niet toe om de rol van koolstofdioxide te scheiden van natuurlijke variabiliteit. Speculatie dat toekomstige opwarming als gevolg van aanhoudende uitstoot van kooldioxide gevaarlijk zal zijn en zal leiden tot wijdverbreide uitsterving van soorten is ongegrond.

***

William Kininmonth heeft een carrière van meer dan 40 jaar in meteorologische wetenschap en beleid. Gedurende meer dan een decennium (1986-1998) leidde hij het Australische National Climate Centre. Hij was daar verantwoordelijk voor het monitoren van het veranderende klimaat in Australië en het adviseren van de Australische regering over de omvang en ernst van weersextremen, waaronder de terugkerende droogteperiodes van de jaren negentig. Hij was tevens leider van de Australische afvaardiging naar het IPCC.

***

Naschrift van de redactie

Waar blijft nu toch die verschrikkelijke klimaatcrisis?

Opnieuw daling temperatuur

Klimaatmodellen zijn maar een deeltje van alle bewijzen rond AGW. Zelfs indien die modellen onbetrouwbaar zouden eijn, dzn nog is et enorm veel bewijs dat de aarde opwarmt en dat in hoofdzaak door broeikasgassen wordt veroorzaakt.

De beperkingen van modellen zijn gekend en steeds weer door sceptici opgerakeld. Maar ook een model met beperkingen kan je veel leren. Die sceptici willen dat niet aanvaarden rn xillen ook niet etkennen dat er ook enorm veel ander bewijs bestaat. Door dat allemaal te negeren, maken William Kininmonth en anderen zichzelf ongeloofwaardig.

Het probleem, Bram, is dat AGW nog geen CAGW is.

CAGW is Greta “people are dying”

CAGW is beweren dat CO2 eeuwig in de atmosfeer zal blijven.

CAGW is Extinction Rebelion terwijl we niet extinct gaan.

CAGW is science fiction RCP8.5 als business as usual afschilderen.

CAGW is hameren op hoge ECS terwijl die een relaxatie tijd van 500 jaar heeft.

“Vandaag is er nog geen crisis.”

Vertel je dat ook even aan Timmermans?

zonder urgentie aan de dag te leggen gebeurt er niets.

Ach bram in 1988 zouden we nu al op 4 graden moeten zitten, van dut angstscenario is niets uitgekomen, en nu zouden we plots bang moeten zijn voor anderhalve graad? De muur waar we op af dreigden te stevenen blijkt een mistbank te zijn.

Ecopessimisme is een slechte raadgever vooral als het de toekomst betreft.,

4 graden? Ruim een graad per decade sinds 1988? Dat moet een typo zijn en anders vereist dat onderbouwing.

Modeleur

Wat moet er gebeuren? Een landschap vol windturbines en zonnepanelen zover je kijken kunt? Is dat wat jij wilt? Is vooroplopen of inhalen zo belangrijk? Haantjesgedrag!

4 graden was dus onzin

Klopt, modellen kunnen een heleboel voorspellen. Zo heeft mijn bank mij een riant pensioen voorgespiegeld. Helaas komt het niet uit.

Wat had die bank dan exact gezegd? “je gaat dit zeker krijgen”? Of “het kan oplopen tot….” en jij hebt dat toen als hun belofte gemisinterpreteerd? Maakten zij een fout of was het jouw foute interpretatie?

En hoe ver zit de realiteit van de voorspelling? En leef jij nu in armoede?

De klanten interpreteerden de foute modellen van de bank zoals de klanten geacht werden te doen.

Ik zie wel overeenkomsten met klimaatmodellen: Veel temperatuurstijging beloven, maar weinig leveren.

Mijn bank en mijn pensioenfonds ook, alleen loop ik nu bij de voedselbank en kom ik halverwege de maand een halve maand tekort. Was ook zo’n goed businessmodel alleen vergaten ze te zeggen dat ze dat vanuit het bankperspectief bedoelden

Veel belangrijker is dat wij en onze nakomelingen door de opwek met wind & zon grote gezondheidsvoordelen scoren ten opzichte van wat we nu hebben: fossiel en kern.

Geen genetische schade door uitgestoten straling.

Geen risico op een totale ramp, waarbij ze evt zelfs de botlek moeten ontruimen bij verkeerde wind.

Geen moeilijk oplosbaar probleem voor onze nakomelingen achterlaten met kernafval.

Geen gezondheidsschade door de uitstoot van fijnstof en andere gifstoffen (SO2, e.d.)

Geen voortijdig opmaken van mogelijk zinvolle grondstoffen zoals olie en aardgas.

Onze gezondheid is veel belangrijker dan een temperatuur stijging van een paar graden.

Zo zeker ben ik daar nog niet van nu meer en meer duidelijk wordt dat afgedankte zonnepanelen en molenwieken gewoon wereldwijd in de grond weggestopt worden omdat geen werkbare/haalbare recyclage technologie werd ontwikkeld.

Van zonnepanelen is bekend dat die schadelijk zijn voor de gezondheid, en dat die in grondwater oplosbare sterk giftige verbindingen bevatten die genetische schade en kankers veroorzaken . Binnen 10 jaar is dit het volgend nieuwe schandaal na de recente PFOS/PFAS schandalen.

Daarom is de levensverwachting al eeuwen zo hoog in de Amazone.

Geen kernafval, geen straling, geen fijnstof, geen gebruik van olie of aardgas, geen auto’s, veel geboortes.

Ze heel tevreden met deze natuurlijke omstandigheden en “natuurlijke” selectie.

De milieugroepen en een enkele commentator hier, bepaald niet de mensen die daar leven.

Bas Gresnigt wil gewoonweg niet weten dat ze in andere landen zwaar ziek worden door uranium, thorium en zware metalen die ze benodigen voor onderandere zware neodymium magneten in direct aangedreven windturbines, vervuild drinkwater en kanker is er schijbaar de gewoonste zaak voor deze rommel te maken.

Maar kerncentrales passen niet in zijn straatje.

Gisteren zei je dat de auteur het fout had volgens jou, ik heb je daar nog een link 2de link over geplaatst, maar Basje wil dat negeren omdat hij zelf zo gezond wil leven mogen andere daar voor een lijdensweg hebben, beetje hypocriet of niet dan.

Maar wat heeft het nog voor zin om jou een antwoord te geven vraag ik me af als je alleen zo met je zelf bezig bent.

@Theo,

Het is gewoon een verzinsel dat voor het winnen van neodymium uranium of thorium nodig zou zijn.

Als dat al zou zijn dan kunnen we gemakkelijk overschakelen op elektro-magneten of magneten van een ander metaal.

Of we kunnen overschakelen op neodymium uit een ander land zoals Australië of USA. Ze hebben daar nog mijnen die zijn gesloten vanwege de goedkopere Chinese concurrentie.

Neodymium is een zeldzaam aardmetaal dat in tegenstelling tot het woord ‘zeldzaam’ helemaal niet zeldzaam is in de wereld.

De auteurs van je 1e en 2e link hebben het verzinsel gewoon gecopieëeerd.

Het is ook niet NODIG Bas Gresnigt, het is een NEVENPRODUCT bij de winning van neodymium. Overschakeken op een andere neodymiumproducent nu china 55% van de markt in handen heeft? Succes met deze groeiende marktvraag.

Sep

Riedel, riedel, riedel. Het is nog net niet steeds hetzelfde stukje, wél dezelfde riedel.

Net als die van mij, Doe mij maar meer bomen en kernenergie.

Precies Hans, het zijn nevenproducten.

En Bas Gresnigt, dat is zeker zo, ARD heeft er al een tv uitzending aan gewijd.

Maar jij weet dat allemaal zelf verdomd goed hoe dat allemaal zit, maar dat wil jij niet weten om de een of andere reden.

Dan schrijf je,

Als dat al zou zijn dan kunnen we gemakkelijk overschakelen op elektro-magneten of magneten van een ander metaal.

Nee dat doen ze niet meer want de rendementen liggen veel lager, dit hebben ze in het verleden wel eens getest in de praktijk, ik meen in België maar voldeed niet, ook het toerental moet hoger en werkt dus niet in een direct drive.

Je probeert dit goed te praten maar dat werkt niet, het enige wat China ooit eens heeft laten weten is dat ze er voorzichtiger mee om zullen gaan, maar China is communistisch, en oefent nu nog steeds dwangarbeid uit, ook op zonnepanelen zoals we inmiddels weten.

En de EU gaat er ook nog mee akkoord, doelstellingen halen in de EU was belangrijker schijnbaar.

En als je van de week naar de parade in China had gekeken dan zeggen ze zelf, we laten nooit en te nimmer door wie dan ook dwang op ons leggen, dus co2 afspraken vergeet het maar als het hun niet uitkomt, je hebt met een communistische grootmacht van doen die zich kapot lacht hoe die domme Europeanen hun schatrijk komen maken.

@Hans,

Ik heb nagezocht wat daar aan de hand is.

China heeft in Baotou, Binnen-Mongolië, een uranium mijn & fabriek om zijn vele kerncentrales van brandstof te voorzien. Ze hebben overigens veel te weinig uranium erts en zijn in 2010 met 600 wetenschappers aan de ontwikkeling van een MSR begonnen met de bedoeling om daarin t.g.t. thorium te gaan gebruiken.

Dat staat los van hun zeldzame aardmetaal activiteiten. De BBC geeft daar een indruk van, waarbij het beroemde giftige meer diepe indruk heeft achtergelaten:

https://www.bbc.com/future/article/20150402-the-worst-place-on-earth

Het gaat om materialen die in allerlei voorwerpen zitten; je telefoon, televisie enz. en ook in windturbines.

Bas ik heb het ook nagezocht

https://www.epa.gov/radiation/tenorm-rare-earths-mining-wastes

HasseBassie, hoe kom je nu weer aan genetische schade als bedoelt van de vaccins dan heb je gelijk maar van kernenergie is dat te verwaarlozen. De mens kan best tegen een beetje straling andres zouden ze in Zweden allemaal genetische schade hebben opgelopen. De enige schade die ze daar oplopen is een alcoholschade.

Dan het ontruimen van de Botlek. De plaats van onze kercentrales is bepaald weer door incompetente ambtenaren want ze staan allemaal verkeerd. Als je een beetje verstand hebt dan kijk je eerst waar de meest voorkomende winden vandaan komen. In Nederland is dat tussen NW en ZW dus hadden die dingen in Groningen aan de Waddenzee moeten staan dan hebben wij er geen last van. Die zgn domme Belgen hebben dat beter begrepen want die staan aan de grens met Zeeland en in Tihange heeft Duitsland een probleem als er wat gebeurt.

Als we nu innovatief bezig moeten zijn moeten we een Thorium MSR centrale bouwen dan is het afval probleem ook opgelost en het afval kan als brandstof in de Thoriumcentrale gebruiken. Kortom een win-win situatie.

We hebben trouwens nog voor 400 jaar kolen en gas ook voor een paar honderd jaren. Dus hoeven we ons helemaal niette haasten om over te schakelen we kunnen daar meer dan honderd jaar over doen.

Nog even voor de beleving als ik een selectie doe op 217 landen in de wereld met een CO2 uitstootgroter of gelijk aan 0,5% van de werelduitstoot dan zijn dat 32 landen die samen 89% van de wereld CO2 uitstoot uitstoten. Daar komt Nederland niet in voor want wij stoten 0,47% dus de rest van de 185 landen stoten samen 11% uit. De EU ca. 8% dus onze bijdrage is nihil en rechtvaardigt helemaal niet om daar duizenden miljarden Euro’s in te steken dit is volkomen onverantwoord en totaal zinloos. Het leidt alleen maar tot de Groene Paradox en een gigantische kapitaalvernietiging die je beter in de bouw van huizen, de zorg, infrastructuur, bouw van Thoriumcentrales, etc kan stoppen. Dan doe je iets voor de volgende generatie nu wordt alle welvaart die onze ouders hebben opgebouwd volkomen vernietigd en kan de volgende generatie opnieuw beginnen, in ieder geval bedankt HasseBassie visieloos past goed bij je en GL, D66, CDA, VVD. Of de CO2 nu door mensen zou komen of niet is volkomen irrelevant.

HasseBassie, nog even in China komen er ca 400 kolencentrales bij. In de wereld waren het er ca 2000 dit heeft tot gevolg dat de CO2 uitstoot toeneemt met ca 15-20% meer dan de 11% van die 185 landen. Hier zie ook hoe nutteloos het is om daar 1 Euro in te steken als je dat niet begrijpt of wilt begrijpen ben je rijp voor de schroothoop, veel suk6.

Bram

Enorm veel bewijs? Kom steek eens van wal. Of blijft het bij een loze bewering?

Bram is de nieuwe alias van Bas Post. Heeft een ban.

….

Inmiddels heeft hij ook weer onder de naam Nick gereageerd. Ook verwijderd.

https://youtu.be/kBZLeJtjcdA

Standaard ecopessimistisch klimaatjehova gedrag wellicht.

https://en.wikipedia.org/wiki/The_Uninhabitable_Earth

Ik wacht op een eerlijk antwoord

Hans, chapeau. Je hebt het maar druk met het afvangen van die zwaar gestoorde types die ongeloofelijk véél moeite doen om zoveel mogelijk negatieve waarderingen zoor hun geleende commentaren te scoren. Dan is er echt een steek aan je los als je dat elke keer weer probeert. Het is vast een roeping. Tot klimaatbekeerling.

Olivia, de uitspraken van Bram zijn niet specifiek.

Wanneer klimaatmodellen buiten beschouwing worden gelaten dan resteert vooral bewijs dat de opwarming van de afgelopen eeuwen beslist niet exclusief aan broeikasgassen kan worden toegeschreven. A.s. zondag wordt op Climategate mijn nieuwste artikel gepresenteerd waarin een analyse voor het afgelopen Millennium wordt gepresenteerd waaruit blijkt dat de zon nagenoeg geheel verantwoordelijk kan worden gehouden voor het temperatuurverloop tot begin jaren ’80.

Astronomen bevestigen al jaren dat de opwarming tot in de jaren ’50 heel goed kan worden verklaard door de activiteit van de zon (in combinatie met vulkansisme), zie o.a. deze publicatie van 60 experts op het terrein van de zon:

Dudok de Wit et al. (2016) Earth’s climate response to a changing sun

h ttps://www.edp-open.org/images/stories/books/fulldl/Earths_climate_response_to_a_changing_Sun.pdf

De achterflap van het boek vermeldt o.a.:

“The reader will learn about the assumptions, the data, the models, and the unknowns behind each mechanism by which solar variability may impact climate variability. None of these mechanisms can adequately explain global warming observed since the 1950s. However, several of them do impact climate variability, in particular on a regional level.”

Er is geen klimaatcrisis en er komt geen klimaatcrisis, want TCR is laag. De rest is science fiction.

Snap je EK?

Je spreekt jezelf tegen. Eerder zei je nog dat ons lot van een nakende klimaatcrisis in de handen ligt van China en India.

Belangrijkste ‘broeikasgas’ is waterdamp –> mens geen invloed

Stijging van CO2 gehalte in atmosfeer sinds 1850 = lineair ergo niet veroorzaakt door ‘fossiele brandstoffen’

Door meer CO2 is aarde +/_ 20% groener en oogsten veel beter.

Kan ik alleen maar toejuichen

ps. let op gemiddelde temp. op aarde –> dalende trend sinds 1998

Heb je nog meer onzin, Peter van Luijn?

Alleen het punt dat het door CO2 groener is geworden is misschien juist.

Ja. Ik zei het al. Die CO2 uitstoot doet niks aan de temperatuur.

https://www.climategate.nl/2021/01/ben-ik-dan-wel-een-klimaatontkenner/

Gisteren heeft Martijn een artikel in Off-Topic geplaatst, daar zegt IPCC we gaan dood.

En IPCC heeft ook nog gelijk, we gaan dood, iedereen gaat vroeg of laat een keer dood, niks nieuws dus, en de wereld gaat ook niet uitsterven omdat IPCC dat zegt.

@Theo. Juist, we gaan allemaal een keer dood. Maar je ziet het op moment met het klimaat en covid dat we de feiten gaan negeren en denken een eeuwig leven te hebben als we het klimaat redden en vechten tegen covid. De mensheid heeft al lang geen binding met de natuur en kan blijkbaar natuurlijke processen niet meer beoordelen en varen blind op “modellen”.

Dit stuk roept vragen op. En steeds weer van mensen die hun carrière gehad hebben. Er moeten toch jonge actieve onderzoekers zijn die nu in het vakgebied werkzaam zijn. In het beleid gaat men uit van dat 2030 een kantelpunt is. Dat hier nergens te vinden. Omdat het model een uitkomst in de tijd heeft wordt het model steeds bijgestuurd in de tijd door een verzonnen correctie. Zo werkt regeltechniek niet. Dat betekent eigenlijk alleen maar dat je geen idee hebt hoe deze vraag echt op te lossen als er al een oplossing bestaat.

De beleidsmakers gaan dan maar uit van het voorzorg principe. Iedereen in Australië en Gelderland ( bij de RES participatie ) kan begrijpen dat de bosbranden in Australië het beste voorkomen kunnen worden door de gelderse vallei vol te zetten met windmolens.

is dit ook ironisch bedoeld eab?

Nee, ik ben altijd serieus. Ooit gesproken met een jonge klimaat wetenschapper. Dat de aarde binnenkort vergaat door co2 was voor hem een wetmatigheid waarover niet gediscussieerd mocht worden. Voor het werk kom ik altijd mensen tegen met stellige uitspraken. Mijn standaard antwoord is dan “je weet het niet, en als je het niet weet kun je er geen uitspraak over doen”.

Dat er een koppeling is tussen een bosbrand aan de andere kant van de wereld en een windmolen in de achtertuin hier is wel hoe het verkocht wordt.

Ook dat het warmer wordt door de mens is eenvoudig aantoonbaar. Als je s nachts door het land rijdt en je komt bij Amsterdam is het zomaar 3 graden warmer. In de stad nog meer. Daar zitten een hoop mensen die co2 uitstoten.

Het idee van gasloze en duurzame verwarming zal bijvoorbeeld best gaan werken. In zeewolde staat een datacenter gepland van 260 hectare. Dat gaat een veelvoud van de stroom van Amsterdam opnemen en in warmte omzetten. Zeewolde zal een plaats worden waar de inwoners er warmpjes bij kunnen gaan zitten met zo’n mooie kachel in hun midden. De eigen huiskachel kan dan uit. Dat dit door de mens en zeker door de lokale wethouder voor duurzaamheid veroorzaakt wordt geloof ik wel.

Dat 2030 een kantelpunt is geloof ik ook wel. Het land is dan volgepropt met windmolens en zonneparken en dat jaar is het einde inzicht van de subsidies die dan tien jaar geleden door wiebus zijn toegekend. Omdat alle stroom verkocht is aan buitenlandse partijen en de klimaat impact van het Nederlands beleid inderdaad de voorspelde 0.0003 graad zal halen blijkt er tot 2050 nog veel meer subsidie nodig te zijn. Als dat niet gegeven wordt zal dat catastrofale gevolgen hebben voor de partijen die er op zitten te wachten. Hun business model is daarop gebaseerd. En voor sommigen komt die catastrofe eerder. Neem alleen al de tesla rijders die een auto van de zaak kregen met nul bijtelling. Voor hun is het een domper dat er betaald moet gaan worden. Ja ik geloof dus ook ook in de catatrofale toekomst.

Klimaat vluchtelingen geloof ik ook in. Nu er een uitlevering verdag komt tussen Dubai en Nederland wordt het voor sommige inwoners aldaar te heet onder hun voeten en vluchten ze nu naar bodrum, bron Telegraaf. Ja het klimaat voor hun veranderd nu.

Ook staan er miljoenen vluchtelingen klaar in noord Afrika die van een duurzame uitkering in noord west Europa willen genieten. Het leef klimaat is hier stukken beter dan in de zandbak aldaar.

Dat het hier ook door klimaatverandering opwarmt kunnen we dagelijks vernemen. Je hoeft alleen maar te kijken naar de verhitte discussies in den Haag en Washington en de absolute ontkenning door de andere partijen. Het discussie klimaat is er niet op vooruit gegaan. Dit verschijnsel zien we in de hele westerse wereld.

Conclusie

Ja er is klimaat verandering.

Het verhit de boel

Het is door mensen veroorzaakt

Het kan catastrofale gevolgen hebben

Ik probeer daar serieus mee om te gaan.

niet doen, Eab,

zelfs niet proberen,

zelfs niet als iedereen aan je kop zeurt

Wat het kantelpunt betreft dan dit :

In de streken die naast een dag/nacht ook een zomer/winter cyclus kennen is de temperatuur span tussen maximum en minimum temperatuur in de orde van 40°C en meer, zeg bijvoorbeeld -10 tot +30 °C , neem zelfs aan dat de gemiddelde temperatuur 2°C stijgt dan is dit -8 tot +32°C is dit echt zo dramatisch, waar kan je daar een kantelpunt in zien? , de aarde heeft veel grotere temperatuurvariaties meegemaakt in haar 4 miljard jaar bestaan en leven is er nog steeds , zij het soms door aanpassingen, species zijn er nog steeds maar een aantal zijn vervangen door andere beter aangepast aan de nieuwe situatie

Die klimaat modellen waar ze steeds aan sleutelen maakt velen gek omdat ze denken dat het een vast gegeven is wat er uit komt, en daardoor waant ieder zich klimaat wetenschapper schijbaar, omdat de computer het zegt.

Neem Sir David Attenborough de bekende documentaire maker, een bioloog, die verteld nu het ene dramatische klimaat verhaal na het ander, ineens weet hij er alles van, laat beelden zien van zijn vroegere opnames en verteld de meeste alarmistische doemverhalen, en soms monteert hij er nog wat verschrikkelijke beelden bij.

Ik denk dat hij gewoon gegrepen is door het klimaat alarmistische geneuzel.

En zo wordt de wereld beetje bij beetje gedrogeerd.

Lytton (Canada), waar het onlangs 49 graden was is inmiddels zo goed als volledig afgebrand

Kennelijk heeft dat niks te maken met dat er een rivier naast loopt, de Fraser, die men niet gebruikt voor preventief of actief blussen de Lytton Fire Base in Lytton niet bemand was en geen aperatuur had.

De meeste huizen van hout zijn.

Alle stroom leidingen bovengronds lopen.

Omdat het in een dal ligt en er geen uitvalswegen vrij zijn.

Of komt het omdat men besloten heeft niks te doen aan een brandje verderop vanwege de geïsoleerde ligging?

Het komt allemaal door de temperatuur 3 dagen geleden die al in de klimaatmodellen van modelleur stonden.

Modeleur

Wat weet jij wat de lokale mensen niet weten.

Verslaggevers ter plekke gaven life aan dat er al 3 dagen een bosbrand was maar dat ze niet wisten wat de oorzaak was van de brand in het dorp.

“Officials suspect train caused fire

Hildebrand said officials have a suspicion as to how the fire started. “It’s still not confirmed, but it appears a train may have sparked the blaze,” he told CBC News.”

Tevens heb je eens gekeken naar de overzichtsfoto die gemaakt is na de brand.

Bijna alle bomen die verder dan 5 meter van een huis staan zijn nog prima zichtbaar en groen.

Bijna alle huizen zijn tot de grond toe afgebrand.

https://nos.nl/artikel/2387655-canadees-dorp-dat-hitterecords-brak-in-de-as-gelegd

Enig idee hoe dat komt?

Zijn de huizen door jouw 49 graden uitgedroogd en de bomen niet of zou er een andere reden zijn van dat brandpatroon?

Zou het iets te maken hebben met de houten constructie en kunststof bekleding buiten en de stroomdraden die overal los hangen.

Ik wacht met smart op de attributie studie die jij hier volgende week zal presenteren die alles logisch zal verklaren.

En vooral waarom dit in het klimaat van 50 jaar geleden niet gebeurt zou zijn.

Hopenlijk ben je de volgende keer iets minder uitbundig als een dorp verbrand nadat het erg warm geweest is.

Ben jij het weer eens Hiemstra? Bij hem strijden gereformeerd triomfalisme en wetenschappelijk zindelijk denken ook altijd om voorrang. Meestal verliest de zindelijkheid.

En welk model heeft dat voorspeld of was het gewoon een samenloop van omstandigheden (La Niña)?

Rien,

Ik denk dat je helemaal gelijk hebt met “samenloop van omstandigheden”

Kuipers Munneke deed een voorzichtige poging dit op dinsdag in het 20:00 journaal te laten zien, door te wijzen op de straalstroom boven Canada, die aan de basis lag van aanvoer van warme lucht via het hogedrukgebied dat hierdoor ontstond.

Simpel het weer, daarom is het extra pijnlijk dat een figuur als Modeleur, ondanks dat hij kennelijk zeer deskundig is, ook hierboven opnieuw een weerverschijnsel en een brand gebruikt om dit te koppelen aan klimaat.

Juist die schommeling van de straalstroom is niet eenvoudig aan klimaatverandering te koppelen.

Dat hier een uitzonderlijke warmte was is overduidelijk, waarom die straalstroom en het hogedrukgebied juist zo persistent waren is veel minder duidelijk.

Hieronder een link naar het gebied op 30 juni 01:00 UTC. (29 juni 13:00 LT) , waar de straalstroom op 11 km (250 mb) goed te zien is.

Tevens door de datum te veranderen naar b.v. 25 juni 01:00 UTC ( 24 juni 13:00 LT), het begin van deze bijzondere situatie is te zien.

https://earth.nullschool.net/#2021/06/30/0100Z/wind/isobaric/250hPa/orthographic=-111.04,45.99,504/loc=-122.251,51.876

“een weerverschijnsel en een brand gebruikt om dit te koppelen aan klimaat”

De uitkomst van de attributie analyse komt volgende week. Dan is er meer duidelijkheid hieromtrent.

De onderzoeksgelden zijn al binnen?

Of zijn attributie analyses na AR 5 zo “gewenst” dat geen Modeleur meer een baangarantie heeft zonder de juiste uitkomsten te leveren.

En kom niet met een verhaal dat, omdat het temperatuur verschil tussen de evenaar en de pool kleiner is geworden, dat daarom de kans op een meer meanderende straalstroom in de zomer groter is geworden, waardoor dat de kans op een hogedruk gebied verhoogd, waardoor de kans dat die stationair is licht hoger is, zodat de kans op aanvoer van warme lucht groter is, waarbij de kans dat dit een record warmte geeft ergens op aarde groter wordt.

Aanvulling voor de negatieve duimpje gever.

Misschien kan er ook even een uitleg bij komen waarom de temperatuur 100 meter boven de grond soms wel 5 graden hoger was gedurende bijna de hele dag en dat de overheersende noord zuid ligging van de bergketen er niks mee te maken had zodat alles door klimaat verandering kwam en dat je even opgezocht hebt dat eerdere periode met langdurige zuiden wind in juni eigenlijk onmogelijk waren in de afgelopen 80 jaar voor 2000 en pas nu door klimaatverandering toegewezen kunnen worden aan deze 6 dagen sinds 25 juni.

Ik ben benieuwd.

Wat een merkwaardige reactie, Lo. Weet je wel wat attributie is?

“De uitkomst van de attributie analyse komt volgende week. Dan is er meer duidelijkheid hieromtrent.”

In Amerika zijn er juristen die de politieradio volgen om te weten wanneer de ambulances uitrukken zodat ze gelijk hun diensten aan kunnen bieden voor een proces tegen wie dan ook.

Die staan bekend als een Amulance chaser.

Ik heb eerder een model eens beschreven als een rolstoel waar je niet meer uitkomt.

Modeleurs die een warmte record met daaropvolgende brand volgen om attributie studies te kunnen opzoeken, gedragen zich als de Ambulance chasers van de CAGW.

“attributie studies opzoeken”?

Je hebt echt geen idee wat attributie is. Begin hier eens

https://www.knmi.nl/over-het-knmi/nieuws/snelle-duiding-van-extreem-weer

En vervolgens is er in de wetenschappelijke literatuur voldoende over te vinden.

“attributie studies opzoeken”?

“Je hebt echt geen idee wat attributie is.”

Dat doe je niet?

Het eerste wat je doet is een link geven aan de methode van een attributie studie die vol staat met links naar attributiestudies, om te bewijzen dat je geen link zal opzoeken die een attributie studie zal geven?

Je attributiestudie volgende week zal alles verklaren.

Alleen volgende week “attributie studies opzoeken”? voor deze gebeurtenis, nee dat zal je niet doen.

je snapt het niet. Volgende week komt er duidelijkheid. Even geduld nog.

Modeleur,

En jij denkt dat brand door een hittegolf komt?

Nee hoor dat heeft er niets mee van doe, het kan er wel door verergeren, maar dan moet je wel eerst brand hebben.

Het draait allemaal om het vlampunt, door een hittegolf kun je dat wel sneller berijken, maar of het nu 10 of 20 graden warmer buiten is maakt niets uit, zonder vuur geen brand.

Kijk een naar hooi en stro, zelfs een lucifer vliegt nog niet eens in de brand.

Stof normale ontbrandingstemperatuur in °C

Nylon 510

Polycarbonaat 570

Polyethyleen 350

Polystyreen (isomo) 490

Polyurethaan 420

pvc 470

Teflon 600

Hout 250 – 350

Papier 200 – 350

Katoenweefsel 300 – 400

Wol 570

Paraffine / Stearine 160

Rubber 360

Kunstrubber 200 – 400

Houtskool 140 – 300

Steenkool 350

Hooi 230

Turf 230 – 450

Stro 240

Was 300 – 400

Lucifers 160 – 180

Ik denk dat dit een ietwat optimistische benadering van de geschiedenis is. Euforisch welhaast. Ik mag zelf ook graag met liefde spreken over de eerste computer die ik onder handen kreeg, 1965, en waar je voor en achteruit mee kon fietsen.

Lesroosters deden we al. En dat stond uren te draaien.

’t Was natuurlijk drie keer niks vergeleken met wat we nu hebben.

En wat we nu hebben is nog altijd drie keer niks met wat we willen hebben – deep blue ten spijt.

Het verschil ook tussen klimatologen en astronomen. De laatste berusten volmondig in het feit dat ze geen goeie computers hebben. Govert Schilling heeft dat een keer mooi beschreven. Hun model werkt met 7*10^9 deeltjes. Volgens onze verslaggever kun je daar nog niet eens de geboorte van een ster mee simuleren, laat staan een Galaxy op poten zetten, terwijl we het over bekende fysische regels hebben.

Nu dus.

En vroeger?

De snelheid.

De omvang van het geheugen.

De stabiliteit en de noodzakelijke “vertroeteling” daarvoor.

De programmeringservaring.

Factoren die ook de testmogelijkheden beïnvloedden.

Ik denk dat de euforie, de verliefdheid ook op wat je met die vermaledijde computers allemaal wel niet kon doen, zelf kon doen … het beste zichtbaar is in deze zin.

Maar er wordt helemaal niks uitgelegd. Nog steeds niet!

Mijn persoonlijke opvatting is dat dat niet ondanks, maar vooral dankzij die modellen, dankzij het fixeren op die modellen, nog geen centimeter vooruitgang hebben geboekt met het uitleggen daarvan.

Mijn ervaring is dat er niks moeilijker is dan een goed model te maken in de computer en dan heb ik het over zaken die duidelijk minder chaotisch zijn dan het weer en/of klimaat.

We hebben een record warme juni achter de rug met een gemiddelde temperatuur van 18.23 graden. Opvallend is dat juni 1917 een gemiddelde temperatuur had van 17.67 graden. Dus sinds 1917 is het record maar liefst 0.56 graden gestegen, maar dat is veel minder dan de vermeende opwarming sinds die tijd.

Overigens is in juni geen enkel dag record gesneuveld en met 1 tropische dag is het verder een vrij normale maand. De hoge temperaturen zijn vooral te verklaren door de hoge nachttemperaturen:

https://www.knmi.nl/kennis-en-datacentrum/achtergrond/warmte-eilandeffect-van-de-stad-utrecht

En dat effect was in 1917 veel kleiner.

Is de mens verantwoordelijk voor de opwarming: ja, maar in hoeverre CO2 hierin een rol speelt is de vraag.

Die vraag ga je niet beantwoorden door naar 1 maand van 2 verschillende jaren te kijken.

Modeleur gaat die vraag wel beantwoorden door naar 3 dagen warmte in Canada te kijken en vervolgens een brand, die 3 dagen niet serieus aangevallen is, gelijk op te voeren als bewijs, van CAGW.

Ja ja, Modeleure is een oprechte man, met een duidelijk wetenschappelijke blik.

Stropopje aan het bouwen, Lo?

Albert, opvallend dat in deze “record” warme juni, ik de ventilator op mijn slaapkamer niet heb gebruikt.

Ga je ons nou ook al deelgenoot maken van wat zich in je slaapkamer afspeelt, Hans?

En het serieuze antwoord: kijk even naar het verschil tussen juni en juli. Juni 2021 was record warm (18,2 graden), dat was nog altijd onder de normale temperatuur van juli (18,3). Bovendien: de grootste positieve afwijking was in het eerste (en dus normaal het minst warme) deel van de maand.

http://www.logboekweer.nl/Temperatuur/DeBilt_Temp.pdf

Ja ik dacht al, het voelt een halve graad warmer aan dan die zomer van ruim 100 jaar geleden. Dus ik had toch gelijk, mooi he

Het vermeende juni-record voor juni 2021 (18,3 graad C) komt niet in de buurt van de juni-waarden juni 1889 (18,8 graad C), juni 1858 (18,8 graad C) en juni 1781 (18,5 graad) C) – met de kanttekening dat het bij de waarden voor 1901 gaat om niet gehomogeniseerde waarden.

Kortom, lokale records zijn er met name om gebroken geworden… en zeggen fundamenteel bezien niet zo gek veel over klimaatverandering omdat deze vooral samenhangen met uitzonderlijke omstandigheden.

PS. Het eerste half jaar van 2021 heeft voor de Bilt slechts de no.20 warmste waarde van de afgelopen 25 jaar opgeleverd.

En mondiaal was de eerste helft van 2021 koeler dan de eerste helft van de afgelopen 5 jaar en ligt op koers om koeler te gaan eindigen dan de afgelopen 6 jaar, zie:

http://klimaatcyclus.nl/klimaat/pics/2021-CFSR-global-temperature-with-other-datasets.jpg

De maandwaarden vanaf 1701 staan hier beschreven:

https://www.wintergek.nl/data/lijst-gemiddelde-temperatuur-nederland

Vraagje die thermometers uit 1917, hoe nauwkeurig waren die eigenlijk? Kijk dat je een gemiddelde kan uitrekenen is mij ook duidelijk, maar in 1917 twee significante cijfers achter de komma heb ik toch mijn bedenkingen over. Moet toegeven dat het lang geleden is dat ik natuurkundige metingen op mijn opleiding gedaan heb, maar wij hadden eind jaren 60 nog alcohol thermometers en die kon je schatten op 0.1grC maar meer resolutie hadden we niet, laat staan 50 jaren er voor. Waarmee ik wil zeggen dat er erg makkelijk met getallen gesmeten word maar hoe reeel zijn die eigenlijk.

Rien volgens mij krijg je die getallen alleen maar door homogenisatie toe te passen.

Die alcohol meters weken ook af.

Is toch allemaal natte vingerwerk met die temperaturen tot er goed geijkte meetinstrumenten waren.

Grappig op een serieuze vraag een minnetje geven, afijn bij gebrek aan een antwoord moet ik constateren dat er een waas van geheimzinnigheid omheen hangt en die moet vooral in stand blijven, ook prima hoor.

“maar wij hadden eind jaren 60 nog alcohol thermometers en die kon je schatten op 0.1grC maar meer resolutie hadden we niet”.

Dat hoeft ook niet. De kwaliteit van een waarnemingsreeks wordt door andere dingen bepaald. De meetopstelling (type thermometerhut, meethoogte), de omgeving en de meetfrequentie.

Vaak zijn oudere gegevens daardoor niet goed met de nieuwe metingen vergelijkbaar. Het KNMI heeft dat geprobeerd op te lossen door de meetgegevens van voor 1951 te ‘homogeniseren’, maar zoals bekend levert dat ook een hoop gedoe en onzekerheid op.

nee, Bart Vreeken,

Dat levert niet “ook een hoop gedoe en onzekerheid op”. Althans, dat doet het wel, maar dat is niet de juiste karakterisering.

Het is de suggestie van nauwkeurigheid die er niet is, het is de suggestie dat je reële data aan kunt passen aan betere inzichten, het is ook de suggestie dat je proxydata nauwkeuriger is dan de meethutten van voor 1950. En daar zijn nogal wat wetenschappers verbolgen over, en het zou de klimatologie, en aanpalende wetenschappen sieren als ze dat kon erkennen.

Bovenal, als je lijntjes wilt trekken van 2000 jaar tot 500 miljoen jaar, dan is het bitneuken van de eerste orde, een wetenschapper onwaardig.

“Het is de suggestie van nauwkeurigheid die er niet is”

Daar ben ik het mee eens. Die conclusie hadden we op het weer- en klimaatforum weerwoord.be al getrokken lang voordat Marcel Crok etc. daarmee kwamen.

https://www.weerwoord.be/m/2227437

De constatering van het KNMI dat de gegevens van voor 1950 niet goed vergelijkbaar zijn klopt wel; alleen de homogenisering is niet op zo’n exacte manier uit te voeren. De gebruikte methode roept overigens ook vragen op. Maar de metingen zijn daarmee niet waardeloos. Voor de gemiddelden zal er een onzekerheidsmarge in zitten van een paar tienden van graden; voor de extremen (met name de maximumtemperatuur) wat meer. Zie het probleem met de aantallen hittegolven.

De reconstructie van het paleoklimaat in de geschiedenis van de aarde is een heel ander verhaal. Dan heb je het over proxies en niet over metingen. Niettemin is dat een serieus wetenschappelijk vakgebied, iets wat Leonardo zich kennelijk niet kan voorstellen.

wou je me iets in de mond leggen, Bart?

Albert, inderdaad; de mens is verantwoordelijk voor de opwarming. Dat moge duidelijk zijn.

Heeft iemand de cijfers over de urbanisatie van in dit geval Utrecht sinds 1917.

Mocht het effect van die urbanisatie inderdaad voor een flink deel verantwoordelijk zijn voor de gruwelijke en levensbedreigende opwarming, dan stel ik bij deze voor om maar weer eens een stevige oorlog te beginnen, waarbij minstens de helft van de bevolking om het leven komt en de grote steden voor minimaal 70% worden platgebombardeerd.

Het zal niet leuk zijn maar zo verder gaan betekent het einde van de mensheid.

Mocht dat niet haalbaar zijn, dan stel ik voor om bij de volgende verkiezingen de deugpartijen te elimineren en gelukkig is ook D66 daar zelf al mee bezig met hun leuke docu’s en het terughalen van lieve gesluierde vrouwen en zo.

@AnthonyF 2 jul 2021 om 10:59- Dit kan wat ophelderen: https://www.climategate.nl/2019/04/selectieve-aanpassing-temperatuurreeksen-knmi/

Heer Hetzler, inderdaad.

Maar ja, wat wil je dan ook in een land waar bij een documentaire over een deugmens iedereen en zijn moeder even mag bepalen wat er wel en niet mag worden uitgezonden.

Tenslotte is dat normaal bij alle grote leiders zoals Adolf, Josef, Mao, Fidel, Vladimir en nog wat van die superdemocraten.

Als je de relaties niet weet van de factoren die het klimaat bepalen, is ieder model waardeloos. En dat blijkt in de praktijk dan ook, hoe ingewikkeld je een model ook maakt. Maar wel een heerlijk middel om paniek te zaaien. We zien hetzelfde bij de medische modellen mbt Corona. En die domme politici omarmen maar wat graag modellen. Het ontslaat ze immers van eigen verantwoordelijkheid.

Heer Pieter,

Ook de invoering van het communisme in Rusland en later Oost -Europa was de invoering van een model; zij het een politieke en op papier. Helaas zijn er toen in de loop der zeer korte tijd wat probleempjes ontstaan bij de invoering van dat systeempje; voornamelijk door het niet meenemen van het primair menselijk gedrag in hun rekensommetje welke opgelost werden door een straf modeldwingend bewind in te voeren wat tot een wrede dood van miljoenen mensen geleid heeft. Opvallend is dat het klimaatmodel, net als het communistische model, omarmd wordt door voornamelijk links gedachtengoed wat zoals gewoonlijk ‘problemen’ , waar zij zelf deel van uitmaken, bij anderen neerlegt om toch vooral maar binnen de begrenzingen van HUN model te kunnen blijven.

Er is maar een oplossing voor het klimaatprobleem in Nederland en dat is de helft van de bevolking te laten emigreren. Moet geen probleem zijn voor de ECB en hun filiaal de Nederlandse Bank; ze drukken er maar wat van die Mickey Mouse Euro’s bij en klaar is Kees.

Idd dat wist met in de jaren 1950 al, maar ja vooral niet luisteren he. Politici toen hadden het wel door maar ach tegenwoordig weet men het beter en de Kompjoeter voorspelt het wel. Even vergetende dat de Kompjoeter iets uitrekent wat een (groepje) mens(en) bedacht heeft en niet alle mogelijkheden zitten in het bedachte algoritme kortom faal bij voorbaat verzekerd.

De schaalvergroting heeft het tijdelijk opgelost maar het probleem blijft. Landbouw los je op met EU en rijkdom met, met de top van de economie meedoen. Dat Nederland dan een stadsstaat wordt zonder culturele bijzonderheid, blijvend afhankelijk van anderen, met een anderscultureel proletariaat en een belevingskwaliteit van HongKong en een eeuwigdurende mobiliteit om alles te ontvluchten of bij te blijven, beseft men niet. Het is een architectenfout tot de derde macht: u vraagt, wij bouwen, resultaat is race to the bottom maar wij zijn niet meer dan uitvoerders. Dat krijg je met een te hard lopende cultuur: kans op foute afslag en dan ben je alles kwijt.

Alle klimaatmodellen die naar de toekomst zijn gericht zijn niet zo betrouwbaar. En dit komt gewoon omdat we niet weten hoeveel kooldioxide nog in de atmosfeer zal worden ingepompt. De mens wil naar klimaatneutraliteit en dat wil zeggen dat er geen extra kooldioxide nog zal worden ingepompt in de troposfeer. Maar is het haalbaar? Dat is een andere vraag. Ook de oceanen geven hun warmte zeer traag af en dat weten we. Dus afkoeling zal er nog niet snel komen. en hoe ouder de zon, hoe heter ze zal worden. Dus het klimaatsysteem en de deelsystemen zijn zeer complex, en kunnen we wel alles netjes doorgronden???

Beetje off topic, maar de gemoederen worden al heet bij de groene molen fantasten door de nieuwe molenwet.

Ik verwacht wel dat ze hier weer mazen vinden om die wet te omzeilen.

https://www.rijnmond.nl/nieuws/1283994/Uitspraak-bestuursrechter-over-windmolens-geeft-Barendrechtse-advocaat-nieuwe-hoop

Wat klimaat “wetenschap” ons leert; en wat het klimaat doet. Een filmpje van 6 minuten:

https://youtu.be/PYZmpa2bVRk

Kees le Pair

Mooi is dat. Weer even met beide benen op de grond. Dank voor de link. Worden deze filmpjes door YouTube ook regelmatig weggepoetst? Of durft men dat bij Tony Heller niet aan?

Kees le Pair

Bedankt voor de relativerende link.

Ik had mijn reactie al geschreven voordat ik de video van Kees Lepair had gezien.

Het gaat eigenlijk over precies hetzelfde. Ze gaan de schuld van de droogte op de arme mensen afschuiven.

Lijkt mij in USA zijn de droogte tijden nu echt aangebroken:

Geen vuurwerk op July 4:

https://wattsupwiththat.com/2021/07/02/over-150-fire-scientists-urge-the-us-west-skip-the-fireworks-this-record-dry-4th-of-july/

Ik had met mijn eigen model de aankomende droogte tijden toch aardig goed ingeschat? Of niet dan soms?

https://www.climategate.nl/2019/10/84861/

Maar nou gaan ze daar natuurlijk net zoals ze dat hier deden, tijdens onze droogte, zeggen dat het allemaal gewoon JOUW schuld is.

Ja. Ja. Mens gemaakte warmte = mens gemaakte onzin

Let op mijn woorden. Natturlijke droogtes zijn van de kaart af weg geveegd.

Re: “De massa van de atmosfeer is gelijk aan alleen de bovenste 10 meter van de oceaan; de oceanen hebben veel meer traagheid dan de relatief snelle atmosfeer.”

Waarvan water ongeveer 0,25% van de atmosfeer betreft; de hoeveelheid komt overeen met ongeveer 2,5 cm van het bovenste gedeelte van het oceaanoppervlak.

Deze verhoudingen geven een mooi beeld van hoe de atmosfeer zich verhoud tot het oceaan systeem, waarvan het diepste punt bij de Mariana Trog wordt aangetroffen op een diepte van bijna 11 km.

Martijn

Interessant?

https://emea01.safelinks.protection.outlook.com/?url=https%3A%2F%2Fwattsupwiththat.com%2F2021%2F07%2F02%2Fgreenland-ice-core-co2-during-the-past-1000-years%2F&data=04%7C01%7C%7C02642544ac604743f89108d93d7b1128%7C84df9e7fe9f640afb435aaaaaaaaaaaa%7C1%7C0%7C637608421037479316%7CUnknown%7CTWFpbGZsb3d8eyJWIjoiMC4wLjAwMDAiLCJQIjoiV2luMzIiLCJBTiI6Ik1haWwiLCJXVCI6Mn0%3D%7C1000&sdata=ZC%2FoEM8VORRPb5kYYOvedDjgrM5OEFKRMt9ZzYSY3Vg%3D&reserved=0

Martijn van Mensvvort

En voor degenen die willen opmerken dat de Marianentrog een enkel dieptepunt is, gemiddeld zijn de oceanen ruim 3600 meter diep.

Dat kun je dus met recht een bak water noemen. Waard om rekening mee te houden.

van Mensvoort dus. Sorry.