Door Ad Huijser.

Als mensheid staan we door CO2 aan de rand van de afgrond. Dat is de boodschap die al jaren klinkt en met mijn ‘Club van Rome-achtergrond’, dacht ik er een tijd lang ook zo over. Totdat ik na mijn pensionering als Chief Technical Officer bij Philips de tijd kreeg om er eens écht in te duiken. En dan ontdek je al snel dat het hele idee van een klimaatcrisis voornamelijk gebaseerd is op circumstantial evidence. Het klimaat kun je niet, ook niet gedeeltelijk, in een laboratorium simuleren, laat staan dat je er in de natuur mee kunt experimenteren. Onze kunde van het uiterst complexe fenomeen ‘klimaat’, is dus louter gebaseerd op observaties en de (huidige) interpretaties daarvan. misschien allemaal best plausibel, maar wel op basis van onze, nog altijd beperkte kennis van het klimaat. maar ook op basis van niet-bewezen aannames, wankele modellen en een veel te korte periode van betrouwbare observaties. Gelukkig zijn er nog wel wat geïnteresseerde outsiders, meestal gepensioneerde wetenschappers die voor hun dagelijks brood niet meer afhankelijk zijn van het vergaren van onderzoeksgelden, die weten dat de klimaatwetenschap verre van settled is.

Kippen zonder kop

Er wordt ons door een continue stroom van eenzijdige berichtgeving, voortdurend een klimaat-crisis aangepraat. Onder dat mom wordt inmiddels de grootste onzin verspreid. Zolang die maar laat zien hoe catastrofaal klimaatverandering wel niet is, wordt dat soort nieuws ongefilterd en ongecheckt door de mainstream media klakkeloos, als echoputten doorgegeven.

Voor jongeren is CO2 inmiddels het ergste gifgas dat ze kennen. Dat uit zich regelmatig in scholierenprotesten tegen het klimaat. Bij mij roept dat altijd vragen op als: weten die jongelui waar ze precies tegen protesteren en wie organiseert zoiets? Laten we het er maar op houden dat de jeugd zich zorgen maakt over de toekomst. Dat begrijpen we allemaal wel.

Voor jongeren is CO2 inmiddels het ergste gifgas dat ze kennen. Dat uit zich regelmatig in scholierenprotesten tegen het klimaat. Bij mij roept dat altijd vragen op als: weten die jongelui waar ze precies tegen protesteren en wie organiseert zoiets? Laten we het er maar op houden dat de jeugd zich zorgen maakt over de toekomst. Dat begrijpen we allemaal wel.

Het mediageweld waar de jeugd mee te maken heeft, is nu echter wel een orde groter dan in mijn tijd. Als men niet snel het gebruik van alle fossiele brandstoffen verbiedt, is er rond 2100 geen menselijk leven meer op aarde mogelijk. Als je dat allemaal te pas en te onpas, jaar in jaar uit, te horen krijgt als je opgroeit, weet je niet beter. Zo werkt brainwashing nu eenmaal.

Maar kennelijk werkt het net zo bij journalisten. Het lijkt wel of niemand bij die zogenaamd kritische en objectieve traditionele media, zich bij dat soort klimaatalarmistische berichten nog afvraagt wat er zoal van waar is. Dat is ook moeilijk als je niet weet hoe het klimaat ongeveer werkt. Al met al is het een levensgevaarlijk mix van weinig kennis en veel emotie. Ook bij onze beleidsmakers, die onder druk van de publieke opinie dat ze nu toch echt actie moeten nemen, als kippen zonder kop maatregelen voorstellen die vaak gebaseerd zijn op onwetendheid en het drijfzand van illusies.

Club van Rome

Club van Rome

Niet lang nadat ik als jong fysicus in 1968 was afgestudeerd kwam het rapport De grenzen aan de Groei van de Club van Rome uit [1]. Daar werd je, als iemand met alle toekomst nog voor zich, echt niet vrolijk van. Je vroeg je, net als de jeugd nu, af waarom er niemand actie nam om de daarin voorspelde rampscenario’s zo snel mogelijk af te wenden. Ook toen hadden we kennelijk nog maar weinig tijd om de aarde te redden. Gelukkig kreeg het rapport van de Club van Rome in die tijd maar relatief weinig publicitaire aandacht, want anders was ons ook toen al zoiets als een mondiale afvalcrisis aangepraat.

Het waren overigens fascinerende modelberekeningen van de Club van Rome; de eerste in hun soort, met een mondiale aanpak. Ze voorspelden dat we qua grondstoffenverbruik aan de grenzen van onze groei waren gekomen. Zonder aanpassingen zouden we bovendien bijna letterlijk omkomen in ons eigen afval. Het gaf ons een idee waar de aarde, en dus ons leven, heen zou gaan als we onze maatschappij en bijbehorende levensstijl, niet drastisch zouden veranderen. In die zin, niet veel anders dan de basis van de hedendaagse ‘klimaatcrisis’.

Dergelijke toekomstbeelden waren toen, en zijn ook nu bij het klimaat, niet meer dan de uitkomst van modelberekeningen op basis van een aantal aannames. De gemiddelde leek denkt al gauw dat die een goed-bekende wetenschappelijke basis hebben en niet zijn ingegeven door een bepaald wereldbeeld van degene die het model bouwde. Dat laatste is echter meestal wel het geval en maakt dit soort modellen altijd gevoelig voor een gewenst resultaat. Dat hoeft niet eens de (politiek bepaalde) intentie van de modelleur te zijn; het sluipt er vanzelf in. Door onder andere de per definitie subjectieve beoordeling van de modelleur over wat wél, en wat niet wordt meegenomen in de diverse parameters en afhankelijkheden binnen het model. Bovendien geldt: wat je niet weet, kun je ook niet in je model stoppen. En we weten helaas lang niet alles van ons klimaat en wat het zoal drijft. ‘Al met al is het een levensgevaarlijk mix van weinig kennis en veel emotie.’

Wereldpopulatie

Voor het rapport van de Club van Rome was de basis vooral de voorspelde groei van de wereldpopulatie. Een planeet als de aarde, die dankzij een sterk verbeterde gezondheidszorg, een bevolking moest accommoderen die rond het jaar 2000 een factor vijf (!) groter zou zijn dan in 1900. Dan krijg je ongetwijfeld te maken met problemen qua grondstoffen, voedselproductie en huisvesting, maar ook qua afval. Daarover nadenken was toen echt wel urgent. Modellen maken dan zowel problemen, als mogelijke oplossingen, beter inzichtelijk. Maar daarbij moet je wel altijd blijven beseffen dat modellen niet de werkelijkheid zijn.

Het is gelukkig allemaal niet uitgekomen, niet zozeer omdat de problemen die men modelleerde niet bestonden, maar omdat de wereld toch wat anders reageerde dan gedacht. Bovendien, in de loop der tijden zijn er ook oplossingen gekomen om een aantal terecht gesignaleerde misstanden, stap voor stap aan te pakken. Lang niet alles is opgelost; zo verzieken we als mensheid de aarde nog altijd met veel te veel zwerfplastic en ander onnodig afval door verkwisting van grondstoffen in onze wegwerpmaatschappij. Maar oplossingen voor het merendeel van de problemen zijn er wel.

Vaak ontbreekt de politieke wil of een effectief georganiseerde aanpak. Grootste obstakel: de acht miljard mensen van nu moeten allemaal wel de discipline opbrengen zich ook navenant te gedragen. Naleving is veelal de achilleshiel van iedere maatregel, zeker mondiaal gezien.

Het rapport staat nog altijd prominent in mijn boekenkast en is helemaal stukgelezen. Er staat ook al wel iets zinnigs over mogelijke klimaatverandering in. Ik citeer nog altijd graag de tekst over het mogelijke effect van de toename van de CO2 in de atmosfeer (toen nog hoofdzakelijk gezien als vervuiling) op het klimaat en de aangegeven, simpele oplossing [1, pag.75]:

…”Indien in de energiebehoeften van de mens in de toekomst wordt voorzien door kernenergie in plaats van fossiele brandstoffen, zal de toename van atmosferisch CO2 ten slotte tot stilstand komen, naar te hopen valt voordat [het] enig aantoonbaar ecologisch of klimatologisch gevolg heeft gehad.”

Hadden de politici van toen het rapport maar beter gelezen en/of geluisterd! Dan hadden we inmiddels heel wat minder zorgen over onze energievoorziening. Maar let wel, toen had ons klimaat een heel ander probleem: we hadden geen opwarming maar zaten midden in een wereldwijde afkoeling [2]. Klimaatwetenschappers voorspelden ons toen zelfs een aanstaande (kleine) ijstijd.

En dat is nog maar vijftig jaar geleden! Zo grillig kan ons aards klimaat zijn, en zo slecht ons geheugen.

Ja, het wordt warmer

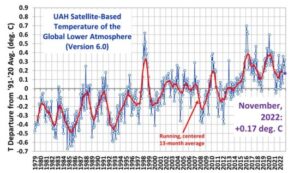

Zeker, het wordt de laatste tijd echt wel warmer. De gemiddelde temperatuur op aarde neemt volgens onze beste temperatuurreeksen, die we sinds 1979 hebben via goede, werelddekkende satellietmetingen met 0,13 graden per decennium toe [3]. Data van vóór 1979 zijn, naarmate ze langer geleden zijn, voor het mondiale gemiddelde steeds onbetrouwbaarder. Vóór de Tweede Wereldoorlog hebben we alleen maar redelijke dekking over de Verenigde Staten en West-Europa.

De langere datareeksen sinds 1850 die nu als ‘mondiaal’ worden gebruikt, zijn in feite berekend op basis van die beperkte gegevens plus klimaatmodellen waarmee de vele open plekken qua temperatuur op aarde kunstmatig worden ingevuld [4]. We weten echt niet erg nauwkeurig wat de gemiddelde mondiale temperatuur in 1900 was; wel de temperatuur van een weerstation in of nabij Londen.

Verder worden er ook nog regelmatig, vroeger gemeten temperaturen aangepast, om misschien wel valide redenen, zoals een verandering van instrumentarium of het verplaatsen van de meetlocatie. Dat heet homogeniseren, maar het is aan de publiekelijk toegankelijke meetreeks vaak niet meer te zien wat de oorspronkelijke data waren, en wat er daarna mee is gebeurd. Zelfs ons KNMI maakt zich schuldig aan dit soort twijfelachtige praktijken: zo verdwenen uit de officiële temperatuurreeksen van De Bilt, een paar jaar geleden, ineens een aantal vooroorlogse hittegolven waardoor het opeens lijkt alsof er tegenwoordig veel vaker hittegolven voorkomen [5]. Dat zie je wereldwijd overal gebeuren. Kunstgrepen om de opwarming erger te maken dan die waarschijnlijk is, moeten we sowieso niet willen en daarom, gewoon vergeten. De opwarming sinds 1979 is voldoende bewijs dat het warmer wordt.

De 0,13 graden per decennium komt neer op zo’n halve graad stijging sinds 1979 en dat was, zoals boven beschreven, net het einde van het global cooling alarm uit de jaren zeventig. Dus laten we ophouden met steeds naar het pre-industriële tijdperk te verwijzen en te roepen dat de aarde sindsdien al meer dan 1 graad is opgewarmd. En ook, om dan vervolgens te stellen dat de (politiek bedachte) magische grens van 1,5 graad opwarming, ons al bijna op een onomkeerbaar punt van rampspoed heeft gebracht.

Het is allemaal niet alleen gebaseerd op onbetrouwbare gegevens, maar geeft ook een totaal verwrongen beeld. In 1975 werd de opwarming van onze planeet nog niet als een probleem gezien. Sterker nog, men vreesde afkoeling. Wij, maar ook de klimatologen van toen vonden dat normaal, net als de Club van Rome. De vraag die dan rest: is dat probleem er nu wél, en zo ja, hoe ernstig is dat probleem eigenlijk? Als we dat beantwoord hebben, komt pas de

vraag moeten we, en kunnen we er wat aan doen?

Al Gore.

Maar het debat daarover heeft nooit plaatsgevonden. Sinds de jaren negentig [6], maar voor het grote publiek pas sinds ongeveer 2006, toen Al Gore op het toneel verscheen met zijn film, An Inconvenient Truth [7], is de boodschap altijd geweest: we staan aan de rand van de afgrond en fossiele brandstoffen zijn de oorzaak. Iedereen die daar sindsdien nog kritische vragen bij stelde, werd categorisch geframed als klimaatontkenner, om vervolgens op de virtuele brandstapel van de (sociale) media, publiekelijk als ketter voor eeuwig te worden afgebrand. Niemand met enige reputatie durft een dergelijke discussie nog aan. Zoals Al Gore het toen al verwoordde: the science is settled ofwel, discussie gesloten.

Klimaatmodellen

Zoals gezegd dacht ik er rond die tijd nog net zo over. Totdat ik dus de tijd kreeg om er eens echt in te duiken, bijvoorbeeld in de waarde van klimaatmodellen. Hun berekeningen worden omgezet in trendanalyses met voorspellingen van de mondiale temperatuur, tot zelfs het jaar 2100 toe. De uitkomsten van die berekeningen zijn echter door bijna niemand te verifiëren. De, wetenschappelijk bezien, echt ingenieuze klimaatmodellen zijn meestal niet eens in staat zijn om het, qua mondiale metingen goed bekende klimaat van de afgelopen vier decennia, met voldoende nauwkeurigheid te reproduceren.

Toch wordt door het IPCC [8], het Intergovernmental Panel on Climate Change van de Verenigde Naties, een van de aanjagers van het klimaatalarmisme, net gedaan of het gedrag van ons aards klimaatsysteem volledig bekend is. Ze baseren hun Anthropogenic Global Warming (AGW)-hypothese (de wereldwijde opwarming door broeikasgassen als CO2 die door de mens in de atmosfeer worden gebracht), daarbij naar eigen zeggen op ‘de wetenschap’. Die wetenschap speelt zeker een rol, maar de rapporten waar iedereen zich qua feiten en conclusies vervolgens op baseert, geven inmiddels nauwelijks of geen ruimte meer aan alternatieve verklaringen voor de opwarming. En die zijn er legio, en ook gebaseerd op adequaat wetenschappelijk onderzoek.

In combinatie met het statement the science is settled, wordt door het IPCC zo de AGW-hypothese als enige waarheid gepropageerd. Met in het verlengde daarvan ook de enig mogelijke oplossing: stoppen met het gebruik van fossiele brandstoffen. Let wel, AGW op basis van CO2 lijkt fysisch gezien best plausibel als (mede)oorzaak van mondiale opwarming, maar het is en blijft niet meer dan een onbewezen hypothese. Hard fysisch bewijs is er nooit voor geleverd, wat het IPCC ook beweert!

De Club van Rome wilde niet verder vooruitkijken dan dertig jaar en zelfs die voorspellingen zijn al niet bij benadering uitgekomen. Het IPCC en de ondersteunende klimaatmodellen pretenderen ongegeneerd honderd jaar vooruit te kunnen voorspellen. Dat terwijl het klimaatsysteem heel wat complexer is dan het voorspellen van het grondstoffenverbruik en de gerelateerde afvalberg die dat tot gevolg heeft, bij een redelijk voorspelbare groei van de wereldbevolking. Klimaatmodellen doen bovendien uitspraken op basis van een aantal aannames die wetenschappelijk simpelweg niet bewezen, gebrekkig onderbouwd of soms zelfs pertinent fout zijn.

Klimaat is niet constant

De belangrijkste, duidelijk foutieve, maar ook misleidende aanname is dat het klimaat de laatste eeuwen in principe constant zou zijn geweest als wij de atmosfeer, door het verbranden van kolen, olie en gas, niet vol met CO2 hadden gepompt. Kortom de natuurlijke variaties van het klimaat zijn volgens het IPCC verwaarloosbaar, en alleen broeikasgassen als kooldioxide (CO2) en methaan (CH4) bepalen de veranderingen in ons klimaat. Een merkwaardige aanname tegen de achtergrond van alleen al de recente historie, waarin we in de laatste duizend jaar zowel een hele warme periode, als een hele koude periode hebben gekend [9]. De uitstoot van CO2 of CH4 had daar, met een aan zekerheid grenzende waarschijnlijkheid, geen enkele invloed op. Ik noemde al de global cooling rond de jaren vijftig tot het midden van de jaren zeventig.

Ik heb nog een CIA-rapport uit die tijd dat de geopolitieke consequenties van die afkoeling in kaart bracht. Vooral het gegeven dat door een halve graad afkoeling de oogsten in de Sovjet-Unie vaker zouden mislukken en de USSR waarschijnlijk gedwongen zou worden tot machtsuitbreiding naar het warmere zuiden [10].

Ik heb nog een CIA-rapport uit die tijd dat de geopolitieke consequenties van die afkoeling in kaart bracht. Vooral het gegeven dat door een halve graad afkoeling de oogsten in de Sovjet-Unie vaker zouden mislukken en de USSR waarschijnlijk gedwongen zou worden tot machtsuitbreiding naar het warmere zuiden [10].

De temperatuurveranderingen waren toen nog niet al te groot, maar we kennen veel prominentere voorbeelden van de natuurlijke klimaatveranderingen in onze recente geschiedenis. De Middeleeuwse Warme Periode (MWP) [9], de tijd dat de steden in Europa opkwamen en de Vikingen Groenland bevolkten, had temperaturen die volgens bijna alle studies soortgelijk of zelfs hoger waren dan we nu meten; net zoals in de Romeinse Warme Periode (RWP), weer zo’n duizend jaar eerder. Het plaatje in mijn geschiedenisboek van de middelbare school van Hannibal die met zijn olifanten in een sneeuwstorm de ijzige en besneeuwde Alpenpassen overtrok, is vast later bedacht. Alpengletsjers waren er toen, net als aan het einde van de MWP, niet zo overdadig als wij ze honderd jaar geleden kenden, of zelfs nu nog kennen [11].

‘Frost fairs’ op de Thames.

In de Kleine IJstijd, met als koudste periode het einde van de 16e eeuw, waren de temperaturen daarentegen gemiddeld zeker een graad lager dan nu. We kennen die periode van de mooie schilderijen met wintertaferelen. ‘s Winters bevroren al onze grote rivieren, maar ook de Theems in Engeland. Het ideale klimaat voor liefhebbers van de Elfstedentocht: ieder jaar geheid een tocht.

Voor de gemiddelde burger was het echter misschien wel de meest ellendige tijd van het laatste millennium, want ongeveer een derde van de mensheid overleefde het niet, vooral door honger en ziekte [12].

Natuurlijke variaties

Klimaatmodellen die we blijkbaar wél vertrouwen ten aanzien van hun voorspellende waarde voor de temperatuur in 2100, kunnen die periodes al terugrekenend totaal niet verklaren, eenvoudigweg omdat ze niet CO2-gerelateerd zijn. Bovendien, sinds de Kleine IJstijd loopt de temperatuur al ruim drie eeuwen met gemiddeld zo’n 0,3 graden per eeuw op. We hebben daar geen wereldgemiddelde meetwaardes voor zoals we tegenwoordig gebruiken, maar wel de langst bekende temperatuurmetingen uit het midden van Engeland, die goed gedocumenteerd (UK MetOffice [13]) teruggaan tot 1659. De bijna vier eeuwen aan dagelijkse temperatuurmetingen laten onde meer zien dat op jaarbasis, natuurlijke variaties van 1 graad ten opzichte van de gemiddelde trendlijn, heel normaal zijn. Op maandbasis zijn die variaties zelfs aanzienlijk (3 tot 5 maal) groter.

Deze data logenstraffen ook de veelgehoorde claim van klimaatalarmisten dat we nog nooit zulke snelle temperatuurstijgingen gezien hebben als in de laatste veertig jaar. Er zijn periodes waarbij de opwarm- of afkoelsnelheid bijna 0,5 graden per decennium was (zie grafiek bij [13]). En niet over een paar jaar, maar decennialang. Wat we nu meemaken aan opwarmingssnelheid stelt nauwelijks iets voor in het licht van de natuurlijke variaties die we daadwerkelijk met kwikthermometers hebben gemeten. En die niet gehaald zijn uit analyses van boomringen [14], zoals door het IPCC gebruikt als bewijs ter illustratie van hun AGW-hypothese, met allerlei slecht-verifieerbare aannames.

Natuurlijke variaties hebben wel degelijk grote invloed op het klimaat, alleen begrijpen we die niet, of onvoldoende. En dat wat je niet begrijpt, kun je ook niet in fysische afhankelijkheden vertalen die je dan vervolgens in klimaatmodellen kunt verwerken. En als CO2 daarom de enige factor is die je in klimaatmodellen laat variëren, krijg je dus in de uitkomsten alleen het effect van CO2 te zien. Dat is geen bewijs dat CO2 de oorzaak is van klimaatverandering, maar alleen een bevestiging van je aannames. En als je het effect van die aannames ook maar een heel klein beetje fout inschat, zit je er na een tiental jaren ook flink naast. Dat is ook precies wat er in deze, Global Climate Model (GCM)-klimaatberekeningen gebeurt [15].

Klimaatmodellen zijn qua achterliggende fysica niet wezenlijk anders dan weermodellen [16], maar dan op mondiale schaal. Van weermodellen weten we dat hun voorspellingen na zo’n dag of drie al behoorlijk mis kunnen zitten. Gelukkig worden bij weersvoorspellingen de berekeningen om de drie uur ververst met de nieuwste meetgegevens, afkomstig van een fijnmazig netwerk van geautomatiseerde weerstations. Wie wil zien hoe goed (of slecht) weermodellen werken, moet maar eens een paar weken iedere dag de bekende expert-pluim van het KNMI [17] volgen. Ik raad u aan dagelijks een screenshot van uw pc-scherm te maken en die na twee weken op een rijtje te leggen. Een echte eyeopener. En dat ligt niet aan de rekenkracht van de supercomputer van het KNMI, maar (deels) aan het gebrek aan kennis over hoe het weer in detail in elkaar steekt. Het chaotische karakter daarvan is ook heel moeilijk in modellen te vertalen.

Stabiel

Daarmee wil ik niet suggereren dat klimaatmodellen helemaal niet werken. Klimaateffecten van bijvoorbeeld broeikasgassen werken gelukkig heel wat minder chaotisch dan de kortetermijn-krachten die het weer bepalen. De fysica erachter, die in de modellen het klimaat in de tijd laat evolueren, is echter niet wezenlijk anders. Die houdt in dat de output van de berekening op basis van de (gemeten) startgegevens, weer de input is voor de volgende stap richting toekomst. En de output van die volgende berekening is weer de input voor de daaropvolgende stap in de tijd, enzovoort, enzovoort. Vandaar dat de afwijkingen tussen berekende en uiteindelijk gemeten waardes ook steeds groter worden. Immers, heel kleine afwijkingen in de startwaardes of in de modellen,worden steeds doorgegeven en vaak zelfs en passant versterkt [18, 19].

Bij weermodellen rekent men bijvoorbeeld in stappen van 30 minuten en past men de startwaardes om de drie uur aan, dus niet meer dan zo’n tien rekencycli. Bij klimaatmodellen werkt dit niet. De berekeningen worden daarom zodanig getuned, onder meer door het aanpassen van de interne, gemodelleerde afhankelijkheden, dat ze zonder enige verandering in de atmosfeer, ook na zeg dertig jaar (iets als 100.000 berekeningscycli) nog altijd een constant klimaat opleveren [20].

Of dat ook de werkelijkheid benadert, is niet gegarandeerd. Het is zelfs zeer twijfelachtig omdat de afgelopen vier eeuwen hebben laten zien dat ons klimaat, zelfs over slechts dertig jaar, helemaal niet constant is. En zeker als je ziet hoe weinig startwaardes (toch echt op basis van gemeten inputwaardes) uiteindelijk na tuning een stabiel klimaatmodel opleveren.

Last but not least: als het dan eindelijk zo’n stabiele situatie oplevert, blijkt de gemiddelde temperatuur van de aarde die er uit komt, veelal tot wel twee graden fout te kunnen zitten ten opzichte van de werkelijkheid [19,20]. Daarom krijgen we bijna altijd alleen maar de zogenoemde temperatuur-anomalieën te zien, de afwijkingen van een berekend of gekozen gemiddelde op een bepaald tijdstip. Als je er dan vervolgens een verhoogde CO2-concentratie in stopt, krijg je natuurlijk mooi het effect daarvan als verandering te zien. Op zich allemaal wetenschappelijk verantwoord, maar het verhult tegelijkertijd de intrinsieke zwaktes van dit soort modellen. Als je model de échte temperatuur al niet kan berekenen, is er kennelijk toch iets niet helemaal goed.

CmiP

Het is dan ook niet verwonderlijk dat er wel honderden van dit soort klimaatberekeningen zijn op basis van een heel groot aantal, significant verschillende modellen. Besef dat in het klimaat ongeveer alles van alles afhankelijk is [21]; dus is er een bijna oneindig aantal combinaties mogelijk.

Voor wetenschapsgroepen over de hele wereld zijn er kennelijk voldoende fondsen beschikbaar om dit soort werk te doen. Je hebt wel minimaal een supercomputer nodig die dag en nacht moet draaien om uit deze uiterst complexe modellen iets zinnigs te krijgen.

Wetenschappelijk gezien is dit interessant en ongetwijfeld knap werk. Maar die massale activiteit in het modelleren van het klimaat, staat in schril contrast met de IPCC-claim dat we het allemaal zo goed weten. Als we het klimaat zo ontzettend goed begrijpen, lijkt wereldwijd één, of hooguit een paar van deze uiterst complexe Global Climate Models, wel voldoende. Kennelijk is dat een foute gedachte want de vele GCM’s zijn echt wel verschillend, en hun resultaten ook.

Gelukkig praten al die onderzoeksgroepen wel met elkaar en vergelijken elkaars resultaten in CMIP, het Climate Model Intercomparison Project. We zijn inmiddels aan de zesde generatie GCM’s toe in CMIP6. Je zou verwachten dat de modellen steeds beter worden en daarmee steeds dichter bij elkaar komen qua voorspellingen. Helaas is dat niet het geval en wat wij dan vaak te zien krijgen, is een middeling over een aantal van die uitkomsten. Dat kennen we ook uit de weermodellen; het is de basis van de afgegeven weersvoorspelling van het KNMI. Men gebruikt daarvoor het zogenoemde ensemble-gemiddelde, waarbij een groot aantal berekeningen gedaan wordt met steeds een kleine variatie in één of meerdere inputwaardes. Het rekenmodel is echter steeds hetzelfde en dan mag je dat zonder bezwaar doen. Meestal werkt het goed en leidt het gemiddelde tot een betere voorspelling.

Middelen van uitkomsten van allerlei verschillende modellen, is mathematisch bezien echter een onzinnige exercitie. Met temperatuurtoenames voor een verdubbelde CO2-concentratie met ongeveer alle berekende waardes tussen de nul en zes graden [19, 20] kom je gemiddeld op zo’n drie graden. Maar wat heb je aan een gemiddelde van geheel verschillende modellen waarvan je weet, dat er maar één goed kan zijn, en misschien een paar bijna?

Stel even dat toevallig net het model dat zes graden stijging voorspelt, correct is, of net het model met nul graden. In beide gevallen zit je met je gemiddelde toch echt drie graden fout. De claim dat de modellen zo goed zijn, is alleen daarom al, een zelfoverschatting van de modellenbouwers. Misschien niet eens van hen, maar dan toch zeker van de schrijvers van de IPCC-rapporten.

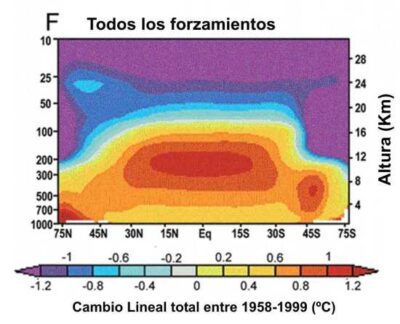

Tropical Hotspot

Uiteraard is het belangrijk om de uitkomst van deze klimaatmodellen te vergelijken met hetgeen we zoal meten en gemeten hebben. Een van de belangrijkste verschillen tussen de modellen en de werkelijkheid, is dan misschien wel het fenomeen van de Tropical Hotspot [22, 23]. Dit extra warme gebied rond de evenaar en hogerop in de troposfeer (het lagere deel van de atmosfeer waar het weer zich voornamelijk afspeelt), wordt in de klimaatmodellen steevast voorspeld, als het gevolg van extra CO2. Het wordt dan ook vaak als de vingerafdruk van de menselijke opwarming door extra CO2 beschouwd.

Maar helaas, temperatuurmetingen op diverse hoogtes via satellieten, maar ook met weerballonnen, kunnen deze vingerafdruk maar niet ontdekken, terwijl het inmiddels goed meetbaar zou moeten zijn [22, 23]. Voorts worden al de berekeningen natuurlijk ook naast de, niet al te betrouwbare meetgegevens, sinds 1850 gelegd. Aangezien we eigenlijk pas de laatste veertig jaar uit satellietmetingen betrouwbare, mondiale temperatuurgegevens hebben, blijft het sowieso gissen wat in de meetreeksen het effect van CO2 is en wat het natuurlijke klimaateffect. Voetstoots wordt aangenomen dat er over zo’n kortere periode niet, of nauwelijks een natuurlijk klimaatvariatie is. Het is dan ook helemaal niet verwonderlijk dat het gemiddelde van al die klimaatmodellen helemaal niet klopt met de werkelijkheid. In het algemeen lopen de modellen wat je kunt noemen: te warm. Dat geldt zelfs over de periode 1980-2020, het satelliettijdperk waarin we letterlijk alles van het klimaat, ook vanuit de ruimte, hebben gemeten. In die klimaattechnisch gezien korte periode, zitten de modellen gemiddeld al meer dan een factor 1,5 te hoog qua opwarming [24, 25, 26].

We weten hoe de output van de ene stap in de berekening de input voor de volgende berekening is. Het is dan niet moeilijk in te schatten dat we minimaal een fout van een factor vier maken voorde temperatuur in het jaar 2100, en waarschijnlijk groter [18]. In dat licht bezien zijn de alarmerende waardes voor de mondiale temperatuurstijging absoluut onverantwoord om mensen mee bang te maken. Het is niet heel veel beter dan koffiedik kijken, waarbij ik wel degelijk wetenschappelijke bewondering heb voor hoe goed die modellen qua fysica in elkaar zitten. Maar dat verandert niets aan de simpele basisregel van wetenschappelijk werk: als de uitkomst van een model de meetgegevens niet reproduceert, is het model fout. Geen discussie mogelijk.

Bewolking

Een grote onbekende in klimaatmodellen is het effect van bewolking. Wolken hebben zowel een koelend als een opwarmend effect. De afkoelende werking, vooral overdag, komt doordat wolken de zon tegenhouden. De hoeveelheid ingestraald zonlicht die het aardoppervlak bereikt, bepaalt hoe dan ook, hoe warm we het uiteindelijk krijgen. ’s Nachts houden wolken daarentegen juist de uitstraling tegen die voor natuurlijke afkoeling zorgt. Dit is een ingewikkelde balans om diverse redenen. Daarbij spelen bijvoorbeeld de hoogte, de dikte, de uitgebreidheid, de verticale temperatuurverdeling, de druppelgrootte en -verdeling en de hoeveelheid ijskristallen, allemaal een rol.

We weten wel ongeveer hoe een en ander werkt, maar bij lange na niet precies genoeg. Bovendien, de schaal van enkele kilometers waarmee de klimaatberekeningen werken, is simpelweg veel te grof voor realistische wolken. Om dit soort berekeningen te doen, verdeelt men het aardoppervlak in cellen van 30 bij 30 km, of vaak zelfs 100 bij 100 km en men werkt daarin met een soort gemiddelde bewolking; of om de zoveel cellen helemaal geen bewolking. We doen dan net of dat realistisch is. Natuurlijk is dat niet zo, en zelfs NASA geeft dat op een van haar websites [27] volmondig toe. Je moet wel even zoeken tussen alle alarmistische verhalen die ze kennelijk voor hun onderzoeksfinanciering de wereld in moeten slingeren, maar ze schrijven letterlijk dat klimaatmodellen nog wel twee ordes (een factor honderd) beter moeten worden om echt enige(!) voorspellende waarde te krijgen. Voorlopig zijn ze daar nog lang niet.

Via een simpel model, op basis van de seizoensafhankelijke temperaturen, heb ik ooit een schatting gemaakt van de invloed van de bewolking op de temperatuur [28]. Aanleiding was de observatie dat in Nederland de hoeveelheid inkomende zonnestraling in de laatste veertig jaar met wel tien procent was toegenomen. Dat is heel veel extra energie (een zogenoemde forcing) die op aarde terechtkomt, equivalent aan ongeveer acht keer de forcing door een verdubbeling van de CO2-concentratie. Het KNMI stelde in haar klimaatrapportage uit 2014 dat zoiets maar 0,2 graden opwarming opleverde [29]. Mijn schatting kwam tot ongeveer 1 graad en dat zou voor de CO2-gerelateerde opwarming in Nederland maar iets als 0,5 graad overlaten. Dat laatste past dan weer heel goed bij ongeveer 1 graad per verdubbeling van CO2 in de atmosfeer en niet bij het IPCC-verhaal van drie graden of meer, waar ik straks nog uitgebreid op terugkom.

Ik heb over dit onderwerp veelvuldig met het KNMI gecommuniceerd. Ze waren heel welwillend om mij te antwoorden, maar meer dan dat “klimaatmodellen iets heel anders voorspellen”, heb ik nooit te horen gekregen. En waar die 0,2 graden in hun rapport vandaan kwam, wisten ze niet meer. Ik heb om hen te overtuigen, inmiddels op meerdere manieren laten zien dat de klimaatgevoeligheid voor bewolking, ongeveer 0,1 graad per procent bewolkingsverandering moet zijn [30].

Een waarde die, zij het op andere analyses gebaseerd, ook anderen berekenen [31, 32]. De reactie van het KNMI: “… 0,2 graden is misschien toch wat te laag …”.

Ook mondiaal

Verminderde bewolking is trouwens niet alleen in Nederland waargenomen, maar is ook mondiaal, met zo’n 3 tot 4 procent, goed zichtbaar in de satellietmetingen [33]. Echter wel geprononceerder boven Europa en goed zichtbaar sinds het eind van de jaren zeventig [32]. Waarschijnlijk is het een gevolg van het massaal afstappen in veel West-Europese landen van het stoken van kolen, of zelfs turf voor (vooral) verwarming. Engeland sloot bijvoorbeeld zijn mijnen na de vondst van olie in de bodem van de Noordzee, net als Nederland al eerder deed na de vondst van grote voorraden aardgas in Slochteren. Kolenstook geeft niet alleen relatief veel CO2, dat was toen nog niet de reden om ermee te stoppen, maar ook veel aerosolen, zoals fijnstof en zwaveldioxide, in de atmosfeer. Die laatste twee werken beide afkoelend, maar fungeren onder andere ook als condensatiekern voor mist- en wolkenvorming [34, 35]. Kwam je vroeger in Londen dan had je een grote kans, vooral ’s morgens, om in de mist te lopen, met bijbehorende Britse humor: the continent is isolated. Dat overkomt je tegenwoordig nog maar zelden.

Meer zon is dan ook waarschijnlijk mede het gevolg van een veel schonere lucht. En, jammer dan, daar wordt het behoorlijk warmer van, zoals de gemiddelde seizoenstemperaturen ons laten voelen. Die zijn echt gekoppeld aan het aantal zonuren. Zomers zijn daarom veel warmer dan de winters, en zonnige dagen gemiddeld warmer dan bewolkte.

Nu is dit ook weer zo’n typisch voorbeeld van natuurlijke invloeden, hoewel deze vermindering in bewolking in feite ook een menselijke invloed op het klimaat is. Het was precies wat we wilden, alleen de consequentie is dat het warmer is geworden.

In GCM’s kun je het effect van een eventuele verandering in de bewolking door aerosolen als fijnstof en zwaveldioxide, best wel modelleren. Je moet dan wel weten hoe dat precies werkt en van welke andere zaken het afhankelijk is [36]. Men probeert dat er ook echt wel in te stoppen voor het simuleren van de temperaturen in onder andere de vorige eeuw, maar onze kennis van, en modellen voor wolken en wolkenvorming, blijken dan toch te beperkt.

De zon

Een andere, misschien nog wel belangrijkere natuurlijke variabele die niet wordt meegenomen in de modelberekeningen, is onze zon zelf. Dat wij überhaupt bestaan komt omdat de zon uiteindelijk ons klimaat bepaalt. In de klimaatmodellen wordt de zon, afgezien van dag/nacht, de seizoenen en de elliptische aardbaan om de zon, als constante bron van instraling beschouwd. Dat is niet correct.

Sterker nog, de koude Kleine IJstijd [37] wordt toegeschreven aan het zogenoemde Maunder-minimum [38], een periode van vijftig jaar met een heel constante, maar juist weinig actieve zon. De zon kent al sinds mensenheugenis een, ongeveer elfjarige cyclus in zijn activiteit, die tot uitdrukking komt in het aantal zonnevlekken [39]. Onze erkend hete zomers van 1947 en 1959 vielen nagenoeg gelijk met zonnevlekken-maxima, terwijl de Elfstedentocht-jaren veelal samenvielen met zonnevlekken-minima. Die zonnevlekkencycli zijn weer onderdeel van een veel langere cyclus, die maakt dat er periodes zijn van extreem grote verschillen tussen maxima en minimum zoals in de vorige eeuw, of juist nauwelijks verschillen, zoals in de Kleine IJstijd.

Tussen 1800 en 1830 hadden we ook zo’n periode van minimale zonneactiviteit: het Dalton-minimum [40], met onder meer de strenge winter van 1812/13, die Napoleon fataal werd in zijn veldtocht naar Rusland. Volgens astronomen die de zonnecyclus bestuderen, stevenen we weer af op zo’n soort Dalton- of Maunder-minimum rond 2050. En inderdaad, het aantal zonnevlekken in de maxima van deze cycli, nemen sinds de recente hoogste waardes in 1960 en 1980 daadwerkelijk af. Sommige astronomen beschouwen zo’n afkoeling als onvermijdelijk [41, 42].

Tussen 1800 en 1830 hadden we ook zo’n periode van minimale zonneactiviteit: het Dalton-minimum [40], met onder meer de strenge winter van 1812/13, die Napoleon fataal werd in zijn veldtocht naar Rusland. Volgens astronomen die de zonnecyclus bestuderen, stevenen we weer af op zo’n soort Dalton- of Maunder-minimum rond 2050. En inderdaad, het aantal zonnevlekken in de maxima van deze cycli, nemen sinds de recente hoogste waardes in 1960 en 1980 daadwerkelijk af. Sommige astronomen beschouwen zo’n afkoeling als onvermijdelijk [41, 42].

De variaties in uitgestraalde zonne-energie in een zonnecyclus zijn zeker niet verwaarloosbaar, maar misschien ook weer niet zo groot dat daarmee alle huidige opwarming direct kan worden verklaard. Echter, deze zonnecycli zijn qua variaties veel sterker in het hoogenergetische, ultra-violette (UV) deel van het spectrum. UV-straling wordt vooral geabsorbeerd in de ozonlaag en is daarmee heel bepalend voor de temperatuur van de stratosfeer. Ook dat beïnvloedt ons klimaat [42].

En dan is er nog de zogenoemde zonnewind: hoogenergetische deeltjes (of kosmische straling) die ons radioverkeer soms ernstig verstoren. De hoeveelheid zonnewind is sterk gekoppeld aan de zonneactiviteit; wat precies de invloed daarvan op ons klimaat is, weten we nauwelijks. Maar dat het invloed heeft, staat vast en het is waarschijnlijk verre van verwaarloosbaar.

Er is sowieso een rechtstreeks verband tussen kosmische straling en wolkenvorming [41], en dan denk je al gauw aan de eerder beschreven invloed van bewolking op de temperatuur. Hoeveel van de kosmische straling onze atmosfeer binnendringt, wordt onder meer bepaald door het aardmagnetisch veld. Laat de magnetische noordpool zich de laatste decennia nu net met rasse schreden van het noorden van Canada naar Noord-Rusland verplaatsen [43]. Ongetwijfeld met effecten waar we geen idee van hebben, maar dat een en ander ons klimaat beïnvloedt, lijdt geen twijfel.

De geobserveerde, kennelijk natuurlijke variaties in de eeuwen vóór we grootschalig CO2 gingen uitstoten, moeten toch door iets veroorzaakt zijn. De zon is dan de meest aannemelijke factor, gezien de grote energiestromen die daarbij constant op de aarde worden afgevuurd [41, 42].

Klimaatgevoeligheid

CO2 is een broeikasgas, dat is onomstreden. Dat een verhoogde CO2-concentratie iets doet met de gemiddelde temperatuur op aarde, staat ook niet ter discussie. Het waarom laat ik hier dan ook verder onbesproken. Maar of het effect groot genoeg is om de huidige opwarming te verklaren, is op z’n minst twijfelachtig. Niet voor de klimaatalarmisten natuurlijk, maar objectief fysisch bezien, is het te verwachten effect van de CO2-toename simpelweg niet groot genoeg.

Een algemeen gebruikelijke waarde voor de invloed van CO2 op het klimaat, is de ECS, de Equilibrium Climate Sensitivity, die de opwarming in graden Celsius weergeeft bij een verdubbeling van de CO2-concentratie. Impliciet heb ik de klimaatgevoeligheid hierboven al vermeld bij het voorbeeld van de drie graden als gemiddelde uitkomst van de klimaatmodellen bij verdubbeling van CO2-concentratie in de atmosfeer. Het doet er daarbij niet toe of we uitgaan van de pre-industriële concentratie van 280 ppm (parts per million, deeltjes per miljoen) of van de huidige 420 ppm als gevolg van de fossiele brandstoffen die we sindsdien hebben verstookt [44]. Een toename van 280 naar 560 ppm verhoogt de temperatuur evenveel als van 420 naar 840 ppm [45].

Sinds 1979 zijn zowel opwarming als CO2-concentraties consistent gemeten. De klimaatgevoeligheid is daarom ook experimenteel te bepalen uit de opwarming van 0,13 graden per decennium tussen 1980 en 2020 en de bijbehorende CO2-concentraties van 339 en 413 ppm [46]. Eerdere opmerkingen over andere effecten even vergetend en daarmee alle opwarming aan CO2 toekennend zoals het IPCC doet, levert dat een klimaatgevoeligheid op van 1,8 graden [46, 47].

Klimaatmodellen komen gemiddeld bijna op het dubbele uit. Het overgrote deel van de klimaatmodellen kan dus per se niet goed zijn, wat het IPCC ook beweert. Deze discrepantie is zelfs nog veel groter als we kijken naar de opwarming in de periode 1910-1950. Hoewel, zoals eerder opgemerkt, de data daar niet al te betrouwbaar zijn, lijkt de opwarmingssnelheid tussen 1910 en 1945 met 0,15 graad per decennium nagenoeg gelijk aan die in de 21e eeuw (cf Berkely Earth [4]). Alleen was de CO2-toename toen veel kleiner en om dan zo’n temperatuurstijging te bewerkstelligen, is zelfs een ECS van meer dan tien graden nodig [46, 47].

Maar waarom zou het opwarmende effect van CO2 in die twee periodes zo verschillend zijn? De fysica over het gedrag van CO2 kan toch niet veranderd zijn? Het IPCC gebruikt dezelfde historische temperatuurreeksen juist om te bewijzen hoe goed hun modellen zijn. Maar ze leggen niet uit waarom CO2 toen een ruim vijf maal sterker effect vertoonde dan we nu zien. Alleen een significant grote invloed van natuurlijke processen in de opwarming kan dit verklaren; louter CO2 volgens mij dus niet [48].

Heldere hemel

Kijken we puur, dus met alle andere klimaatparameters constant verondersteld, naar het effect (de eerdergenoemde forcing) van een verdubbeling van de CO2-concentratie, dan is iedereen het erover eens, dat dit maximaal 1,1 graden temperatuurstijging kan opleveren. Dit is op basis van een forcing van 3,7 W/m2 bij een verdubbeling van de CO2-concentratie [49]. (W/m2 staat daarbij voor Watt per vierkante meter). Dat is een al decennialang gebruikte waarde. Volgens meer recente berekeningen moet die waarde zo’n twintig procent naar beneden bijgesteld worden tot 3,0 W/m2 [50, 50b]. Dat past ook beter bij de enige, realistisch gemeten waarde uit satellietdata, van ongeveer 2,65 W/m2 [51]. Die laatste zijn beide echter ‘heldere-hemelberekeningen/metingen’, terwijl wolken zeker een deel van het broeikaseffect van CO2 afschermen. Al met al levert dat voor de gemiddeld bewolkte hemel, een pure ECS op van ongeveer 0,8 graden [50b], dus aanzienlijk lager dan de hierboven bepaalde waarde van 1,8 graden. Alleen weten we natuurlijk niet hoe groot het aandeel van extra CO2 in die stijging is, en hoeveel een gevolg van natuurlijke effecten.

Het IPCC hanteert in haar klimaatalarmisme echter een veel grotere ECS met een wel heel ruime range van 2,5 tot 4 graden, met een beste schatting van 3 graden. Die range kent geen harde grenzen, maar is niet helemaal toevallig ook de 95-procent zekerheidsmarge van de berekende temperatuureffecten uit de diverse klimaatmodellen. Het eerdergenoemde gemiddelde van drie graden past dan ook bij de gemiddelde waarde van de ECS volgens het IPCC.

Ze weten het dus echt niet met enige nauwkeurigheid, en wat nog erger is: de grote range is in dertig jaar tijd nauwelijks verkleind. Drie decennia klimaatonderzoek en zes generaties van klimaatmodellen, hebben ons dus geen beter inzicht gegeven in de werking van CO2 binnen ons klimaat. Het gemiddelde, de drie graden, wordt door het IPCC als meest waarschijnlijk gepromoot en verder door bijna iedereen voor zoete koek geslikt. Maar let wel, dat soort waardes zijn ruim drie maal groter dan op basis van de puur fysische eigenschappen van CO2-moleculen eigenlijk kan.

Feedbacks

Hoe verklaart het IPCC dan zijn hoge klimaatgevoeligheden? Daarvoor hebben ze de feedbacks uit de kast gehaald. Eigenlijk een ietwat misleidende term, want we hebben het hier voor de meeste klimaateffecten in feite over feedforwards (meekoppelingen); dit zijn neveneffecten die de primaire oorzaak juist versterken. U kent dat wel, de microfoon die men bij de luidspreker van een geluidsysteem houdt, waarbij beide aangesloten zijn op dezelfde versterker. In oude radiotermen heet dat een Mexicaanse Hond, ofwel rondzingen. Het geluid gaat door merg en been.

Op zich is het best wel een logisch idee: door de opwarming als gevolg van de CO2-toename veranderen niet alleen de temperatuur, maar ook andere eigenschappen van de atmosfeer [30, 52]. Vooral de verdamping van water en daarmee verband houdende zaken als: een extra broeikaseffect door de toegenomen waterdamp en de verandering van de bewolkingsgraad. En door de hogere temperatuur: het smelten van sneeuw en ijs van gletsjers, evenals van de gebieden op en rond de polen. De sterk reflecterende sneeuw die zo verdwijnt, heeft weer als gevolg dat er meer zonlicht wordt geabsorbeerd door de aarde en dat maakt het nog weer warmer. Enzovoort, enzovoort.

Logisch toch? En zeer plausibel. Ook in de 0,8 graden ‘pure’ klimaatgevoeligheid is een dergelijke toename van de hoeveelheid waterdamp door extra opwarming al netjes verdisconteerd [50b].

Afgezien van het feit dat de gemeten vochtigheid in de atmosfeer minder is gestegen dan de temperatuurstijgingen voorspelt [53], rechtvaardigt de logische redenering nog niet zo’n grote factor (drie) in de versterking van het CO2-effect. We hebben met een versterking met een factor drie, eigenlijk helemaal geen CO2 nodig om in een spiraal van voortdurende opwarming terecht te komen. Immers, jaarlijkse variaties van een graad temperatuurverhoging zijn er ook regelmatig zonder CO2-toename. En gaat het een paar jaar achtereen die kant op, dan zou er door de meekoppelingen als gevolg van temperatuurstijgingen, geen houden meer aan zijn; net als de spontaan beginnende Mexicaanse Hond. Omgekeerd zou een tijdelijke afkoeling ons geheid in een nieuwe ijstijd storten. Maar gelukkig, natuurlijke stabiele systemen, zoals het klimaat, reageren veelal juist dempend op variaties die het systeem uit evenwicht brengen. Was dat niet het geval, dan waren wij als mensheid hier helemaal niet, of al lang niet meer geweest. We waren simpelweg weggekookt of juist diepgevroren.

(Wordt vervolgd)

***

Ad Huijser.

Over de auteur

Ad Huijser studeerde Technische Natuurkunde aan de TU Eindhoven (1963-1968). In 1970 trad hij als onderzoeker in dienst van het Philips’ Natuurkundig Laboratorium, en promoveerde in 1979 aan de TU Twente. Na diverse research- en later managementposities in zowel het Philips’ Nat. Lab., de Semiconductor- en Consumer Electronics Divisies, werd hij in 1994 benoemd tot “baas” van het NatLab en in 1998 verantwoordelijk voor de wereldwijde Philips Research organisatie.

Huijser was vanaf 2002 tot zijn pensioen in 2006 lid van de Raad van Bestuur van Koninklijke Philips Electronics en als Chief Technology Officer verantwoordelijk voor alle R&D, Innovatie en het Intellectueel Eigendom.

“Bij toeval kwam ik in de wereld van de klimaatwetenschap terecht toen ik tegen 2010 een lezing bijwoonde van wat je nu een klimaatscepticus zou noemen. Zonder me er echt ooit in verdiept te hebben, twijfelde ik in die tijd geen moment aan de CO2-hypothese. Fysisch bezien immers plausibel, en je neemt dan voetstoots aan dat de betrokken onderzoekers de mate van opwarming als gevolg van broeikassen als CO2 goed berekenen. De betreffende spreker bracht dat beeld toch een beetje aan het wankelen, en als wetenschappelijke “omnivoor” was mijn nieuwsgierigheid gewekt. Daarna zie je al snel dat de “science” verre van “settled” is, en onze kennis van het klimaatsysteem grote gaten vertoont. Het idee dat klimaatmodellen de toekomst kunnen voorspellen blijkt dan niet meer dan een illusie.”

***

Bron Clintel hier.

Voor de voetnoten wordt verwezen naar het origineel.

***

Lang maar goed duidelijk uitgelegd in gewone mensentaal, en niet door de domste jongen van de klas.

Ben benieuwd wat de deugertjes weer af te kraken hebben, want er is natuurlijk maar 1 hypothese, en dat is die van het IPCC met hun duizenden wetenschappers die zich na apen.

https://www.telegraaf.nl/nieuws/1404266063/debat-biomassa-laait-verder-op-nu-australie-stopt-met-duurzame-kap-kaartenhuis-begint-in-elkaar-te-storten

Gisteravond een docu op discovery science over de supervulkaan Campi Flegrei bij Napels. Dus als de klimaathysterici zich ergens druk over zouden moeten maken is het daarover. Niet dat er veel tegen te doen valt, maar de laatste jaren is de temperatuur ervan flink aan het oplopen en dat is een waarschuwing die we ter harte moeten nemen. Niet alleen Napels maar een groot deel van Europa zou wel eens met een enorme aswolk en dus afkoeling te maken kunnen krijgen. Daar is die ene graad geprojecteerde ipcc opwarming niks bij.

https://www.geobronnen.com/monster-van-napels-kan-rond-2020-ontwaken.html

Lang artikel. Maar helemaal juist. Goed onderbouwd.

De toename van het aantal mensen op aarde, inmiddels zijn we de 8 miljard gepasseerd, is natuurlijk een wezenlijk, essentieel probleem. Het doemscenario van de club van Rome voorspelt het einde daarvan zoals het einde van een sprinkhanenplaag. Alles is kaalgevreten en in korte tijd sterft -bijna- iedereen een gruwelijke dood in honger en oorlog.

Ik bestudeer de klimaatproblematiek sinds pakweg het jaar 2000, en zo tot 2015 was ook ik overtuigd van de opwarming van de aarde. Daarna laten de meetgegevens een wending zien, en wordt het steeds duidelijker dat het geheel wordt gedreven door financiële en politieke belangen. De zuiverheid in de discussie verdwijnt volledig. De oplossing die ons worden opgedrongen in de vorm van een energietransitie is verre van realistisch. Zelfs destructief. Dus zelfs als de diagnose juist zou zijn, dan nog zijn de middelen erger dan de kwaal.

“Ze ( CvR) voorspelden dat we qua grondstoffenverbruik aan de grenzen van onze groei waren gekomen.”

FG en dat is precies dat wat we inmiddels steeds vaker ook ervaren tenzij je in je bijna ziekelijke afkeer van die CvR blind bent of steeds weer een andere kant op kijkt.

Verder bevat artikel niets nieuws.

“Maar gelukkig, natuurlijke stabiele systemen, zoals het klimaat, reageren veelal juist dempend op variaties die het systeem uit evenwicht brengen.”

FG idd ook mijn mening waar uiteindelijk in competitie de negatieve feedbacks domineren. Zoiets als het principe van Chatelier.

In trouw een oplossing voor het co2 probleem. De vastlegging in rots waardoor co2 permanent verwijderd wordt uit de atmosfeer. Dit op zulk een grootschalige wijze dat de krant er enthousiast over is. De locatie is Oman. Er wordt met geen woord gerept over de gevolgen van een co2 vrij lucht. Nu groeit er in Oman toch geen plant dus dat zit wel goed

https://www.trouw.nl/duurzaamheid-economie/prijswinnend-bedrijf-wil-co2-op-grote-schaal-omzetten-in-gesteente~b7252e09/

Eab

Uiteindelijk wil eenieder die een mogelijkheid ziet uit de ruim gevulde belastingruif mee-eten

Zeker nu de geesten er middels eenzijdige berichtgeving, rijp voor zijn gemaakt. De groenzand verkoop zal minder goed lopen schat ik zo in.

Prachtige samenvatting.

Meer inhoudelijk mis ik wat klimaatmodellen betreft de vermelding van hun tegenstrijdigheid aan de wetten van fysica en thermodynamica. Twee voorbeelden zijn de wet van Henry en de back radiation. Als klimaatmodellen de wetten van de fysica en thermodynamica die nog steeds niet tegengesproken zijn aan hun laars lappen lijkt het mij logisch dat die nooit sluitende resultaten zullen opleveren.

“…wat klimaatmodellen betreft…”

FG deze zijn volkomen nutteloos want wat je niet weet kan je niet simuleren

Prima verhaal, ik zal het zeker goed bewaren.

Wordt steeds moeilijker om toe tegeven dat we eigenlijk niks weten.

Leuk research Oxford.

https://climatediscussionnexus.com/2022/12/21/by-the-way-we-might-all-be-wrong/?fbclid=IwAR0lZUsE-zjZ631NsrEuntboBwwa1O1bS7AR7jysy43QvrmZBFKAjHKXVQ4

Bron.

https://journals.ametsoc.org/view/journals/clim/35/24/JCLI-D-22-0081.1.xml?tab_body=fulltext-display

Een nieuw debat van alle studies zou zeer wenselijk zijn

Prima verhaal van iemand die gewicht in de schaal legt. Heel anders dan de wetenschappelijke stapeltjes benadering van nuvere Frenske, hoewel die op zijn manier ook een man van gewicht is.

CO2 is eigenlijk een wonderbaarlijk gas. In het NOS-journaal van 28 december werden de weinig besneeuwde skipistes in de Franse Alpen getoond en Peter Kuipers Munneke becommentarieerde dat met de mededeling dat het gebruik van fossiele brandstoffen de oorzaak is van te weinig sneeuw. Vreemd genoeg hebben de USA, Canada en Japan last van zeer hevige sneeuwval. Ergo, CO2 gaat wel erg willekeurig te werk.

Ach als je zoekt naar kale pistes dan ga je die ook wel vinden en dan beweren dat dit het gevolg is van fossiele brandstoffen. Maar we kijken dan ook niet verder als onze Peterneus lang is om het eigen ongelijk te bevestigen. Gemiddelden op aarde, hoe bereken je die dan en kloppen die wel met wat meetbaar is?

Een uitermate helder betoog dat uitstekend duidelijk maakt dat acteren op basis van modellen niet zo verstandig is.

Daarbij zijn de nu in zwang geraakte middelen erger dan de veronderstelde kwaal.

Adapteren op werkelijk gemeten en mogelijk opdoemende risico’s is daarmee het beste wat gedaan kan worden. Angst aanjagen om de beste brave burger met een smoes het geld uit de zakken te kloppen, hoort daar niet bij.

Ik lees in het hele stuk geen nieuwe inzichten. Wetenschappelijk gezien is het stuk daardoor van generlei waarde.

Het is weer typisch een voorbeeld van iemand die zich niet beroepsmatig met de materie heeft beziggehouden, maar het als hobby er even bij doet. Het stuk rammelt aan alle kanten, te veel om op in te gaan, maar onderstaande quotes van Ad Huijser zeggen eigenlijk alles.

“Daarna zie je al snel dat de “science” verre van “settled” is, en onze kennis van het klimaatsysteem grote gaten vertoont.”

Om het epistel te besluiten met:

“Maatregelen gebaseerd op het idee dat we de huidige opwarming kunnen stoppen door het volledig uitbannen van fossiele brandstoffen, zullen dan ook niet het geclaimde resultaat hebben. Dat is een totale, en in dit geval ook uiterst kostbare, ILLUSIE”

Vet gedrukt nog wel. In de eindconclusie blijkt de science van Ad Huijser wél settled. Als je maar lang genoeg doorschrijft verdwijnen de gaten in onze kennis van het klimaatsysteem als vanzelf, als sneeuw voor de zon, zo moet hij gedacht hebben.

Man, man, man Modelzeur toch.

Iedere keer denk ik dat je niet dieper kan zinken in je eigen moeras; maar het is je toch weer gelukt.

Je zou zo bij het FvD kunnen.

AnthonyF, Volgens mij is hij van familie van Timmerfrans, veel lawaai maar er is nog nooit iets zinnigs uit zijn handen gekomen. Het is een goed verhaal. Dat van die CO2 ben ik niet met hem eens. Eerst stijgt de temperatuur en dan de CO2. CO2 lost beter op in koud dan in warm zeewater. Het wordt nu iets warmer en in 90% van de tijd voor onze tijd was het warmer en zat er meer CO2 in de lucht tot wel 7000 ppm. Toen waren er echt geen fabrieken en er bestonden ook nog maar heeel weinig mensen op deze aarde 1 of 2. Dat CO2 een broeikasgas is geloof ik ook nog steeds niet. De enige aandrijvende kracht die we hebben is de zon daar heeft ESA in het begin van het jaar een satelliet naar toe gestuurd. Toen ik vroeg waarom zeiden ze dat ze zo weinig van de zon wisten dan schiet je maar even in de lag. Ik heb inderdaad vastgesteld dat we sinds 1989 meer dan 200 uur zon erbij hebben.

Het IPCC zegt zelf dat je de modellen niet kan gebruiken om te voorspellen en er vooral geen beleid op te bepalen. Maar dat staat natuurlijk niet in de SPM want die wordt misschien door politici gelezen of laten ze lezen want je bent veel te belangrijk om daar je tijd aan te besteden. Trouwens als je de hele dag met twee telefoons in je handen loopt, kan je niets meer vasthouden.

Wanneer komt er van jou een keer een artikel? Een artikel die nu eindelijk eens bewijs komt leveren van die gevestigde klimaatwetenschap graag. We wachten er al meer dan 40 jaar op.

Nu niet helemaal.

“…”Daarna zie je al snel dat de “science” verre van “settled” is, en onze kennis van het klimaatsysteem grote gaten vertoont.”

Om het epistel te besluiten met:

“Maatregelen gebaseerd op het idee dat we de huidige opwarming kunnen stoppen door het volledig uitbannen van fossiele brandstoffen, zullen dan ook niet het geclaimde resultaat hebben. Dat is een totale, en in dit geval ook uiterst kostbare, ILLUSIE”..”

FG science is nooit settled.

Idd de kennis over processen welke klimaatverandering bepalen zijn nog verre van toereikend om middels dus tekortschietende modellen er meer kennis over te verzamelen.

In deze situatie zullen bijna per definitie verwachte (geprojecteerde) resultaten afwijken van hetgeen maatregelen beogen. Zelfs averechtse effecten kunnen niet worden uitgesloten. Om deze reden ben ik bijvoorbeeld ook faliekant tegen elke vorm van geo-engineering.

Ad geeft modellen te veel aandacht. En huidig streven is uiterst kostbaar en inefficiënt en funest voor toch al wankelende economie.

Blijft voor mij open dat de mens mogelijk invloed uitoefent op klimaat maar op welke wijze en in welke mate vereist nog heel veel onderzoek.

Duidelijk is dat mens in aantal en wijze van leven in concurrentie met ander leven onze planeet uitput.

Frans Galjee

De concurrentie is duidelijk. Elk organisme streeft naar zijn aard naar maximalisatie. Afhankelijk van de geboden situatie. Is die uitputting echt een feit, dan sterven we als soort gewoon uit. Dat is al vele malen eerder met andere organismen gebeurd.

Modelleur of wie er voor doorgaat

Waar blijven jouw nieuwe inzichten? Daarmee kom je maar steeds niet af. De enige kreet die ik van je vernam is: “AGW is niet te bewijzen”, maar je wil wel graag actie. Ofwel de klimaatprelaat propageert het voorzorgbeginsel.

Vul de gaten eens op. Of krijg je het niet eens voor elkaar om je geitenwollen sokken te stoppen

@Modelleur 29 dec 2022 om 15:06- Sprak de klimaatexpert.

Ik kan me wel vinden in dit betoog. Ik ben op eenzelfde manier in het onderzoek beland, toevallig eigenlijk, nadat ik vond dat er iets niet klopte met de theorie van meer CO2 die warmte zou veroorzaken. Volgens mij moest die extra warmte in de nacht komen, nml. hogere minimum temperaturen. Dat gebeurde hier rond mij niet….

https://www.climategate.nl/2021/11/een-ongemakkelijke-waarheid-2/

Ad, nou zeg je:

‘CO2 is een broeikasgas, dat is onomstreden. Dat een verhoogde CO2-concentratie iets doet met de gemiddelde temperatuur op aarde, staat ook niet ter discussie. Het waarom laat ik hier dan ook verder onbesproken. Maar of het effect groot genoeg is om de huidige opwarming te verklaren, is op z’n minst twijfelachtig.’

Dat is eigenlijk dom. Ik heb daar wel goed naar gekeken. Er is geen opwarming door meer CO2 aan de atmosfeer toe te voegen. Ik heb dat berekend van de IR spectra van het molecuul zelf. (Klik op mijn naam). Ik zou het erg op prijs stellen als je naar mijn berekeningen zou kijken en er een mening over zou geven?

Inderdaad neemt de zon instraling af. Dat laat alleen de aarde over als een speler in het veld van opwarming.

https://www.climategate.nl/2021/03/de-duizend-jarige-eddy-cyclus/

Het lijkt erop dat de aarde zelf elke duizend jaar een rol speelt.

https://breadonthewater.co.za/2022/03/08/who-or-what-turned-up-the-heat/

Samen met de vergroening, dat het albedo iets veranderd.

Henry

Ik voel wel wat voor die theorie van de Eddy-cyclus. Maar ik heb niet de kennis het te bewijzen. Maar frappant vind ik die warmteperioden wel. Mij lijkt dat CO2 slechts één van de regelende factoren is waarmee de aarde zich thermisch binnen bandbreedten in balans houdt. Uiteraard met waterdamp als de belangrijkste factor om met CO2 en zuurstof het leven in al zijn verschijningsvormen te continueren.

Kijk reactie van mij die onderaan is terecht gekomen.

Peter

Zoals ik zei,

ik vind dus nou dat er geen opwarming komt door meer CO2 in de lucht.

https://breadonthewater.co.za/2022/12/15/an-evaluation-of-the-greenhouse-effect-by-carbon-dioxide/

CO2 en hitte gaan samen omdat meer hitte meer CO2 veroorzaakt. Dat de mens daaraan toevoegt is eigenlijk niet erg belangrijk, behalve dat meer CO2 meer vergroening veroorzaakt, wat het albedo van aarde iets veranderd. Overigens is Ad’s idee dat schonere lucht meer zon instraling veroorzaakt misschien ook wel een factor. Agv zure regen werden er in de 60 en 70 er jaren hard gewerkt on alle zwavel uit de lucht te houden. Dat is wel aardig gelukt.

Waarom denk je dat de afkoeling van aarde sinds zijn wording constant naar beneden is? Het lijkt mij logisch om te denken dat daar piekjes in zitten, naar gelang de ijzeren kern van de aarde zich naar de zon richt. Eddy heeft dan volgens mij iets te maken met (een verandering in) het magnetische veld vd aarde en meer vulkanische acitivteit..

https://www.climategate.nl/2022/08/mondiale-opwarming-hoe-en-waar/

ik zei in een vorige reactie:

‘Dat is dom.’

Sorry voor mijn gebrekkige taalgebruik hier. Ik bedoelde natuurlijk niet dat iemand hier of enigiets van het stuk dom was. Mijn excuses indien dit wel zo door iemand werd opgenomen.

Ik bedoelde te zeggen dat terwijl alles in dit stuk in goede detail werd besproken, het punt over CO2 al dan niet een kweekhuisgas even snel terzijde werd geschoven terwijl ik vind dat juist die discussie over CO2 in het klimaat debat wel kritisch belangrijk is.