Een gastbijdrage van Arjan Duiker.

Een gastbijdrage van Arjan Duiker.

Tijdens de wiskundeles leerde je methoden waarmee wiskundige vraagstukken kunnen worden opgelost. De toetsing beperkte zich niet tot louter een controle op het eindresultaat, maar het antwoord moest tevens worden onderbouwd met een uitwerking. De berekening toont immers aan of de gekozen methodiek geschikt is voor de aanpak van het vraagstuk en bepaalt tevens de nauwkeurigheid die kan worden behaald. Als de student de uitwerking achterwege laat en zich beperkt tot het geven van het eindantwoord, wordt dit terecht met een onvoldoende beoordeeld.

Vanzelfsprekend spelen ook in het naschoolse leven grote belangen om elkaar voldoende transparantie te bieden omtrent wetenschappelijke en technische thema’s. Belanghebbenden moeten zich immers kunnen verzekeren van een juiste aanpak. Maar hier zijn in onze complexe technologische wereld wel een aantal beperkingen ontstaan; snappen we nog wat computers doen en hoe software ze aanstuurt? Een taxatie van de beperkingen blijkt op zichzelf meestal lastig. We verliezen in toenemende mate de grip op controlemogelijkheden omdat rekenwerk binnen een black box plaatsvindt en de aansturende software voor vrijwel niemand toegankelijk is.

In o.m. de industrie is het inmiddels geaccepteerd om voor mechanische, proces technische en andersoortige berekeningen simpelweg te vertrouwen op de toepassing van softwarepakketten, ook voor modellering van dynamische systemen. Een controle beperkt zich dan tot een check op de juiste input en op de juiste instellingen. De corrigerende loop wordt gevormd door de relatief overzienbare tijd tussen theorie en resultaten uit de praktijk.

Elke computerberekening komt via een of andere numerieke wijze tot stand. Maar het fundament onder de software wordt gevormd door wetmatigheden en empirisch opgedane kennis. In de context van fluïdedynamica zijn empirisch bepaalde gereedschappen zoal: de toestandsvergelijkingen in de thermodynamica, Reynoldsgetallen die de mate van turbulentie vaststelt en Stokes-waarden voor de mate van viscositeit. Deze gereedschappen zijn ontwikkeld aan de hand van talloze proeven onder laboratoriumomstandigheden en hebben een duidelijk begrensde en gedefinieerde toepasbaarheid. Ondanks dat een rekenunit met vele malen achter de komma een antwoord kan genereren blijft de werkelijke nauwkeurigheid beperkt tot pakweg een range van 2 tot 15%, afhankelijk van de toepassing.

Hoe zit dat bij klimaatmodellen?

Wie maakt en controleert ze?

Hoe transparant is de werkwijze van de modelbouwers en gebruikers?

In hoeverre zijn ze een voldoende nauwkeurige beschrijving van de werkelijkheid?

Het lijkt een behoorlijk mistige glazen bol.

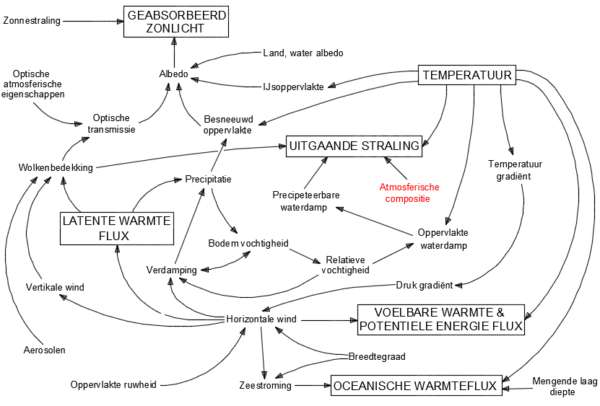

In de eerste plaats is het modelleren van een dergelijk systeem buitengewoon complex en zit vol valkuilen. Onderstaand figuur toont een versimpelde impressie van het klimaatsysteem. Het klimaatsysteem zit boordevol met niet-lineaire processen, heeft twee heel verschillende en turbulente fluïden (lucht en water) die een sterke wisselwerkingen op elkaar hebben en zich op een roterende planeet bevinden. De tijdschaal waarop processen werken varieert van milliseconden tot eeuwen. De drijvende kracht komt van de zon die het oppervlak onevenwichtig opwarmt en dientengevolge resulteert in het feit dat het klimaatsysteem nooit in evenwicht raakt. Kortom, wie durft het aan een beargumenteerde toekomstvoorspelling erover te doen?

Figuur 1: Versimpelde voorstelling van het klimaatsysteem

De in rood aangegeven variabele, de atmosferische compositie, zit op het verdachtenbankje vanwege de toenemende concentratie van CO2, een spoorgas. In de klimaatmodellen krijgt de rol van CO2 derhalve specifieke aandacht.

De atmosferische samenstelling is de afgelopen eeuw met 1/8300ste deel veranderd en al meer dan 40 jaar lang bestaat de veronderstelling dat deze verandering, of een extrapolatie ervan in de toekomst, betekenisvolle klimaatverandering zal gaan opleveren.

De daaropvolgende vraag of deze verandering netto ten gunste uitvalt of juist nadelig uitpakt is een ander thema.

Het directe effect van de CO2-toename is berekend op een jaarlijkse uitstralingsafname van de planeet van zo’n 0,04 W/m2. Anders uitgedrukt is dat een jaarlijks toenemende afwijking van 0,15 promille op de theoretische stralingsbalans. De grote uitdaging is om vast te stellen hoe en in welke mate het klimaatsysteem reageert op deze verstoring; zorgen terugkoppelingen in het systeem voor extra opwarming of dempen ze het effect juist?

Het IPCC legt veel vertrouwen in analyses op basis van klimaatmodellen, kan er rapporten mee volschrijven en hun talloze grafische voorstellingen ogen buitengewoon indrukwekkend en waarheidsgetrouw.

Vaak wordt verondersteld dat de modellen zijn gestoeld op natuurkundige wetten, op zichzelf staande basisprincipes – de zogenaamde first principles – zoals de wetten van Newton of de wet van behoud van energie. En derhalve zou dit de robuustheid van de modellen onderstrepen. Echter, de afstand met de werkelijkheid is groot.

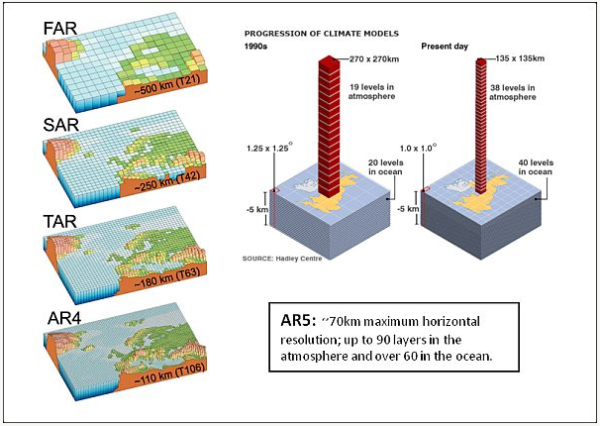

De modellen zijn opgebouwd uit eindige deeltjes die een aaneengesloten geheel vormen waarbinnen de complexe berekeningen plaatsvinden. Zie onderstaande figuur voor een impressie.

Figuur 2: ontwikkeling van de resolutie, van grof naar fijner (grid size).

De resolutie van de modellen is in de loop der jaren verfijnd en dat geeft de indruk dat de nauwkeurigheid is toegenomen. Eerdere modellen hadden een resolutie van zo’n 500 x 500 km, maar inmiddels is dat verfijnd naar een typische waarde van 100 x 100 km of kleiner en tientallen verticale lagen. Typische tijdintervallen zijn in de orde van een half uur. Dat lijkt indrukwekkend maar wat is ervoor nodig om de relevante mechanismen die plaatsvinden in de atmosfeer te kunnen beschrijven op basis van uitsluitend first principles?

In de eerste plaats moet een meer dan honderd jaar oud probleem worden overwonnen; de exacte oplossing voor de Navier-Stokes-vergelijkingen. Dat zijn de partiële differentiaalvergelijkingen die de stroming van gassen en vloeistoffen beschrijven in een 3-dimensionaal veld. Het Clay Mathematics Institute of Cambridge stelt sinds het jaar 2000 een prijs van $1.000.000 in het vooruitzicht voor degene die de oplossing of het bewijs van oplosbaarheid aandraagt. Tot op de dag van vandaag blijft het een onopgelost probleem. Middels numerieke stromingsleer valt om het probleem heen te werken maar het introduceert onder meer instabiliteit; de implicaties om die te reduceren manifesteren zich op verschillende wijze en doen afbreuk aan de nauwkeurigheid.

Vervolgens moet de resolutie naar een niveau worden gebracht waarbij de dissipatie-effecten (door visceus gedrag en inertie) de voortplanting van turbulentie op kleinere schaal voldoende tot stilstand brengt, met referentie naar de Kolmogorov relaties. Voor lucht is die schaalgrootte zo’n 1 mm. Met een dergelijk hoge resolutie en een totale verticale lengte van gesteld 20 km wordt het aantal netwerkcellen, of grid-cellen, in een klimaatmodel: 4pi(6400)2 x 20 x (106)3 = 1,03 x 1028 grid-cellen van 1 mm3

Voorts hebben we voor een honderdjarige voorspelling, op basis van een tijdsinterval van 1 seconde (arbitraire waarde), het volgende aantal tijdstappen nodig: 3600 x 24 x 365 x 100 = 3,15 x 109 tijdstappen per 100 jaar.

Stel het aantal benodigde variabelen op minimaal 10 dan resulteert dat in: 1,03 x 1028 x 3,15 x 109 x 10 = 3,24 x 1038 numerieke waarden die de computer moet verwerken.

Een supercomputer haalt een verwerkingssnelheid van pakweg 50 tera-flops (bewerkingen per seconde) en op jaarbasis is dat: 50 x 1012 x 3600 x 24 x 365 = 1,58 x 1021 flops.

De totale duur van één model-run zou dan vergen: (3,24 x 1038) / (1,58 x 1021) = 2,1 x 1017 jaar, oftewel 15 miljoen maal langer dan de leeftijd van het heelal (voor achtergrond zie Christopher Essex). Zelfs de wet van Moore, een ca. tweejaarlijkse rekencapaciteits-verdubbeling, gaat dat onvoldoende reduceren.

Dit illustreert het kolossale probleem waarmee modelbouwers worden geconfronteerd.

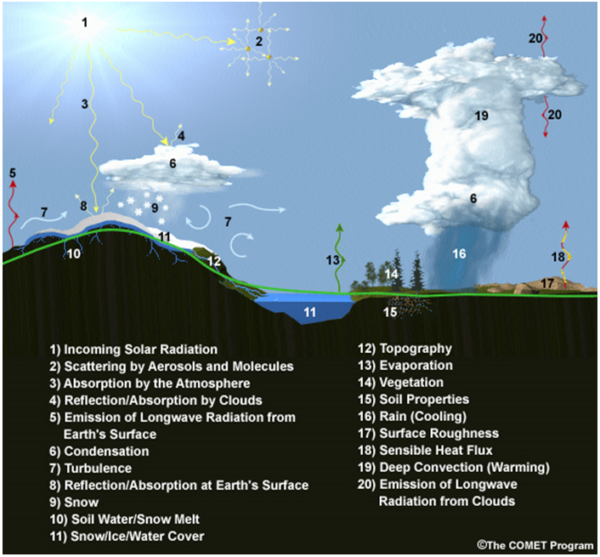

De onvermijdelijke en grote concessies die men moet maken ten aanzien resolutie en tijdsintervallen resulteren in andere uitdagingen. Processen die plaatsvinden op sub-grid niveau (dus binnen elke cel) moeten worden vervat in parameters. Dat zijn vereenvoudigde relaties die een poging doen om de karakteristieke systeemeigenschappen van werkelijke processen te benaderen. Het verwonderlijke is echter dat de schaal waarop dat binnen klimaatmodellen wordt toegepast enorm is, zie het overzicht van de aspecten die veelal worden vastgelegd met parameters in figuur 3. Vrijwel geen enkel klimatologisch fenomeen (component genoemd) ontkomt eraan.

Figuur 3 variabelen die worden uitgedrukt in parameters.

In een aantal gevallen wordt de parameter bepaald aan de hand van meer gedetailleerde sub-modellen. Maar deze zijn ‘blind’ voor elke interactie met de aangrenzende cellen in het hoofdmodel. In veel andere gevallen wordt op basis van observaties aannamen gedaan; de hoeveelheid sneeuwbedekking of de grootte van het wolkendek bijvoorbeeld. Een belangrijk deel van de natuurlijke terugkoppelingen – waarvan we zo graag willen kunnen uitsluiten of ze versterkend dan wel dempend zijn – vindt plaats op sub-grid niveau en deze omgeving wordt aldus gedomineerd door parametrisering.

Parametrisering is in feite een uitweg voor al die fysische processen die nog onvoldoende zijn begrepen of waarvan de beperkingen van een computersysteem versimpeling afdwingen. Klimaatmodellen zijn derhalve in hoge mate en in het beste geval empirische modellen. En hier doet zich één van de onoverkomelijke problemen voor. Het empirisch vaststellen van parameters met de nauwkeurigheid die recht doet aan de doelstelling om effecten van kleine verstoringen te kunnen bepalen, op de schaal van een typische celgrootte, is praktisch onmogelijk. Laboratoriumcondities om bijvoorbeeld het exacte gedrag en de impact van tropische onweerswolken te kunnen analyseren kunnen niet worden bereikt.

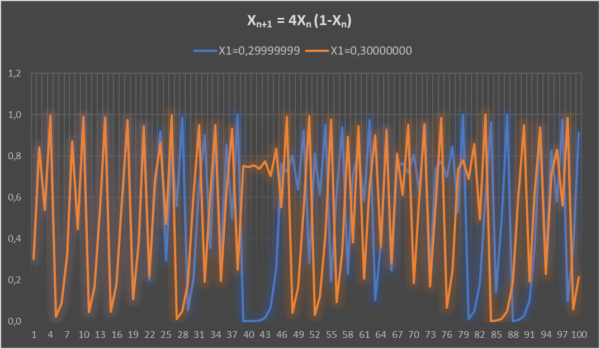

Een tweede onoverkomelijk probleem dat ermee samenhangt is het feit dat het klimaatsysteem inherent en in hoge mate chaotisch is. Een chaotisch systeem laat zich niet modelleren en al zeker niet met een nauwkeurigheid die nodig is om het effect van kleine verstoringen vast te kunnen stellen op een tijdschaal die in dit verband aan de orde is. Een heel simpel voorbeeld (zie figuur 4) die de invloed van minieme verschillen tussen initiële waarden (X1) van een chaotisch systeem doorrekent toont aan dat de responses na een zekere periode totaal verschillend worden. In het voorbeeld lopen de responses tot aan de eerste 25 stappen gelijk op, waarna elke overeenkomst zoek is. Chaotisch gedrag is de hoofdreden van de nog altijd beperkte betrouwbaarheid van weersvoorspellingen verder dan een dag of vijf, ondanks de sterk toegenomen rekenkracht.

Figuur 4 simpel chaotisch systeem.

Hoe gaat de klimaatmodellengemeenschap om met deze ernstige beperkingen?

Een survey van de American Meteorological Society uit 2014 met de titel The Art and Science of Climate Model Tuning geeft een goede indruk van de uitdagingen waarmee modelbouwers zijn geconfronteerd, maar ook van methoden die worden aangegrepen om modellen enigszins een realistische indruk te geven. Modelparameters moeten namelijk op grote schaal worden gekalibreerd, tuning noemt men dat, om de beschrijving van de werkelijkheid te benaderen. Uit het artikel wordt duidelijk dat de modellengemeenschap het ‘tunen’ tot een kunst verheft en dat zelf als zodanig kwalificeert en justificeert.

Uit het Supplement van het artikel wordt duidelijk dat tuning op vrijwel alle modelcomponenten nodig blijkt, maar met name ten aanzien van wolken en stralingsbalans. Modelbouwers zijn als het ware de diskjockeys onder de klimaatwetenschappers. Het is by the way niet erg wetenschappelijk meer. Het volgende citaat uit het artikel suggereert dat er veel trial-and-error aan te pas komt bij het klaarstomen van een model. Met andere woorden ‘probeer maar wat’.

Citaat:

“In general, the parameters are given some a priori values and ideally a range around this value. This information can come from theory, from a back-of-the-envelope estimate, from numerical experiments (tuning an eddy diffusion coefficient from explicit simulations of the turbulent process), or from obser vations (a mean effective cloud droplet for instance). Note that many internal parameters are not directly observable. Given this information, a common prac tice is to adjust the most uncertain parameters that significantly affect key climate metrics.”

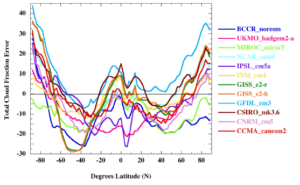

Ter illustratie van de noodzaak om tuning toe te passen is uit het volgende figuur op te maken dat de prestatie van modellen – in dit geval 12 CMIP5 modellen met een run van 1980 tot 2004 – ten aanzien van bewolkingsfractie niet in de buurt komt van de werkelijkheid. De verticale as geeft voor ieder model in procenten weer in welke mate de fractie afwijkt ten opzichte van geobserveerde waarden. De gemiddelde afwijking is 12% ten opzichte van de gemeten mondiale jaarlijkse gemiddelde wolkenfractie uit die periode.

Figuur 5 afwijkingen in gemodelleerde wolkenfracties.

Wat zegt dit nu?

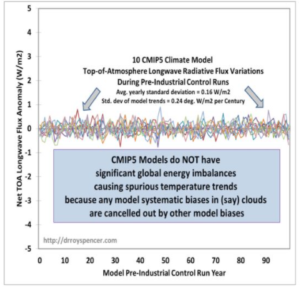

Wolken hebben wereldwijd een netto koelend effect van grofweg 20 W/m2. Een 12% afwijking vertegenwoordigt dan 2,4 W/m2. Klimaatmodellen worden getuned om de stralingsbalans sluitend te krijgen voor alle natuurlijk optredende componenten. Dit wordt onder andere aangetoond met de onderstaande analyse van dr. Roy Spencer op basis van een set aan pre-industriële controle runs over een periode van een eeuw. Het toont geen enkele toe- of afname van uitstralingsintensiteit zolang geen externe forcing (stralings-surplus door bv. antropogene CO2 effecten) aan de orde is!

Figuur 6 Top Of Atmophere afwijkingen van stralingsbalans van pre-industriele controle runs, hindcasts.

In dit voorbeeld (een typisch voorbeeld voor vele modellen) moeten één of meerdere andere variabelen worden getuned om het gat van 2,4 W/m2 te dichten en de stralingsbalans te sluiten. En bedenk, tunen is het opleggen van correcties waarvan geen reële justificatie aanwezig is.

Met de klaarblijkelijke noodzaak om parametrisering en tuning toe te passen wordt de mogelijkheid om het effect van eventuele reële fysisch geïnduceerde terugkoppelingen – van bijvoorbeeld 0,04 W/m2 forcing door CO2 toename – te kunnen analyseren (met numerieke klimaatmodellen) volledig ondermijnd. Het overschaduwt elk potentieel compenserend effect, zoals bijvoorbeeld een toename van het wolkendek met 0,2% op jaarbasis, dat zou kunnen optreden als terugkoppeling.

Klimaatmodellen zijn geprogrammeerd om uitsluitend externe forcing (CO2, vulkaanuitbarstingen, vervuiling, etc.) het effect van opwarming te geven, terwijl zonder deze externe verstoringen alle interne variabiliteit temperatuurneutraal (of beter: energieneutraal) plaatsvindt, op een tijdschaal van decennia.

Het oorzakelijk verband tussen de response van de klimaatmodelcomponenten als collectief en de externe forcing, met betrekking tot de temperatuurontwikkeling, wordt niet en kan niet door het model worden aangetoond. Zeker kwantitatief niet. En hiermee zijn we weer terug bij de ordinaire hypothese die al decennia lang bestaat:

verhoging van CO2-concentratie resulteert in opwarming, opwarming resulteert in een hoger waterdampgehalte en voorts in een waterdamp versterkt broeikaseffect.

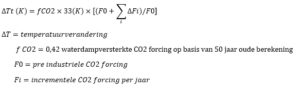

Dit is tot op de dag van vandaag nog onbewezen en leeft voort als hypothese. De complexiteit van de modellen zou in deze context sterk kunnen worden gereduceerd tot het volgende verband, dat bij wijze van spreken de kapstok vormt waaraan de modellen worden opgehangen (zie een recent artikel van Pat Frank). En voor de duidelijkheid: dit is geen fysisch bewezen verband, maar uitsluitend een rekenkundige incrementele toename van het broeikaseffect als ongecorrigeerd effect.

Men kan dus bij wijze van spreken een kwalitatief vergelijkbare projectie maken met een zakjapanner, volgens de gegeven formule. Het levert de vergelijkbare onbetrouwbaarheid op als de omvangrijke modellen. Een model, als representatie van de hypothese en al haar implicaties, heeft pas een voorspellende waarde als het is getoetst aan de praktijk. Daar hoort een omvangrijk validatieproces bij dat in het geval van klimaatonderzoek vele decennia tot eeuwen de tijd zou vergen.

Modelbouwers hebben de opvatting dat het tunen van hun model naar het verleden toe, de zogenaamde hindcasts, de voorspelbaarheid ten goede komt. Echter, met de chaostheorie in gedachte is de respons van het echte klimaatsysteem op de toenmalige omstandigheden uniek geweest. Elke kleine afwijking had een ander klein of groter effect gehad op het verloop. Bovendien leidt het tunen van parameters die een gepasseerde fysische toestand moeten beschrijven tot een slechter voorspellend model, immers; tunen is een overbrugging tussen gemodelleerde output van een desbetreffend modelcomponent, door de parameter, en de werkelijke toestand die op componentniveau helemaal niet bekend was. Zo zijn bijvoorbeeld albedo, relatieve vochtigheid of wolkenbedekking niet in voldoende mate, dan wel geenszins, bekend over de periode van de hindcast.

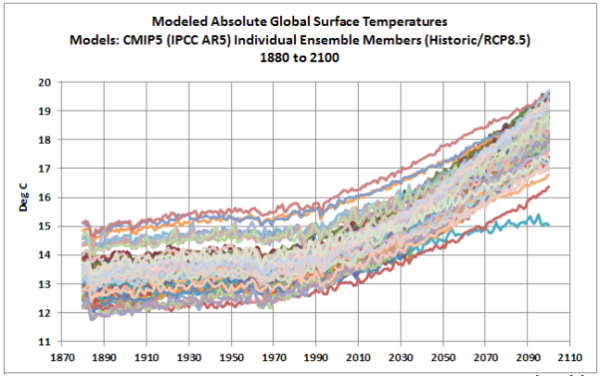

Een volgende aanwijzing waaruit blijkt dat modellen onvoldoende nauwkeurig zijn en zelfs buiten the ball-park presteren, is het gebrek aan waarheidsgetrouwe benadering van een absolute temperatuur (°C in deze context). Een analyse van modelresultaten (uit CMIP5) over de periode 1880 tot 2100 toont een spreiding met een bandbreedte van ruim 3°C, zie figuur 7. Bij een gebruikelijke weergave van temperatuuranomalie ten opzichte van een historische trend, scoort een afzonderlijk model vele malen beter en de samengestelde trend ligt ogenschijnlijk vaak in de buurt van het werkelijke verloop. Maar dat maskeert het feit dat het ene model 15°C berekent terwijl het andere 12°C, voor hetzelfde tijdstip. Het IPCC is er oorverdovend stil over maar het verklapt uiteraard het onvermogen van modellen om de fysische werkelijkheid te benaderen; een antropogeen signaal valt volledig weg in de ruis die de afwijkingen op modelcomponentniveau kennelijk veroorzaken.

Figuur 7 CMIP5 individuele modelruns, bron Bob Tisdale voor WUWT.

Uit het bovenstaande valt af te leiden dat het beschikbare gereedschap, de detailkennis van de fysische wereld en de observationeel verkregen data tekort schieten om voldoende nauwkeurig te kunnen modelleren noch modellen van de juiste input te kunnen voorzien.

Welke strategie volgt de klimaatwetenschap als gemeenschap om dat het hoofd te bieden?

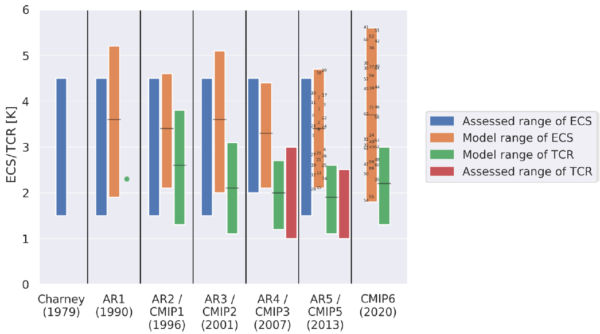

Dat laat zich afleiden aan de ontwikkeling die deze industrie heeft doorgemaakt. In een notendop komt het hierop neer: In 1967 brachten Manabe and Wetherald het eerste rapport uit waarin een schatting werd gegeven voor de zogenaamde Equilibrium Climate Sensitivity, kortweg ECS; een maat voor de uiteindelijke opwarming als gevolg van een verdubbeling van de CO2-concentratie, met 2,4°C als opgegeven waarde. In 1979 werd, in vijf dagen tijd, het Charney Report opgesteld waarbij een ECS-range van 2°- 4,5°C werd opgegeven.

Sindsdien heeft zich een tendens ontwikkeld die een complexiteitstoename en een wetenschappelijke expansiedrift vertoont die de progressieve trend van de meest extreme klimaatscenario’s laat verbleken. Het World Climate Research Programme (WCRP) staat hierin centraal met betrekking tot klimaatwetenschap op basis van modellering. Deze organisatie, net als het IPCC die hun modellen gebruikt, doet niet aan eenvoud. Het programma omvat een groot aantal projecten en nog veel meer afgeleide projecten, elk aangestuurd door een eigen stuurgroep, een globaal en regionaal comité en talloze werknemers. Men verzorgt presentaties, workshops, trainee-ships, organiseert wereldwijd events, vergadert, doet experimenten, ontplooit activiteiten, publiceert en brengt magazines op de markt en newsletters, enzovoorts. En dat allemaal met onvoorstelbare omvang.

Het WCRP regisseert tevens het Coupled Model Intercomparison Project (CMIP). Dat is een gestandaardiseerd protocol voor resultaatanalyses van modellen. Dit jaar zijn voorlopige resultaten van de zesde fase van het project beschikbaar gekomen, CIMP6. Aan het programma werken maar liefst 49 modelling groups mee en zij hebben elk een groot aantal programmeurs en wetenschappers in dienst. Ter ondersteuning van het programma is indrukwekkende lijst aan projecten zijn in het leven geroepen om het CMIP-project zo omvangrijk mogelijk in te richten, met de hoop dat modellen er beter van gaan presteren.

Wat het geheel volstrekt duidelijk maakt is dat er geen sprake meer is van een traditioneel wetenschappelijk veld. Klimaatwetenschap is een complete industrie geworden met een verdienmodel, met eigenbelangen en een ingewikkeld netwerk van financiering en al het andere wat erbij hoort.

Klimaatmodellen worden inmiddels Earth System Models genoemd, wederom indrukwekkend. De bewegingsrichting van de klimaatgemeenschap is zonneklaar: men poogt met een eindeloze hoeveelheid onderzoek en modellering het gehele klimaatsysteem (en ten dele het ecosysteem) tot in de kleinst mogelijke details in een computermodel te vatten, om vervolgens alle kwesties te kunnen duiden en van advies te kunnen voorzien. De totale uitgaven van een halve eeuw aan klimaatonderzoek, overhead, lobby en bureaucratische excessen wordt geraamd op tientallen miljarden dollars. En de hele beweging komt nu pas lekker op stoom. Hou je dus vast…

Maar wat heeft deze ontwikkeling ons vandaag de dag opgeleverd? Onderstaand figuur geeft de klimaatgevoeligheid weer die werd gepubliceerd bij elke mijlpaal in de ontwikkeling van deze wetenschap. En voor de duidelijkheid, dit betreft slechts onderzoek dat door het IPCC wordt beaamd. De teleurstellende waarneming is dat de ECS-range sinds het Charney-rapport zo goed als ongewijzigd is gebleven en zelfs in range is gegroeid! De ECS ligt nu in de enorme range van 1,8° – 5,6°C. De ondergrens van de TCR-range (temperatuurstijging vlak nadat de CO2-verdubbeling is bereikt, ongeveer na 70 jaar op basis van 1% jaarlijkse toename) is 1,3°C; een getal dat in buurt ligt van observationele studies.

Figuur 8 ontwikkeling ECS/TCS waarden (bron).

Welke bescheiden conclusies mogen we nu trekken?

- Een inherent chaotisch en hyper complex systeem is a priori niet succesvol in een voorspellend model te vatten.

- Het gereedschap (de computer), de kennis en de data zijn te gebrekkig om een klimaatmodel te laten werken op basis van de robuuste first principles.

- Modellen leunen voor een belangrijk deel op parametrisering dat vele ‘handmatig’ opgelegde correcties behoeft (dat men tunen noemt, een zelf bestempelde ‘art of climate science’) en dat vervolgens detecteerbaarheid van eventuele reële fysisch geïnduceerde terugkoppelingen, van oorzakelijk verband dus, onmogelijk maakt.

- Verfijning van parameters naar het benodigde niveau vereist een oneindige onderzoeksinspanning en kan vanwege de omvang en schaalgrootte van het klimaatsysteem nooit worden bereikt.

- De beweging naar een voldoende fijnmazige modelstructuur die vertroebeling ten gevolge van parametrisering voorkomt loopt tegen de harde grenzen aan van beschikbare rekenkracht, ook op termijn.

- Dit resulteert in een impasse.

De grote en inmiddels toegenomen ECS-range is zo langzamerhand gênant aan worden. Klimaatmodellen modelleren het klimaat niet. Ze zijn niet en kunnen niet gevalideerd worden. Ze hebben geen, maar dan ook geen enkele, voorspellende waarde als het gaat om de invloed van de mens als gevolg van het gebruik van fossiele brandstoffen. Het IPCC noemt de output van modellen derhalve projecties. Ofwel, we hebben ons best gedaan, we weten het niet maar desondanks presenteren we graag onze modellenrange, het product van onze dure computer. En we willen graag nog een aantal decennia studeren. Mogen wij nu onze rekening indienen!?

Arjan Duiker.

En daarmee roept het een andere invalshoek op die de enorme ECS-range wellicht verklaart. Het biedt het IPCC namelijk de gelegenheid om tegelijkertijd:

- alarmistisch te kunnen blijven of het zelfs te kunnen bekrachtigen;

- de best estimate op vergelijkbaar niveau te houden met voorgaande mijlpalen en daarmee de indruk te wekken dat het een aanscherping betreft, een verbetering;

- de ondergrens in overeenstemming te laten lijken met de observationele getalswaarden, dus men kan later altijd claimen accuraat te zijn geweest;

- de motivering om het onderzoek voort te willen zetten te onderbouwen (want afschalen is natuurlijk tegen het belang van de gemeenschap in).

Maar los van elk klimaatmodelresultaat staat: het interesseert ons geen bal of de IPCC-projecties in overeenstemming zijn met de werkelijke temperatuurtrend, in de tijd vooruit of achteruit bezien. We willen begrijpen of hun aanpak valide is. En alles wijst erop, die is niet valide.

Beste klimaatmodelbouwers: stop vandaag met modelleren, jullie krijgen de modellen wel ingewikkelder, niet betrouwbaarder, bespaar de omvangrijke inzet van kostbare resources, lik je wonden, behoed je voor een complete afgang maar bovenal, herzie je methodiek. Jullie zitten in een impasse.

Dolf van Wijk over de waarheid over wetenschappelijke modellen

Voor een wat andere invalshoek over modellen, zie hier:

“het interesseert ons geen bal of de IPCC-projecties in overeenstemming zijn met de werkelijke temperatuurtrend“

Tsja, schrijf er dan niet zo’n misleidend stuk over. Bespaar je de afgang.

Na 10 jaar snapt Climategate.nl het nog steeds niet. Door onzin te verspreiden kom je er niet. En als je dan eens iets meldt wat er wel toe doet, zoals over de energietransitie, wordt er niet meer geluisterd. Herhaald advies aan Climategate.nl: betere kwaliteitsbewaking, minder stukken en vooral minder onzin.

Bart,

Ook nog iets inhoudelijks te melden?

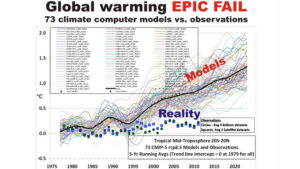

Goed, deze dan. Bovenaan staat een figuur die suggereert dat de opwarming veel minder is dan de modellen voorspelden.

Als je goed kijkt is dat niet van de grondtemperatuur, maar van de Mid Troposphere in de tropen. Dat is het bovenste deel van de tropisfeer met ook nog een stuk stratosfeer. De metingen houden bovendien op in 2010.

In de gewone temperatuurdata, dat is de onderste kilometers van de troposfeer loopt de gemeten temperatuur nauwelijks af van wat er voorspeld werd, het valt ruim binnen de bandbreedte.

Waarom laat Arjan Duiker dat niet zien? Het is hier al heel vaak ter sprake geweest.

De figuur is slechts een illustratie van de divergentie tussen gemeten temperaturen en geprojecteerde temperaturen.

Hij is door mij – en niet Arjan Duiker – als relevante illustratie toegevoegd.

Bart, natuurlijk lopen de modellen te heet, de realisatie sinds 2000 zit in het onderste cohort.

Not all CMIP5 models can be correct

Posted on October 13, 2015 by Clive Best

http://clivebest.com/blog/?p=6868

Re: Bart Vreeken@hetnet.nl 1 nov 2020 om 12:02

Fair point Bart, de details die je beschrijft in de grafiek zijn zeer relevant.

PS. Hier zien we een soortgelijke grafiek van John Christy met zowel de UAH als de HadCRUT4 erin geprojecteerd; de grafiek begint bij het jaar 1983… echter, wanneer we de waarden van de UAH en HadCRUT4 voor het jaar 1986 zouden laten samenvallen met het gemiddelde van de overige grafieken dan wordt het verschil aanzienlijk kleiner, zie:

https://www.drroyspencer.com/wp-content/uploads/CMIP5-90-models-global-Tsfc-vs-obs-thru-2013.png

(Zowel de UAH als de HadCRUT4 blijven op basis van het jaar 1986 wel onder het gemiddelde van de klimaatmodellen bewegen maar het verschil is nihil t/m het einde van de jaren ’90. Echter, op basis van het jaar 1986 ontstaat ook een andere interessant beeld want de grafiek van de UAH en de HadCRUT4 tonen vanaf 1986 een verloop dat in zeer beperkte mate van elkaar afwijkt)

Vul het plaatje van Spencer aan met de hadcrut4 data tot aan nu

(https://www.woodfortrees.org/plot/hadcrut4gl/from:2013/mean:12)

en dan valt de gemeten temperatuur heel aardig binnen het modellen spectrum. Hebben we Arjan daar ook weer mee geholpen.

Het punt is dit: zijn eventuele correcte projecties correct om de juiste reden?

Hoe goed zijn de modellen eigenlijk met El Niño’s?

Dit plaatje geeft vooral zicht op de natuurlijke variabiliteit:

https://www.woodfortrees.org/plot/hadcrut4gl/from:2013/mean:12

Het beeld tussen 1996 en 2020 is overigens veel duidelijker, waarbij moet worden bedacht dat zowel 1998 als 2016 een zeer sterke El Nino hebben getoond terwijl in 2011 er sprake was van een zeer sterke La Nina.

PS. Ellie spreekt over een temperatuurstijging van 0,3 graad C tussen 2013 en 2017… maar de sterke El Nino jaren 1998 en 2016 tonen dezelfde temperatuur stijging van 0,3 graad C in 18 jaar! Gemiddeld komen we dan uit op een temperatuurstijging van ongeveer 0,166 graad C per decennium. Terwijl Ellie in feite de suggestie wekt van omgerekend gemiddeld 0,75 graad C per decennium.

Zie dezelfde grafiek maar dan voor de periode vanaf 1996:

https://www.woodfortrees.org/plot/hadcrut4gl/from:1996/mean:12

Je maakt er een potje van Martijn van Mensvoort. Mijn reactie (ellie 1 nov 2020 om 13:07) betrof een aanvulling op de hadcrut4 reeks in jouw plaatje

http://www.drroyspencer.com/wp-content/uploads/CMIP5-90-models-global-Tsfc-vs-obs-thru-2013.png, waarin hadcrut4 stopt in 2013. Mijn aanvulling betreft de periode 2013-2020 (niet 2017 zoals je abusievelijk meldt). Niets meer, niets minder. Wat je mij vervolgens in de schoenen probeert te schuiven: “Terwijl Ellie in feite de suggestie wekt van omgerekend gemiddeld 0,75 graad C per decennium.” is vrij schandalig. Martijn’s reactie lijkt dan ook vooral bedoeld om mijn bijdrage te ridiculiseren.

Excuus ellie, want dan heb ik je beschrijving inderdaad wellicht helemaal verkeerd begrepen.

(1 nov 2020 om 17:06, je sprak over ‘foppen’ maar met Peter zelf ben je er ook helemaal niet uit te komen – wellicht dat je de materie subjectief bekijkt om je argumentatie duidelijk over te laten komen)

Overigens… 1998 staat bij de UAH dataset nog steeds bekend als het op 1 na warmste jaar; immers, enkel 2016 is na 1998 warmer geweest.

Echter, dit beeld wordt bepaald niet bevestigd in dit plaatje van Roy Spencer (samen met John Christy is hij verantwoordelijk voor de UAH):

http://www.drroyspencer.com/wp-content/uploads/CMIP5-90-models-global-Tsfc-vs-obs-thru-2013.png

(Ben benieuwd of iemand dit kan verklaren)

Dank Martijn voor dit eerlijke en integere antwoord. Peter van Beurden laat zich foppen door alleen te kijken naar hem, uit zekere hoek, voorgeschotelde plaatjes van de tropische mid-troposfeer. De wereld is meer dan de tropen alleen en wij mensen leven aan het aardoppervlak en niet op 500hPa. Jouw plaatje is dus veel representatiever en die heb ik doorgetrokken tot 2020. Je ziet dan dat de waarnemingen prima liggen binnen het modellen spectrum. Maar ja, die plaatjes zien we nooit in sceptische kring …… En dus laten mensen als Peter van Beurden zich foppendoor de cherry-pickers . En velen met hem.

Wat betreft je laatste reactie. Goed opgemerkt! Het lijkt er inderdaad op dat Spencer flink aan de data heeft gesleuteld om alle curves op 0 te laten beginnen. De details weet ik zo niet.

@Martijn om 10:26

Ja Martijn, ik kan dat verklaren.

Deze WFT grafiek (https://www.woodfortrees.org/plot/hadcrut4gl/from:1979/mean:60/every:12/plot/uah5/from:1979/mean:60/offset:0.206/every:12)

geeft je alle info die je nodig hebt om dat te doen.

Succes.

Helder Danny, dank.

Het was mij helemaal ontgaan dat het in die grafieken gaat over het 5-jarig gemiddelde en dus niet over de jaarlijkse waarden.

Heel goed Danny, de 5-jaar middeling wordt inderdaad vermeld in de titel van de figuur. Had ook ik gemist. Duidelijk is dat het ENSO signaal zo wordt weg gefilterd en op deze tijdschalen dan ook geen enkele rol speelt.

De ENSO kent een variabele lengte van 2 tot 7 jaar. Dus in de 5-jarige waarden speelt de ENSO inderdaad nauwelijks meer een rol (afgezien van dat de variabele lengte wel voor enige invloed blijft zorgen maar de impact zal meestal gering blijven – mede doordat het faseverschil tussen de ENSO en de temperatuur hooguit ongeveer 6 maanden bedraagt, waarbij de ENSO voor loopt t.o.v. de temperatuurontwikkeling wereldwijd).

PS. Evenals de relatie tussen de zonnecyclus en de temperatuur niet wordt begrepen kan hetzelfde worden gezegd m.b.t. de invloed van de zon op de ENSO. Met name de amplitude van het temperatuureffect van de ENSO geeft zicht op de invloed van natuurlijke variabiliteit op het niveau van de variaties in de jaarwaarden voor de temperatuur wereldwijd.

Op korte tijdschaal is natuurlijke variabiliteit uiteraard de dominante bron voor temperatuurvariaties

Tussen de begin jaren ’40 en eind jaren ’70 daalde de temperatuur ook onder invloed van natuurlijke variabiliteit.

Kortom, er kan geen scherp onderscheid worden gemaakt m.b.t. de tijdsduur van de invloed van natuurlijke variabiliteit.

Natuurlijke variabiliteit vindt plaats op vele tijdschalen.

Bart Vreeken

Ben je tegen een ongemakkelijke waarheid opgelopen omdat je zo aangebrand reageert?

Beschrijf dus even de onzin i.p.v. het artikel tot onzin te bestempelen vanuit je gedroomde ivoren toren.

Wat een miezerig commentaar, Schrijf zelf een artikel waarin je de deugdelijkheid van de klimaatmodellen onderbouwt en neem daarin dan meteen mee wat er aan de inhoud van dit artikel niet deugt. Ben je bij het KNMI in opleiding voor inquisiteur?

@Peter,

Kende je Bart Vreeken zijn denkwijze dan nog niet?

Ik heb een paar van zulke milieu piefjes gekend die hadden ook zo een karakter.

Ze moesten, ja het tegenovergestelde van we hadden graag iets gehad van u, een stukje land van ons voor een stuk aaneengesloten natuurgebied te verkrijgen, later hoorde ik hoe meer stukken aan elkaar hoe meer subsidie.

Ja ja, dat ging tot dreigen toe (onteigening) nooit gelukt, nooit iets over gehoord na dat ik me duidelijk had uitgesproken, ook heb ik ze nooit meer gezien.

Vraag me af wat in hun kopjes rond spookt.

Theo

Ja, dat is me genoegzaam bekend. Maar desondanks gun ik iedereen zijn mening en blijf ook benieuwd wat iemand voor commentaar heeft op een andere. Behalve als iemand dan komt met: “De experts zeggen het. Blijkbaar zitten ook experts er heel vaak naast. Gezien de vele tegenspraak die er is. En als heel veel mensen en een aantoonbaar belang bij elkaar komen, heb ik toenemende twijfels. Komt daar dan ook nog subsidie aan te pas voor bewezen technieken, dan gaan bij mij de alarmbellen af.

Dan kan het nog steeds waar zijn maar op een ander vlak dubieus. Als de grap niet meer opgaat als de (verdekte)subsidie ophoudt,

dan deugt er iets niet. Klimaat is intussen een verdienmodel geworden. Velen, zo niet iedereen pikt er zijn graantje van mee.

Modellen zijn daarbij een handig hulpmiddel om burgers angst aan te jagen. Terwijl de meerderheid van de burgers er de schouders over ophaalt. Die hebben namelijk héél andere zorgen. Lomborg, Klaus, en Christy laten zich daar regelmatig over uit.

Theo

Ik postte een reactie maar die is merkwaardigerwijze verdwenen of vertraagd?

@Peter,

Ja soms is iets weg, maar HL plaats het meestal wat later er weer op.

Wat Bart Vreeken betreft, als hem hier iets niet bevalt ligt hij gelijk tegen CG te schelden, het deugt hier niet, maar ligt hier wel ieder moment van de dag rond te snuffelen op een forum wat hem niet aanstaat, of als hij de waarheid in pacht heeft, want hij praat immers dat andere onzin schrijven.

Laat HL hem eens een podium plek geven hier, kijken wat hij er van bakt

In begin vond ik hem wel een sympathieke vent, maar nu lijkt hij wel een oude knorren pot.

Mijn advies zou zijn blijf gewoon weg, scheelt in bloeddruk en eventuele hart klachten, of doe normaal tegenover een forum incl beheerder waar je te gast bent, en ook tegen een artikel schrijver.

Tegen mij mag je zoveel schelden als je wilt op mijn komentaren Vreeken.

Arjan Duiker

Ook waardering voor de gekozen verhelderende video.

Vreeken,

Goed stuk Arjan, ik zeg altijd een model is maar een model. Weet je wat het beroerde is maar vreeken heeft dat uitstekend onderbouwd uitgelegd, knap werk Vreeken, we kunnen het weer van overmorgen niet eens voorspellen maar wel het klimaat over 100 jaar. Het hele gebeuren is inderdaad gewoon een businessmodel waar grof geld mee verdiend wordt en meneer All Gore gewoon sturing geeft wat er uit moet komen maar dat heeft vreeken nog niet door. Maar om het nu over klimaat experts te hebben vind ik lachwekkend want die bestaan helemaal niet want het klimaat kan je niet meten maar is de ordinaire uitkomst van een sommetje. CO2 420 PPM maar het echte broeikasgas is waterdamp met 30.000 PPM dus CO2 is 1,4% en dat beinvloedt de warmte op aarde. Dat is net zoals die man die door een bij gestoken was en de dokter hem wilde gaan behandelen met een chemokuur. Die CO2 heeft ook een verzadiging dus tweemaal meer geeft misschien en tempstijging van 0,002 graden. Voor vreeken heb ik met een Excelsheetje uitgerekend. Trouwens ik reken dat klimaat ook met een Excelsheetje uit geen enkel probleem al die onzin ze doen het veel te nauwkeurig dat is de fout want dan krijg je ook grote onnauwkeurigheden en de rekenchips kunnen daar ook slecht tegen want dan worden ze gigantisch onnauwkeurig daar hoor je niemand over de hardware is al ongeschikt.

De uitkomst van het IPCC is dat iedereen belazerd wordt en als we een keer eerlijk worden dan moeten we gewoon zeggen dat we het als mens niet begrijpen maar dat is helemaal niet erg want we kunnen niet alles begrijpen daar schieten wij als mensen volledig te kort. Maar dat geleuter over die CO2 moeten we gewoon een keer mee ophouden want er is helemaal geen probleem dat komt pas al de CO2 daalt onder de 200 PPM want dan gaan we allemaal kapot evenals de plantjes. Dus de ruimte naar boven is veilig maar de ruimte naar beneden is levensgevaarlijk laten we daar ver vanaf blijven. Maar scheikunde 2e klas HBS-b CO2 lost beter op in koud dan in warm water dus eerst wordt het warmer en dan gaat de CO2 omhoog een van de belangrijkste gassen een zgn levensgas en het belangrijkste gas in de koolstofketen. Dus gewoon doorgaan zoals we al jaren deden en gewoon adaptieve maatregelen nemen dat doen we al duizenden jaren dat is het goedkoopste en het beste. Er zijn nog voldoende fossiele brandstoffen ter beschikking voor honderden jaren dus laten we rustig kijken hoe we een geoptimaliseerde Thorium centrale kunnen bouwen en dan langzaam een paar van die dingen bouwen. De toename van CO2 is te vergelijken met het witten van een plafond de eerste laag dekt voor 80%, de tweede laag voor 100%, de derde laag voor 100% de nde laag voor 100% het wordt nooit witter dan wit en dat geldt ook voor CO2 zo simpel is dat. Dus lieve kijkbuis kinderen oogjes dicht en snaveltjes toe.

Op zijn best zijn de geconstrueerde computer CO2-klimaatmodellen slechts een klein beetje beter dan geheel onbruikbaar voor gedegen en effectieve politieke doelstellingen en dito besluitname. Op zijn hoogst zijn de computerklimaatmodellen interessant onder professoren en activisten om gesubsidieerd de dag door te komen.

Als we dat nu genoegszaam weten kunnen we de politiek dwingen / eisen te stoppen met heilloze ideologische klimaatmaatregelen en politiek selectieve subsidies die bedoeld zijn tot het “regelen” van de onmogelijkheid van klimaatbeheersing van een complex klimaatsysteem dat zich kenmerk door een chaotische interactie van zo’n 20 klimaatbepalende cosmische en aardse factoren.

Het enige model dat betrouwbaar, interessant en mooi (oké is subjectief) is een vrouwelijk model.

Logischerwijs is een klimaatmodel bruikbaar waarmee het verleden nauwkeurig kan worden gereconstrueerd.

De kern van mijn analyse draait om de invloed van de zon:

http://klimaatcyclus.nl/klimaat/pics/Figure5.png

(Dit betreft de geupdate illustratie na de eerste ronde in het proces van peer review dat nog steeds voortduurt)

Martijn van Mensvoort,

“Logischerwijs is een klimaatmodel bruikbaar waarmee het verleden nauwkeurig kan worden gereconstrueerd.”

Dat lijkt een logische uitspraak maar is pertinent onjuist. Een klimaatmodel hoeft oscillaties op decennia schaal (AMO/PMO) en korter (ENSO) niet op te nemen. De effecten zijn immers van relatief korte duur en/of middelen uit. Hoofddoel van een klimaatmodel is om de toekomstige structurele verandering te beschrijven.

Annelies, ik ben bekend met je redenering:

“Een klimaatmodel hoeft oscillaties op decennia schaal (AMO/PMO) en korter (ENSO) niet op te nemen.”

Deze redenering wordt veelal (ten onrechte) gehanteerd door klimaatonderzoekers die zowel de invloed van de zon als de bijbehorende multi-decennium oscillatie in de temperatuurontwikkelinge van het toneel willen laten verdwijnen – omdat deze in feite onverenigbaar zijn met de gedachte dat de mens verantwoordelijk zou zijn geweest voor vrijwel de gehele temperatuurstijging sinds 1850.

Cruciaal is dat deze redenering op een soort van aanname berust… die in feite op helemaal niets is gebaseerd want in AR5 figuur SPM.1 zien we dat de oscillatie onmiskenbaar onderdeel vormt van de realiteit, zie:

https://www.ipcc.ch/report/ar5/wg1/summary-for-policymakers/figspm-01/

En dit maakt de relevantie van mijn beschrijving betreffende de bijzonder sterke parallel tussen de activiteit van de zon en de temperatuur ontwikkeling ook direct duidelijk:

http://klimaatcyclus.nl/klimaat/pics/Figure5.png

Oscillatie is inderdaad een onderdeel van de realiteit, maar dat wil nog niet zeggen dat je het verleden in al z’n details volledig moet kunnen reconstrueren om een schatting van de toekomst te kunnen maken. Alle details die op relatief korte tijdschaal plaatsvinden kun je gewoon skippen. Arjan stopt in 2010 met validatie. Jij associeert de structurele opgang van de temperatuur met de zon, maar jouw validatie stopt zelfs al in 1985. Het “tunen” dat Arjan beschrijft is jou ook niet vreemd zie ik.

Beste Annelies, de multi-decennium oscillatie is in dit perspectief wel heel cruciaal.

PS. Ik heb geen idee waarop je dit soort van vrijblijvende uitspraken baseert… maar het klikt opnieuw als niet meer dan een (ongegronde) veronderstelling :

“Oscillatie is inderdaad een onderdeel van de realiteit, maar dat wil nog niet zeggen dat je het verleden in al z’n details volledig moet kunnen reconstrueren om een schatting van de toekomst te kunnen maken.”

(Wanneer een klimaatmodel de multi-decennium oscillatie niet kan reproduceren… dan mag logischerwijs worden verwacht dat de toekomstproject ook geen rekening zal houden met de mogelijkheid dat zo’n oscillatie zich opnieuw kan gaan aandienen – wat in feite bijvoorbeeld in de ‘pause’ tussen 1998 en 2013 ook al is gebeurd. Ook die periode wordt door de meeste klimaatmodellen niet betrouwbaar gereproduceerd; klmiaatonderzoekers proberen om dat probleem heen te lopen door hun aandacht te richten op temperatuur datasets waarin de impact van de ‘pause’ het minst zichtbaar is maar in feite houdt men zichzelf hierbij voor de gek door dit soort van opportunistische keuzes te maken die gemakkelijk kunnen worden herkend als een soort van ‘cherry-picking’ – dit verklaart waarom bijvoorbeeld van Oldenborgh zijn aandacht meestal vrijwel volledig op de GISS dataset heeft gericht in zijn analyses)

Beste Martijn,

Om structurele veranderingen op schalen van orde één of enkele eeuwen te schatten kan men oscillaties op tijdschalen van decades skippen. Die voegen structureel niets toe want zijn gemiddeld nul. Er is dus geen enkele noodzaak voor een klimaatmodel om een toekomstige AMO/PDO/ENSO/hiatus te kunnen voorspellen om toch van voorspellende waarde te zijn.

Vergelijk het met je eigen werk. Jij gebruikt data op een 11-jarige resolutie en niet op een jaarlijkse resolutie, laat staan maandelijkse resolutie (Ps. met middelen verlaag je de resolutie). Data met een hogere tijdsresolutie dan 11 jaar voegt voor jou toch ook niets toe? Die skip je dus gewoon.

Annelies, je spreekt over “oscillaties op tijdschalen van decades”.

Het gaat hier toch echt om oscillaties die meerdere decennia in beslag nemen.

Bovendien hebben we bij de zon ook nog te maken met een oscillatie die zich op een opwaartse helling bevind.

Ik vrees dat je niet echt begrijpt waar ik over praat, want je redenering lijkt enkel principieel van aard zonder enige vorm van onderbouwing,

PS. In mijn artikel (zit nog in de 2de fase van de peer review) heb ik de kwestie in detail beschreven

https://www.essoar.org/doi/10.1002/essoar.10503979.4

http://klimaatcyclus.nl/climate/PDFarticle-revised-after-peer-review.pdf

Annelies, je weet dat ENSO in de CMIP modellen zit?

https://www.nature.com/articles/s41598-018-33340-y

Martijn,

ik zie vooral dat je niet ingaat op mijn eerdere punten van (i) tijdsresolutie, (ii) “tunen” (beide zichtbaar in jouw klimaatcyclus.nl/klimaat/pics/Figure5.png) en (iii) stoppen van je analyse in 1985, toevallig of niet, juist op het moment dat de temperatuur al flink aan de wandel is geraakt en de pas er goed in heeft (juist niet zichtbaar in jouw klimaatcyclus.nl/klimaat/pics/Figure5.png)

@Hans Erren, dat gaat over de mogelijkheid van het simuleren van een fenomeen, niet over het voorspellen ervan. Voor het klimaat van 2100 is het niet interessant of een El Nino in 2050 of 2060 plaats vindt. Daarover hoeft een klimaatmodel zich dus niet druk te maken. De studie is vooral interessant omdat er de laatste jaren stappen zijn gezet met de koppeling van atmosfeer en oceaan modellen en dan maar eens kijken hoe ENSO daar uitkomt.

Re: Annelies “Data met een hogere tijdsresolutie dan 11 jaar voegt voor jou toch ook niets toe? Die skip je dus gewoon.”

Wat bedoel je hiermee precies te zeggen? Wat “skip” ik hier precies in jouw ogen?

PS. In mijn analyse wordt benadrukt dat het noodzakelijk is om de Hale cyclus van de zon (duur: ~22 jaar) in de analyse mee te nemen, echter de analyse wordt wel gemaakt op basis van data die is gebaseerd op individuele jaren.

(Overigens, de term ’tijdsresolutie’ speelt binnen de klimaatwetenschap vooral een rol m.b.t. het verre verleden omdat bij proxies het veelal onmogelijk is om voor individuele jaren een nauwkeurige inschatting te maken; vervolgens krijg we hierbij te maken met relatief grote onzekerheden, etc.)

Martijn van Mensvoort

Volgens mij zegt ook niemand, (ook Arjan niet) dat modellen onbruikbaar zijn, je moet die modellen alleen niet overschatten in hun mogelijkheden.

Daarnaast moet je er dan ook nog de juiste gegevens en interacties in stoppen. Daar ontbreekt het kennelijk aan. Te beginnen bij de veronderstelling dat CO2 werkt zoals men dat veronderstelt.

Voor zover ik het in de loop van de tijd heb kunnen waarnemen, gaat vrijwel iedereen uit van die veronderstelling bij het plegen van onderzoek. Ook vrijwel alle maatregelen zijn op die veronderstelling gebaseerd. Dat lijkt me nogal voorbarig en voornamelijk gebaseerd op paniek,.

Martijn van Mensvoort

“Ook die periode wordt door de meeste klimaatmodellen niet betrouwbaar gereproduceerd; klmiaatonderzoekers proberen om dat probleem heen te lopen door hun aandacht te richten op temperatuur datasets waarin de impact van de ‘pause’ het minst zichtbaar is”.

Leuke zinsnede, doet me denken aan “Hide the decline”.

Peter, zie Arjan Duiker 1 nov 2020 om 12:56:

“Deze beide punten pleiten wat mij betreft om het hoofdstuk modelleren af te sluiten.”

(Deze opmerking lijkt te suggereren dat Arjen in het algemeen weinig vertrouwen heeft in klimaatmodellen; vervolgens lijkt het niet onlogisch om tot de conclusie te komen dat het weinig zin heeft om veel vertrouwen toe te dichten aan klimaatmodellen…. maar daarmee dreigt het kindje wel met het badwater te worden weggespoeld – immers, er zijn ook claims op basis van de zon waarmee een groot deel/het merendeel van de opwarming kan worden verklaard, maar die worden in feite niet in detail besproken in de rapporten van het IPCC)

Gekoppelde klimaatmodellen bestaan al meer dan 20 jaar. Van zo’n klimaatmodel kan niet verwacht worden dat hij de ENSO of AMO één op één simuleert, net zo min als van een weermodel verwacht kan worden dat hij een dag van te voren het precieze tijdstip en locatie van een onweersbui kan voorzien. Maar als zo’n klimaatmodel het optreden van ENSO of AMO niet kan simuleren, is dat model niet goed te initialiseren met meetgegevens die die oscillaties wél bevatten.

Martijn,

We moeten elkaar scherp houden, en dat doe jij ook, dank. Ik neem bij deze het algemene statement terug dat modelleren helemaal geen zin meer heeft (naar mijn bescheiden mening). Maar ik zal het statement als volgt bijschaven:

> modelleren van het klimaatsysteem met als doel om (met name CO2 als) antropogene invloed met voldoende nauwkeurigheid kwantitatief te kunnen vaststellen lijkt (mij) op basis van de verhaallijn van het artikeltje niet meer zinvol. Het blijkt immers al heel lang dat de ECS-range niet convergeert. De de menselijke invloed is uiteraard een aanvulling op de interne variabiliteit van het systeem; een toename van CO2 zal een forcing oproepen, maar daarmee niet noodzakelijkerwijs een temperatuursverhoging veroorzaken. Dat lijkt of blijkt dus niet uit de resultaten van een model te destilleren.

> modelleren van het klimaatsysteem waarbij de focus ligt op externe invloed, zoals variatie in zonne-instraling, is een heel ander verhaal omdat een gemeten of anderszins vastgestelde toename daarvan op enige termijn (en bij wijze van spreken per definitie) een toename van uitgaande straling van het aardse-systeem afdwingt. En dat kan (bijna) alleen maar met een hogere temperatuur. En die kun je best met een zekere nauwkeurigheid modelleren. De secundaire invloeden die voorts binnen het aardse-systeem gaan afspelen zijn weer wat lastiger.

(Dank Arjan, je aanvullende nuance maakt je standpunt helder)

Dirk Visser,

Initialisatie (data assimilatie) speelt alleen bij weermodellen, niet bij klimaatmodellen. Je punt is wel valide voor weermodellen.

Ellie,

De AMO heeft een quasi-periodiciteit van ~70 jaar, een tijdsduur in de orde van de doorrekentijd van een klimaat model. Als een klimaatmodel dat niet kan reproduceren, zou de initialisatie aangepast moeten worden. Voor de ENSO speelt dat in veel mindere mate een rol, die middelt uit over die periode.

Inderdaad Dirk, de gemiddelde bijdrage aan de temperatuur is dus ongeveer 0 over een periode van 70 jaar.

Re: Ellie “Inderdaad Dirk, de gemiddelde bijdrage aan de temperatuur is dus ongeveer 0 over een periode van 70 jaar.”

Na ongeveer 70 jaar is de bijdrage inderdaad ongeveer nul.

Echter in de tussenliggende periode is de bijdrage natuurlijk niet nul.

Daarom kan niet zo maar worden gesteld dat iedere vorm van een cyclische bijdrage in een klimaatmodel buiten beschouwing kan worden gelaten.

(Zonder hiermee overigens te willen suggereren dat iedere cyclische bijdrage van belang is; vooral m.b.t. de zon lijkt het verstandig om rekening te houden met de belangrijkste cycli… maar gek genoeg wordt de belangrijkste – de 22-jarige Hale cyclus – in klimaatmodellen zelden in beschouwing genomen)

Dat kan wel als men geïnteresseerd is in de temperatuurstijging voor de komende 70 jaar, zo richting 2100. De cyclische bijdrage aan de temperatuurstijging is dan 0.

Ellie, Maar wat krijg je als je de cycliciteit van de afgelopen 70 jaar niet meeneemt in de modellen?

@ellie,

Dan moet je er dus wel van uitgegaan dat de opwarming puur en alleen door de co2 komt.

Inderdaad een cyclus komt weer in het gareel als die voorbij is en dan is de bijdrage 0.

Maar stel de 22 jarige cyclus wat Martijn aanhaalt, en laten we eens zeggen die duurt ook 22 jaar, dan zal niet ineens daarna de temperatuur omhoog schieten, dus de komende voorspellingen van temperatuur zullen niet uitkomen als deze cyclus grote invloed zal hebben.

Laat het nu nog een keer aan de co2 liggen, dan kun je zeggen, ze krijgen 22 jaar extra tijd om zinnige dingen uit te vinden, of je kunt zeggen je krijgt een bonus van 22 jaar.

Maar inderdaad daarna is de stijging 0, maar aan de andere kant zijn ze toch zeer geïnteresseerd wat binnen die 70 jaar gebeurd.

Re: ellie 1 nov 2020 om 19:58

Da’s niet meer dan een (speculatieve) redenering m.b.t. een cyclus van ongeveer 70 jaar (AMO).

Het punt is dat er allerlei cycli met verschillende lengtes actief zijn binnen het klimaatsysteem, maar de impact hiervan zal na 70 jaar in principe niet neutraal zijn.

Om deze reden moet je heel goed weten wat je doet voordat deze allemaal buiten beschouwing kunnen worden gelaten.

In het perspectief van het klimaat kunnen cycli in het algemeen dus niet zo maar worden weg geredeneerd wanneer de impact hiervan eigenlijk niet goed wordt begrepen. Maar dit is precies wat sommige klimaatonderzoekers wel doen en daarmee wordt de natuurlijke variabiliteit in feite buitenspel gezet… waarschijnlijk (al dan niet bewust) om vervolgens doelbewust alle aandacht op de antropogene factor te kunnen richten.

Nogmaals, het is cruciaal dat enkel op basis van natuurlijke variabiliteit – waarbij de zon aan de basis ligt – de multidecadale cyclus (die zichtbaar is in het temperatuurverloop sinds de 2de helft van de 19de eeuws) kan worden gereproduceerd. En de impact hiervan is dat wanneer dit fenomeen in beschouwing wordt genomen de meest alarmistische klimaatmodellen min of meer door het ijs zakken… omdat deze de multidecadale cyclus sowieso niet kunnen reproduceren.

De cycli zijn in essentie vooral van belang om het (cyclische) verleden beter te kunnen begrijpen.

Daarna wordt het pas mogelijk om de toekomst bij benadering enigszins betrouwbaar in kaart te zetten… voor zover dit überhaupt mogelijk is.

PS. Het is niet voor niets dat men bij het IPCC in feite al sinds de begin jaren ’90 min of meer gedwongen wordt om de projecties voor de eerst volgende decennia naar beneden bij te stellen; aanvankelijk ging men nog uit van een temperatuurstijging van meer dan +0,3 graad C per decennium maar dit werd in stappen naar beneden geschroefd naar +0,2 graad C per decennium. Tegelijkertijd zijn er geluiden die beweren dat de opwarming steeds sneller zou verlopen… maar deze leiden lijken zich niet bewust van het feit dat de verwachtingen dus juist in de loop der tijd naar beneden moesten worden bijgesteld. Het draait allemaal om geklooi met de getallen, waarbij veelal (schaamteloos) natuurlijke variabiliteit wordt gelabeld als een antropogene invloed. De grootste paniekzaaiers oogsten hierbij niet zelden de meeste aandacht.

@Martijn,

Rustig maar, je kent het gezegde toch, boontje komt om zijn loontje.

Die cyclussen zullen hun werk wel gaan doen zoals ze het altijd al gedaan hebben.

De ingeslagen weg veranderd zo wie zo niet, de maatregelen worden steeds gekker.

Goed dat er Climategate.nl bestaat zodat toch mensen iets op begrijpelijkerwijs informatie op kunnen doen die iets verder kijken dan wat de alarmistische media te bieden heeft, en kunnen naar eigen inzicht er hun voordeel mee doen.

Ik geloof in cyclusen als de maan al een hele zeeën en oceanen in beweging kan zetten waar hebben we het dan over, hoe krachtig is de natuur dan wel niet?

Natuurlijke variabiliteit speelt op korte termijn uiteraard een rol, op lange termijn middelt iedere cyclus uit tot nul. Natuurlijke variabiliteit kan de opwarming van de laatste 40 jaar niet verklaren. Het is niet voor niets dat Martijn’s analyse stopt in 1985. Zie (ellie 1 nov 2020 om 13:07). De modellen doen het best goed, maar alleen met inachtneming van AGW.

Re: ellie “Natuurlijke variabiliteit kan de opwarming van de laatste 40 jaar niet verklaren.”

Niet geheel, maar wel grotendeels.

Immers, het is niet voor niets dat Scafetta in één van zijn publicaties heeft beschreven dat de zon mogelijk verantwoordelijk kan zijn geweest voor 69% van de opwarming tussen 1900 en het jaar 2005 (Scafetta & West, 2008).

(In mijn eigen onderzoek kom ik uit op dat de zon ongeveer 60% van de opwarming kan verklaren tussen 1890 en 2017/2019)

Re: ellie “Natuurlijke variabiliteit speelt op korte termijn uiteraard een rol, op lange termijn middelt iedere cyclus uit tot nul.”

Hiervoor moet je eerst wel weten wat de impact is van een cyclus.

We weten dat het temperatuur effect van tussen een passieve en actieve zon in de orde van 1 tot 2 graad Celsius ligt.

We weten dat rond het Maunder minimum (einde 17de eeuw) de zon extreem passief is geweest.

En we weten dat de zon afgelopen decennia de actiefste periode van de afgelopen 8.000 jaar heeft gehad.

Echter, onder klimaat modelleurs wordt de invloed van de zon nogal eenzijdig ingeschat waardoor met dit perspectief eigenlijk geen rekening wordt gehouden.

Men werkt bijvoorbeeld veelal op basis van aannames dat het temperatuur effect van de 11-jarige zonnecyclus wellicht niet groter is dan 0,02 graad Celsius… terwijl er ook inschattingen beschikbaar zijn die een factor 10 hoger liggen.

Dit verklaard het enorme gat tussen de beschrijvingen van Scafetta (die rekening houdt met dat de zon mogelijk 69% van de opwarming tussen 1900 en 2005 kan verklaren) en de inschatting van het IPCC waarbij de invloed van de zon in feite als ‘nihil’ wordt ingeschat.

(Zo zit het ongeveer als het aan komt op de feiten)

“mogelijk” is net zo iets als: “mogelijk niet”. Ik weet dat een kleine groep wetenschappers natuurlijke variabiliteit als hoofdoorzaak aanwijst voor de huidige opwarming. Die onderzoekers zullen nooit kunnen worden overtuigd van het tegendeel. Anderzijds zijn hun onderzoeken niet overtuigend genoeg om de AGW theorie te marginaliseren. De afname van de zon intensiteit de afgelopen decennia bij oplopende temperaturen werkt duidelijk in hun nadeel.

Zo liggen de feiten.

Al maak je een model nog zo ingewikkeld, de uitkomst wordt bepaald door de input op basis van veronderstellingen. Het is een aardig instrument om beter inzicht te krijgen in gevoeligheden van mogelijke beleidsmaatregelen. Een zg ceteris parabus redenering, zoals economen die hanteren, kan best verhelderend zijn. Om je beleid er op te baseren is onverstandig en zelfs gevaarlijk. Zo zien we dat de voorspellingen van het CPB nog nooit zijn uitgekomen. Dat geldt ook voor de klimaatmodellen.

Recent hebben we kunnen zien waartoe de modellen van meneer Fergenson i.z. Corona leidden..

Maar heerlijk toch om je te kunnen verschuilen achter modellen. Daarom zijn politici er dol op. Zg zeggen zij het niet, maar het model. We zullen de toekomst nooit kunnen voorspellen.

Waak u dus voor deze waarzeggers.

Summa summarum:

Ga naar uw groenteboer en vraag hem hoe hij vindt dat de temperaturen zich ontwikkelen de laatste tijd. Dan krijgt u een antwoord dat oneindig veel nauwkeuriger is dan die van de luchtfietsers uit de toverdoos van het IPCC.

Excellent artikel.

Toch 1 kleine opmerking: Ik verwijs naar “Wolken hebben wereldwijd een netto koelend effect van grofweg 20 W/m2.”

Het IPCC rapport https://www.ipcc.ch/site/assets/uploads/2017/09/WG1AR5_Chapter02_FINAL.pdf geeft de hoeveelheid gereflecteerd zonnelicht door bewolking: dit is gemiddeld 100W/m2. Het koelend effect van de wolken is bijgevolg 5X hoger, dan je vermeldt.

Zoals ik begrijp doet dit geen afbreuk aan jouw stelling.

Prima onderbouwd verhaal betreffende de impasse waar klimaatmodelbouwers in zitten.

Ooit was er lef voor nodig om de toekomst te voorspellen.

De moderne machtige onheilsprofeten schamen zich nergens meer voor en doen voorspellingen die wanneer ze niet uitkomen in ieder geval rampzalige gevolgen hebben voor mens en samenleving ,zoals bij klimaat en nu ook bij Corona.

In figuur vijf is goed te zien dat de modellen het net zo vaak juist hebben als een klok die stilstaat.:-)

Leuk artikel Arjan waarin je de uitdagingen van klimaatmodelleurs netjes uitlegt. Je legt de nadruk op validatie, maar komt boven het artikel aanzetten met een figuur dat zich beperkt tot de tropen en waarin de metingen stoppen in 2010. Dat maakt de rest van je verhaal al direct ongeloofwaardig. Je kunt het nog herstellen door het mondiale plaatje te tonen met validatie t/m recent.

Wat betreft figuur 8 kun je ook zeggen dat de AGW theorie staat als een huis; al 40 jaar lang uiterst stabiel, zonder gekke sprongen die een paradigma verschuiving aankondigen.

ellie

Ik begreep steeds dat het uitkomen van die AGW theorie komt door het handig fijn-tunen van de modellen. Kortom door het naar de uitkomst toe redeneren /tunen.

Dat een betoog door een figuur onderuit wordt gehaald lijkt me wat merkwaardig. Volgens mij geeft die fiuur alleen de veregaande onbetrouwbaarheid van modellen aan. Spaghetti moet je eten, niet in modellen stoppen.

Peter, dat heb je dan verkeerd begrepen. Een figuur is bedoeld ter ondersteuning van het betoog. Arjan legt de nadruk op validatie. Dan is dit niet de juiste figuur. Die heeft hij zich, naar nu blijkt, laten aansmeren. Maar goed, ik heb Arjan een suggestie aangereikt om het beter te doen, dus laten we dat eventjes afwachten.

ellie

Zoals je inmiddels weet in Hans Lebohm verantwoordelijk voor het plaatsen van die afbeelding. Velen zullen de afbeelding, net als ik, slechts gezien hebben als een illustratie van de onbetrouwbaarheid van modellen.

In die zin heeft Hans dat kennelijk goed aangevoeld. Een figuur als ondersteuning van het betoog dat klimaatmodellen grosso modo over een langer tijdstraject dan in dit geval 45 jaar. En dat lijkt me gezien de spaghetti aardig te kloppen.

Peter,

zie (ellie 1 nov 2020 om 13:07). Dat plaatje had men moeten tonen. Nu hebben ze je op het verkeerde been gezet.

@Peter,

Precies, ook zo heb ik dat gezien en weinig waarde aan gehecht omdat de kern van het verhaal er niet over gaat, ik heb dat Martijn net ook al geschreven.

Wat Ellie schrijft, het gaat over een wereldwijde opwarming en dan hebben de modellen een mindere fijn-tuning nodig klopt ook wel, maaaaar er word wel steeds van uitgegaan dat co2 allen de boosdoener is.

En in het verleden is al eens gezegd, oude modellen hadden een prima kloppende voorspelling, ook dat neem ik hun niet af, ze blijven maar sleutelen omdat de modellen te heet zijn.

Daarbij wil ik niet zeggen dat je maar oneindig veel co2 de lucht in moet gaan blazen, maar ik verwacht gezien er in de toekomst een einde komt op grootschalig brandstof verbruik dit op een natuurlijke en democratische manier uitgefaseerd kan worden zonder menselijke dwang zoals TimmerFrans dat nu meent te doen.

Maar goed dit is weer een stukje politiek waar ik steeds in terug val.

ellie

verklaar je nader. Hoezo hebben ze mij op het verkeerde been gezet? Het plaatje maakt prima duidelijk dat metingen uit de pas lopen met modellen.

Heb je een beter vergelijkbaar plaatje kom er dan mee. Het lijkt me geen probleem om dat in je reactie, hiervoor had ook gekund, hierna toe te voegen. Als Link. Dat nou weer wel.

Zolang metingen met modellen uit de pas lopen zijn die hooguit voor intern gebruik om te leren snappen waar en of het met modellen en/of metingen fout gaat.

Peter, nogmaals zie (ellie 1 nov 2020 om 13:07). Is het echt te moeilijk voor je? Hadcrut4 in het plaatje van Spencer eindigt in 2013 zo rond de 0.4 graden. Plak mijn plaatje Hadcrut4 (2013-2017) eraan vast en je zit op ~0.7 graden in 2020. Netjes binnen het modellenspectrum. Je laat je wel makkelijk foppen zeg.

ellie

Als ik naar een vergelijkbaar plaatje vraag, slaat je verwijzing, voor een leek als ik ben, als een tang op een varken.

Graag dezelfde schalen en vergelijkbare model en meetresultaten. Gewoon met vergelijkbare afbeeldingen aantonen dat modellen nu wel correct en vergelijkbaar scoren als metingen.

Ken je de plaatjes van zoek de verschillen? Zoiets dus.

Peter,

als dit al te moeilijk voor je is, houdt het op. Laatste poging. Teken een lichtgroen puntje bij het jaar 2020 (x-as) en 0.7 graden (y-as). Duidelijk?

ellie

Je creëert rookgordijnen. Het lijkt wel een favoriete bezigheid van je, Het geleverde grafiekje plaatje lijkt voor een leek als ik ben in de verste verte niet op een verbeterde versie van het getoonde plaatje waarop je zo’n kritiek had.

(https://www.woodfortrees.org/plot/hadcrut4gl/from:2013/mean:12)

vind je die afbeelding erg lijken op de bovenstaande in het artikel?

Ben jij kippig of ben ik het.

https://twitter.com/zerobuoyancy/status/1171396011203411968/photo/1

Als het over tienden van graden gaat is het verschil tussen 0,7 en 0,4 aanzienlijk te noemen . Zeker als de door Nederland te nemen maatregelen een klimaatwinst van 0,0003 gr C opleveren. Volkskrant en NRC. voor die onzin heb ik zelfs geen digitaal abonnement over.

Peter, iedereen hier heeft het begrepen (ik heb geen klachten ontvangen), alleen jij niet.

ellie, Bedankt voor je reactie.

De nadruk op validatie is één. Dat zal voor klimaatmodellen altijd een enorme drempel blijven want hoe check je of het model in voldoende aantal verschillende gevallen de juiste uitkomst geeft? Dat is in een notendop de essentie van een validatieproces.

Maar daarnaast kun je de vraag stellen, en dat is wat het artikeltje wil meegeven, of de modellen wel genoeg fijnmazigheid in zich hebben om de invloed van een antropogeen (dus klein) signaal überhaupt op een fysisch reële wijze in rekening te kunnen brengen.

Ja, Arjan, juist wél, omdat broeikasgasgassen (GHG) bij uitstek werken op de grote ruimtelijke schalen. Om het mondiale effect van GHG te simuleren heb je dus helemaal geen fijnschalig model nodig. Wil je mondiale effecten downscalen naar lokale effecten, dan heb je uiteraard wél een fijnschaliger model nodig. Ik vrees dat jij dat, wellicht subtiele, verschil niet hebt opgepakt.

Ellie, dat is dus naar het resultaat toe werken: CO2 is goed verdeeld daarom kijken we alleen naar effecten op grote schaal. 3-D klimaatmodellen zijn juist ontwikkeld om meer inzicht te verkrijgen dan wat eenvoudige 1-D modellen bieden.

Dirk, temperatuur, druk, maar ook GHG zijn grootschalige parameters. Die veranderen gemiddeld in de ruimte en tijd veel minder dan kleinschalige parameters als wind, wolken en neerslag. Om die laatste goed op te lossen heb je fijnschaliger modellen nodig dan voor het oplossen van de grootschalige parameters. Daar heeft Arjan geen weet van, blijkt uit zijn verhaal en reacties.

3D (regionale) klimaatmodellen hebben toegevoegde waarde in de vertaalslag van mondiale naar regionale impact, maar dat zei ik al.

ellie

Zou je niet eerst beginnen met aan te wijzen dat de modellen prima in de pas lopen en vervolgens duidelijk maken waar de verschillen uit voorkomen? Of zijn die verschillen er niet?

Uiteraard snap ik dat zich tijdelijk voordoende zaken het beeld kunnen verstoren en zal het elkaar niet naadloos volgen, maar als het geheel over een langere tijd divergeert, terwijl er niet is gefine-tuned, moet het elkaar vrij nauwkeurig volgen. Dat fine-tunen maakt mij erg wantrouwig

Martijn van Mensvoort “fine-tuned” ook, maar dat maakt minder wantrouwig?

ellie

Alle fine-tunen maakt wantrouwig. Behalve als je er gebruik van maakt om te leren. Niet als je er een wereldbevolking en een “beleid” aan ophangt.

Peter, doel van “leren” is om goed te kunnen handelen.

Arjan Duiker

Een prima artikel dat mijn geloof in de feilbaarheid van modellen uitstekend onderbouwd. Dat het kwaliteit heeft is te merken aan de ranzige reacties van de bekende “anders gelovigen”. Ze zijn ten diepste geschokt en trekken als inquisiteurs en strijde.

Hun enige ware geloof zal overwinnen, nog voor het bewezen wordt.

Peter, dank.

Ik denk dat wij en vele anderen de mening delen dat modellen (vooralsnog) onvoldoende betrouwbaar en nauwkeurig zijn om beleid op te baseren. Maar het gebeurt wel….

Goede weergave van de werkelijkheid. Dank.

Geweldig artikel zou de wereld rond moeten gaan.

Ik zie er staan gelijk mensen op hun achterste pootjes te kakelen, ze geloven de computer kerk, een wereld klimaat na bootsen in een computer, ik heb het nog nooit geloofd, en het zal ook nooit gebeuren.

Ze krijgen nog niet eens een tornado gevangen in een computer met al hun data die ze al verzameld hebben.

Vele miljarden ieder jaar verwedden op een fout paard, ieder keer weer opnieuw, en ze zijn geen zak verder.

Maar goed verder heb je er natuurlijk een goed betaalde baan aan, die geef je zo maar niet op, je zou wel gek zijn.

En IPCC kan niet anders, het moet in stand gehouden worden dit nieuwe geloof.

Goed stuk Arjan, geld list en bedrog, goed dat er mensen zijn die dat doorzien.

Theo, mede door de eerste gedateerde figuur is de presentatie verre van overtuigend voor een ieder die het artikel enigszins met een kritische blik bekijkt.

De opmerking van Bart Vreeken (1 nov 2020 om 07:45) is mijns inziens dan ook terecht, want het citaat waar naar wordt gerefereerd betreft in feite duidelijk een uiting van projectie.

Bovendien lijkt het artikel grotendeels geschreven op basis van een greep uit diverse artikelen in de blogosfeer waardoor het artikel weinig overtuigende waarde zal hebben voor de vele lieden die andersgezind zijn dan de beschrijving in de verhaallijn van de auteur, etc.

De lat moet denk ik aanzienlijk hoger worden gelegd om te overtuigen.

(Ik vrees dat de impact van dit type artikel – dat grotendeels steunt op redenering – niet veel verder zal reiken dan een preek voor eigen parochie)

@Martijn,

Voor mij is het heel simpel, een klimaat krijg je niet in een computer, veel te chaotisch.

Een computer is een mechanische machine die je kunt voeren met software, het enige wat ik steeds lees is bijstellen, bijstellen wat er gebeurt heden, en dat bijstellen gebeurd op basis van co2.

Er bestaat nog steeds geen vrij denkende super computer die zelf conclusie kan trekken en observeren, het is nog steeds een mens gemaakte computer, met de intelligentie van wat de mens er zelf instopt, en gebaseerd op co2.

Zitten er bevindingen van jou in verwerkt?

Wat als ze een programma schrijven wat gevoed word met jou bevindingen, ik weet zeker dat ze hem zo kunnen programmeren dat jou bevindingen naar boven komen.

Ze modelleren heden alles, het verleden tot de toekomst, leuk die speeltjes allemaal.

Theo, het probleem zit ‘m natuurlijk niet in het feit dat er gebruik wordt gemaakt van computermodellen; het probleem zit hem in de datasets die in de computermodellen worden ingevoerd… en de datasets die hierbij buiten beschouwing worden gelaten.

Bijvoorbeeld:

Op de website van het KNMI zien we bij de ‘climate explorer’ dat voor de invloed van de zon enkel gebruik wordt gemaakt van datasets (zoals de PMOD en het model van Lean) die voor de laatste decennia een afname in de activiteit van de zon (zie het item ‘Sun’ iets voorbij halverwege de pagina) tonen, zie:

https://climexp.knmi.nl/selectindex.cgi?id=someone%40somewhere&

(De datasets die een toename in de activiteit van de zon op basis van de minima worden dus buiten de analyse gehouden… en we kunnen op 2 vingers natellen dat dit grote impact heeft voor de uitkomst van de modellen omdat juist de ontbrekende modellen houvast bieden voor het ontstaan van de multi-decennium oscillatie, etc.)

@Martijn.

Ik heb je misschien een beetje verkeerd begrepen, maar kijk eens wat onder figuur 1 staat geschreven.

Dit is een versimpeling van het klimaat systeem, hij beschrijft het als een simpel voorbeeld waar het een beetje om gaat.

En dat bevindingen van jou en nog vele anderen buiten beschouwing worden gelaten is me duidelijk.

Het is me ook duidelijk waarom zulke bevindingen buiten beschouwing worden gelaten.

Simpelweg omdat het niet in hun systeem past en de boel nog complexer word, want ook dat moet dan weer op een geloofwaardig manier boven de co2 theorie getoverd worden, zo simpel is het.

Modellen zitten meestal te hoog, hoe komt dat?

Software matig worden ze weer omlaag bij gesteld, en niks kun bewijzen in die modellen, oftewel onderscheid maken tussen broeikasgassen en natuurlijke invloeden, simpelweg al omdat het er niet inzit en omdat ze het niet weten.

Waarom is er een MWP geweest, en hoe is die ontstaan en precies verlopen, en zijn daar sluitende modellen voor, nee dat is ook gissen en aannames.

En voor de rest ben ik het helemaal met je eens voor zover ik dat kan beoordelen.

Martijn, bedankt voor je reacties.

Wat het artikel zeggen wil zijn twee dingen:

1. Meerdere componenten (zo noemt men die blijkbaar binnen de modelgemeenschap) die in de modellen zijn opgenomen blijken in absolute zin 1 of 2 ordes van grootte meer af te wijken dan de grootte van een antropogeen signaal. Als voorbeeld is de afwijking op de stralingsbalans van een foutieve wolkenfractie genomen, maar had ook ander component kunnen zijn. Dan wordt het dus lastig om een oorzakelijk verband van enige terugkoppeling uit de modelresultaten te filteren. De resolutie is gewoon niet fijn genoeg.

2. Ondanks dat de rekenkracht en alle andere inspanningen zijn toegenomen blijft de klimaatgevoeligheidsrange onverminderd groot, zelfs over een periode van 40 jaar.

Deze beide punten pleiten wat mij betreft om het hoofdstuk modelleren af te sluiten. Men slaagt er kennelijk niet in om de nauwkeurigheid te vergroten. En, er is kennelijk een andere aanpak nodig om wel meer accuraat te bepalen wat onze invloed is. Bijvoorbeeld een omvangrijker meetprogramma i.o.d.

Dank voor je toelichting Arjan.

De complexiteit van het klimaatsysteem vormt mijns inziens vooral een uitdaging. Uit je woorden maak ik op dat je vooral een pleidooi hebt gepresenteerd om “het hoofdstuk modelleren af te sluiten”; dit lijkt mij in het perspectief van de complexiteit nogal voorbarig.

(Ik hoop dat je beseft dat er wel degelijk klimaatmodellen beschikbaar zijn waarmee het temperatuurverloop sinds de 2de helft van de 19de eeuw wel degelijk redelijk nauwkeurig kan worden gereproduceerd. In mijn eigen artikelen heb ik naast mij eigen analyse hiervoor veelvuldig gewezen naar het werk van o.a. Nicola Scafetta en Nir Shaviv, waarin een belangrijke rol is weggelegd voor een grote invloed van de zon – welke in de klimaatmodellen van het IPCC in feite buiten beeld wordt gehouden op basis van aannames waarbij weinig ruimte resteert voor de invloed van natuurlijke variabiliteit)

Martijn van Mensvoort

Dan was het van de nogal zure reageerders beter geweest als zij naar een zo vergelijkbaar mogelijke afbeelding zouden hebben verwezen die de redenering van Arjan totaal, of grotendeels ontkracht.

Nu komt het bij mij over als bewust spijkers zoeken op laag water. Waaruit blijkt dan dat de grafieken waar zij in hun testen graag naar verwijzen, maar die ze niet leveren, dat die aantonen dat modellen over langere termijn wel voorspellende waarde hebben. Op die voorspellingen zijn nog steeds de maatregelen gebaseerd.

Een ander woord voor voorspellingen, bijv projecties, gaat niet helpen. Voor de politiek zijn het namelijk voorspellingen.

Martijn van Mensvoort

Integendeel. Voor mij is het een samenhangend betoog. Ik weet dat jij graag verwijst naar peerreviewd artikelen. Voor mij doen die eerder afbreuk aan een samenhangend betoog. Die peerreviewd artikelen is eventueel mooi als ondersteuning of verdieping.

Een leek als ik kan dar niks of weinig mee.

Het leidt alleen maar af en deze site lijkt mij bedoeld om een tegenwicht te vormen tegen de golf van propaganda voortkomende uit het merendeel van de MSM.

Ook jargon en allerlei afkortingen moeten zoveel mogelijk worden vermeden. Geef mij dus maar een samenhangend verhaal/redenering. Iemand die meent dat er fouten of hiaten in zitten, kan dat dan begrijpelijk onder woorden trachten te brengen.

Conclusie: op het zielige gezeur van Bart na, zie ik een overweldigende consensus, zowel op deze site als in de echte wetenschappelijke wereld daarbuiten, dat modellen maar zeer beperkt bruikbaar zijn. Hoofdregel daarbij is: Rubbish in = rubbish out.

Onze nitwit alpha’s zullen dit natuurlijk ontkennen. Zo heeft Timmerfrans op zijn smartphone een rekenmachientje waarmee hij zeer nauwkeurig kan uitrekenen dat als zijn salaris van 400.000 euro wordt verhoogd met 10%, dat het dan 440.000 euro wordt. Dus wat zeuren jullie nu over de onbetrouwbaarheid van modellen.

Hedenochtend even naar de boulangerie gereden voor verse croissants. Net als gisteren windstil en dikke mist, dus molentjes en paneeltjes leveren niets op.

Gelukkig staan hier overal enorme accu’s en waterstoffabrieken, dus we hebben nog stroom (sarc).

Vreeken met verkeerde been uit bed gestapt? Een vreemde uitglijder is zijn scheld reactie. Normaal blijf ik zijn reacties lezen, echter na deze staat hij met een voet in de trollenbak.

“Bespaar je de afgang“ geldt vandaag juist voor Vreeken.

Mijn eerdere reactie gaat over de doodlopende straat van de huidige energie- en klimaatpolitiek, die zich een afgang kan besparen door geheel te stoppen met heilloos en effectloos CO2-klimaatbeheersingsbeleid met biomassa, E-cars, waterstof-“economie” , van het gas los, immer van fossiel afhankelijke wind en zonne-energie en met een ban op R&D naar kernenergie.

Mijn reactie naar Arjan Duiker was wellicht te scherp. Het was vooral gebaseerd op de figuur onder de titel, maar die bleek dus door Hans Labohm te zijn toegevoegd. Daarmee worden de lezers direct op het verkeerde been gezet.

Toch had er natuurlijk wel zo’n figuur bij moeten staan, maar dan met de juiste data.

Henk Lankamp maakt op de weersite Weerwoord.be maandelijks een overzicht van de trend op wereldniveau, gebaseerd op het gemiddelde van de belangrijkste datasets. Het 10-jarig gemiddelde laat een doorlopende lijn omhoog zien. Het 30-jarig gemiddelde (hier niet weergegeven) laat een nog strakkere lijn zijn, Hoe duidelijk wil je het hebben?

https://www.weerwoord.be/m/2651126

De opeenvolgende klimaatmodellen presteren daarmee stukken beter dan de mensen die rond 2009 een komende afkoeling verwachtten, op basis van verminderde zonkracht. Daar kwam niks van terecht. Hooguit vonden we het verwachte effect terug in de ‘hiatus’, en in de iets achterblijvende opwarming.

Vattenfalls verkoopslogan “What is happening to the climate? ” is gebaseerd op dit soort modellen.